Актуальные темы

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Meta

Ветеран Gamefi

Инвестиции и инвестиции в первичные и вторичные проекты

🏅Соучредитель @Opensky_888

🏅 Основные члены @InFuture_Web3

С тех пор как @0G_labs и Web3Labs запустили глобальный акселератор 0G, множество стартапов по всему миру представили свои проекты. Хотя отобранные проекты пока не были объявлены, все с нетерпением ждут Демо-дня, который состоится 29 августа в Гонконге. Общей чертой этих заявленных проектов является глубокая интеграция с технологическим стеком 0G.

Некоторые ключевые области, которые стали приоритетом для 0G 🎯

1️⃣ Предсказательные рынки на основе ИИ

Традиционные предсказательные рынки, такие как Polymarket, по-прежнему зависят от ручного создания и спорных механизмов решения, в то время как эти новые проекты исследуют сети предсказаний, которые могут самоулучшаться, и многомодельные механизмы решения. Один из проектов даже разрабатывает новую модель, связывающую веру с ценой, в сочетании с созданием рынка на основе ИИ и проверкой результатов.

2️⃣ Нативные торговые платформы на основе ИИ

Это не просто добавление функций ИИ к существующим DeFi платформам, а создание с нуля среды выполнения, нативной для ИИ-агентов. Некоторые проекты используют динамическую интеграцию потоков данных между рынками с помощью MCP, чтобы система могла постоянно адаптироваться к изменяющимся рыночным условиям.

3️⃣ Токенизированные ИИ-агенты/умные NFT

Стандарт ERC-7857 iNFT от 0G делает возможным создание, владение, обучение и монетизацию ИИ-агентов на блокчейне. В настоящее время несколько проектов исследуют рынок потребительских ИИ-агентов и услуги, полностью управляемые торгуемыми iNFT.

4️⃣ Децентрализованная наука

Проекты DeSci в основном сосредоточены на сочетании ИИ с правами собственности на данные и их хранением, что идеально соответствует модулю хранения 0G и ценностям ИИ как общественного блага.

@0G_labs как первый нативный ИИ L1 предоставляет недостающую инфраструктуру для полного внедрения ИИ в блокчейн через модульную архитектуру, проверяемое рассуждение и специализированный уровень выполнения для ИИ.

Из этих сигналов видно, что строители ищут технологическую основу, позволяющую агентам, моделям и данным работать без доверия, и что совместимость является стандартной характеристикой. Это совпадает с концепцией дизайна 0G.

23,66K

Все больше людей начинают осознавать, что AI переживает "жесткий форк". С того, что раньше пытались сделать "большую модель", постепенно переходят к более специализированным "профессиональным моделям". Пять причин, упомянутых в твите @OpenledgerHQ, отражают выбор, который делает вся отрасль.

С точки зрения практического применения, универсальный AI подобен универсальному инструменту, который может делать все, но не делает ничего хорошо. Специализированный AI, с другой стороны, представляет собой решения, адаптированные для конкретных сценариев.

🎯 Целенаправленное решение проблем

Специализированные AI модели глубоко оптимизированы для конкретных областей. AI не нужно обрабатывать нерелевантные данные и сценарии, вся вычислительная мощность и параметры сосредоточены на решении проблемы в вертикальной области. Такой фокус приводит к экспоненциальному улучшению.

🔍 Объяснимость становится необходимостью

В таких высокорисковых сценариях, как финансы, нельзя полагаться только на черный ящик для получения ответов. Регуляторные требования, требования к соблюдению норм, определение ответственности — все это требует, чтобы каждый шаг рассуждений AI можно было отслеживать и проверять. Специализированные модели могут быть разработаны с учетом соответствующих путей принятия решений для конкретных сценариев.

⛓️ Проверка на блокчейне и механизмы доверия

Технология блокчейн позволяет навсегда записывать и проверять процесс рассуждений AI. Специализированный AI в сочетании с блокчейн-доказательствами может создать полную цепочку доверия. Каждое рассуждение, каждый узел принятия решений можно отследить, что является необходимостью для предприятий, которым требуется аудит и соблюдение норм.

📊 Решение проблемы иллюзий

Иллюзии универсального AI в значительной степени возникают из-за сложности и разнообразия обучающих данных. Специализированный AI может значительно снизить уровень иллюзий, ограничив диапазон и качество обучающих данных. В вертикальных областях качество данных контролируемо, границы знаний ясны, и модели легче давать точные и надежные ответы.

💰 Переоценка стоимости

Хотя универсальный AI кажется решением всех проблем с одной моделью, фактические затраты на развертывание очень высоки. Специализированный AI может достичь лучших результатов с меньшими масштабами модели, затраты на рассуждения ниже, а развертывание более гибкое.

Пять пунктов, предложенных @OpenledgerHQ, на самом деле являются ответом на реальные потребности отрасли. Это не просто борьба за маршруты, это выбор между эффективностью и осуществимостью. Большие модели представляют собой исследование, специализированные модели представляют собой индустриализацию.

А такие команды, как Openledger, которые работают над инфраструктурой на блокчейне, вероятно, станут нижним звеном этой волны изменений.

35,69K

Вчера послушал AMA @anoma, и у меня сложилось впечатление, что anoma действительно движется быстро.

С самого начала строительства anoma до ежедневного тестирования в тестовой сети, время пролетело так быстро, от волнения по поводу ожидаемого TGE до нынешнего спокойствия. Даже немного грустно расставаться с тестовой сетью, которая вот-вот завершится.

Вчера также была запущена новая игра "слот-машина", я думал, что, как и в предыдущих играх, будет использоваться Fitcoin в качестве фишек. Неожиданно в итоге выбрали Points.

Как известно, общее количество Points определяет рейтинг, и важность рейтинга подчеркивается вознаграждениями в тестовой сети. Я на самом деле довольно неудачливый человек, вчера только что начал играть и сразу потерял 100000 Points, в результате, естественно, не вернул свои деньги. Говорят, что главный приз может составить 1000000 Points.

Сегодня, после успешной игры, общий счет составляет 5560000, а рейтинг около 500. Собираюсь рискнуть 100 маленькими шарами, посмотрим, что из этого выйдет!

После завершения игры общий счет составил 5790000 Points, а рейтинг 427. По сравнению с игрой на 100 маленьких шарах, я получил в общей сложности 230000 Points. В среднем каждый маленький шар принес 2300 Points.

В настоящее время в тестовой сети было выдано около 25000 кодов, официально ожидается выдача 30000. Все еще 5000 находятся в статусе невыданных. Попасть в первую 500-ку — это примерно 2% от тестовой сети. Но, честно говоря, когда я нажимал на 100 маленьких шаров, я действительно хотел "управлять намерением". Сказал ему, что хочу нажать на 100 маленьких шаров, и у меня от этого затекла голова🤣

Кроме того, помимо взаимодействия с тестовой сетью @anoma, не забудьте каждый день следить за обновлениями, и если у вас есть вклад, вы можете каждую среду подавать доказательства вклада в DC. Роль в Dc также должна быть в снимке позже, не забудьте забрать, если будет возможность. Еще один важный момент — это NFT, обязательно найдите способ их получить. Надеюсь, что в конечном итоге все смогут получить большой результат!

40,02K

Многие люди, когда говорят об AI, представляют себе большие модели LLM, интеллектуальные вопросы и ответы, дорожные карты AGI, но на самом деле очень мало кто осознает одну вещь: в будущем основное поле битвы за ценность AI, вероятно, будет не в самой модели, а в контенте, который она потребляет, то есть в IP.

В настоящее время оценка глобальной экономики IP составляет 61,9 триллиона долларов. Но проблема в том, что такие огромные ресурсы контента в основном заперты в куче контрактов, централизованных платформ, правовых рамок и закрытых систем. AI, чтобы использовать их, должен пройти через множество препятствий и может наткнуться на мину.

Поэтому большинство современных AI моделей могут лишь тайком собирать данные. Статьи, изображения, звуки, видео в Интернете все тихо используются для обучения моделей. Но такой подход, с учетом нарастающих проблем с авторскими правами, блокировками платформ и увеличением числа судебных исков, в основном уже не может продолжаться.

У @campnetworkxyz ясная мысль: не блокировать, не красть, а позволить IP быть на блокчейне, превратив его в программируемый актив, который можно легально комбинировать и прозрачно лицензировать.

Это и есть самое основное в Camp. Не создание какой-то платформы для контента AI, а прямое построение набора базовых протоколов и инфраструктуры, позволяющей всем создателям и владельцам IP регистрировать свой контент на блокчейне, четко прописывать условия лицензирования и определять способы распределения доходов. Если модели AI нужно использовать, то просто платите по условиям.

Ключевое в том, что весь этот процесс является комбинируемым. В будущем модели AI не будут собирать данные в огромной черной коробке, а будут свободно комбинировать авторизованные контентные модули, как конструктор, в зависимости от различных источников контента, назначения и стиля. И все это начинается с того, что каждый IP будет на блокчейне с установленными условиями лицензирования и логикой доходов.

Это имеет огромное значение, потому что оно меняет отношение AI и IP с пассивного извлечения и эксплуатации на равноправное сотрудничество. Создатели больше не являются жертвами плагиата, а становятся поставщиками для обучения AI и участниками коммерческой выгоды.

Я также очень согласен с мнением @campnetworkxyz, что "самый большой рынок, который AI затронет, это IP". Модель, какой бы сильной она ни была, должна питаться данными. Сколько бы контента ни было, если его не использовать в соответствии с правилами, рано или поздно это приведет к проблемам.

41,14K

Многие говорят о торговых инструментах, что они должны быть быстрее, дешевле и более плавными. Но если вы часто торгуете на нескольких цепочках, особенно между Solana, ETH, Base и BSC, вы поймете, что говорить об этом легко, а на самом деле сделать это практически невозможно.

@LABtrade_ по сути хочет создать инфраструктурный уровень для многосетевой торговли. Вы можете использовать любое торговое программное обеспечение, но с большей скоростью, меньшими комиссиями и более мощными функциями. Эта идея довольно умная, она не заставляет пользователей менять свои привычки, а оптимизирует базовый уровень. Судя по данным, за 20 дней объем торгов составил 150 миллионов долларов, а доход — 700 тысяч долларов, что довольно впечатляет.

LAB предлагает четыре продукта: торговый бот, приложение, боковую панель и браузерное расширение. Эти инструменты могут бесшовно работать на любом торговом терминале. Не нужно менять платформу, не нужно заново привыкать к интерфейсу, просто наслаждайтесь большей скоростью и меньшими комиссиями в знакомой вам среде.

С точки зрения бизнес-логики, LAB захватил очень практичную боль. Когда люди занимаются торговлей на цепочке, их больше всего беспокоят высокие комиссии, медленная скорость и сложные операции. Комиссии традиционных DEX начинаются с 1%, и нужно ждать подтверждения, что действительно не очень удобно. LAB снизил комиссию до 0,5%, и при этом нет порога объема торгов, что очень привлекательно для розничных инвесторов.

Что касается состава инвесторов, то Lemniscap является ведущим инвестором, а Animoca, OKX Ventures и Mirana — известные учреждения в этой сфере. Этот инвестиционный портфель выглядит довольно надежно, по крайней мере, это говорит о том, что проект прошел проверку в институтах.

С технической точки зрения, LAB уже поддерживает такие основные цепочки, как Solana, Ethereum, Base и BSC. Поддержка нескольких цепочек в нынешней разрозненной экосистеме действительно является необходимостью, пользователям не нужно постоянно переключать кошельки и инструменты между разными цепочками.

В целом, идея проекта LAB довольно хороша, она захватывает реальные потребности пользователей, а данные показывают неплохие результаты. Но сможет ли он устоять в условиях жесткой конкуренции, еще предстоит проверить временем. Для тех, кто хочет участвовать, рекомендуется сначала попробовать небольшую сумму, чтобы оценить продукт, а затем решить, стоит ли углубляться.

34,71K

Сегодня @OpenledgerHQ запустила свою мини-игру Octoman. Я думал, что просто поиграю, чтобы убить время, но как только начал, не смог остановиться. Основная механика игры заключается в том, чтобы управлять осьминогом, который качается в воздухе, стараясь пролететь как можно дальше, но именно эта простая механика делает игру затягивающей.

Суть игры — это Timing Timing Timing!!!

Логика управления в игре не сложная: на телефоне всего две кнопки направления и одна кнопка для стрельбы паутиной, а на компьютере можно обойтись тремя клавишами WAD. Но чтобы действительно хорошо играть в эту игру, ключевым моментом является понимание ритма физического движка. Когда отпустить паутину, когда снова схватиться — если ты освоишь этот тайминг, ты сможешь летать в воздухе далеко и стабильно.

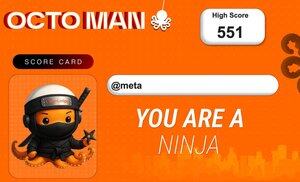

Интересно, что каждый раз, когда ты обновляешь свой личный рекорд, система автоматически генерирует специальную карточку с результатом. Эта карточка не просто так сделана, а в зависимости от твоего счета открываются персонажи разной редкости. Чем выше счет, тем редче персонаж, и такой дизайн действительно побуждает тебя постоянно обновлять свои рекорды.

Сейчас они проводят двухдневное мероприятие, правила очень простые. Ты просто публикуешь свою карточку с результатом в Твиттере, отмечаешь @OpenledgerHQ и добавляешь хештег #iloveplayingoctoman. Видно, что они хотят, чтобы игроки действительно участвовали.

С точки зрения дизайна продукта, Octoman сделан довольно умно. Игра сама по себе достаточно проста, любой может начать играть, но чтобы хорошо играть, нужны практика и навыки. Система карточек с результатами дает игрокам повод похвастаться, а распространение в социальных сетях может привлечь новых пользователей.

Я сам немного поиграл и набрал 551 очко. Мне сразу дали маленького ниндзя-осьминога! Это изображение просто идеально подходит к моему аватару. Не собираюсь больше пытаться, оставлю так. Обожаю это!!!

22,68K

Reddit официально запретил Internet Archive собирать контент для обучения ИИ. На первый взгляд, это обычная мера по защите данных платформы, но за этим скрывается основная проблема всей экономики ИИ.

Текущая ситуация такова, что компаниям ИИ нужны огромные объемы качественных данных для обучения моделей, но контентные платформы и создатели не получают никакой награды за этот процесс. Трудно созданный контент бесплатно используется компаниями ИИ для обучения, а затем крупные компании зарабатывают на обученных моделях, не выплачивая создателям ни копейки.

Все больше платформ начинают устанавливать барьеры, и запрет Reddit на Internet Archive — это только начало. Проблема в том, что простой запрет не решает основную проблему; он лишь ограничивает доступ, не создавая разумного механизма лицензирования и распределения доходов.

На самом деле необходимо создать инфраструктуру, которая позволит на уровне дизайна обеспечить соблюдение условий использования, прав собственности и авторских отчислений.

Camp предложил новый подход: вместо запрета лучше переосмыслить правила использования данных для обучения ИИ. Основная логика на самом деле очень проста:

1️⃣ Контент регистрируется в блокчейне, есть доказательства источника

2️⃣ Создатели сами определяют условия лицензирования

3️⃣ Если ИИ хочет использовать, он должен заплатить

4️⃣ Авторские отчисления автоматически возвращаются создателям

Основная логика: вместо того чтобы запрещать ИИ использовать контент, лучше согласовать интересы всех сторон. Компаниям ИИ нужны данные, создателям нужны доходы, платформам нужна экосистемная ценность — все получают то, что им нужно.

На данный момент на @campnetworkxyz уже зарегистрировано более 1,5 миллиона творений, не только изображения и музыка, но и видео, нарративный контент и так далее, что уже стало децентрализованной базой данных оригинальных ИП. Для моделей ИИ это легальный, устойчивый и масштабируемый источник данных. Для создателей это, наконец, способ избежать бесплатного использования их труда.

35,98K

Сотрудничество IQ AI и NEAR основано на том, чтобы AI-агенты могли самостоятельно выполнять кросс-чейн операции без человеческого вмешательства.

С технической точки зрения, скорость блокировки @NEARProtocol в 600 мс и подтверждение за 1,2 секунды действительно достаточно быстро. Для AI-агентов время ожидания должно быть как можно короче, ведь скорость принятия решений AI изначально быстрее человеческой. Если нужно ждать определенное время для выполнения, то вся эффективность оказывается относительно низкой. Сейчас эта скорость позволяет практически обеспечить мгновенный отклик.

Ранее кросс-чейн операции были достаточно сложными для обычных пользователей, не говоря уже о том, чтобы позволить AI-агентам обрабатывать различные логики мостов. Теперь, благодаря прямой интеграции в инструменты разработки, AI-агенты могут самостоятельно выполнять кросс-чейн операции, что невольно снижает порог входа.

С стратегической точки зрения, это захват инфраструктурной позиции в AI-экономике. Сейчас популярность AI-агентов растет, но на самом деле инфраструктуры, позволяющие AI-агентам напрямую получать доступ к торговому слою и участвовать в экономических активностях на блокчейне, пока еще немного. NEAR укрепил свою позицию как L1 инфраструктуры для искусственного интеллекта и агентов благодаря этому сотрудничеству.

На самом деле потребности AI-агентов и пользователей отличаются. Люди могут терпеть сложные операционные процессы, могут ждать время подтверждения, могут вручную обрабатывать различные исключительные ситуации. Но AI-агенты нуждаются в стандартизированной, автоматизированной и высокоэффективной среде выполнения.

С точки зрения применения, выполнение кросс-чейн транзакций действительно очень полезно. Если AI-агент может одновременно отслеживать арбитражные возможности на нескольких цепях и автоматически выполнять кросс-чейн арбитраж после обнаружения возможности, весь процесс не требует участия пользователя, и на самом деле возможностей для арбитража гораздо больше, чем операций, выполняемых пользователями. Если также можно учесть совместную работу нескольких агентов, это может привести к созданию еще большей ценности.

Для NEAR это отличная дифференциация. В то время как множество L1 конкурируют за TPS и экосистему, сотрудничая с @IQAICOM и сосредоточившись на вертикальной области AI-агентов, раннее накопление базы имеет большое значение для будущего.

NEAR Protocol13 авг., 21:06

Токенизированные ИИ-агенты больше не являются научной фантастикой. Новая интеграция @IQAICOM с NEAR открывает автономные кросс-цепочные действия, которые быстры, окончательны и безопасны.

Вот как выглядит абстракция цепи в действии.

7,3K

Только что увидел, что @boundless_xyz вчера опубликовали подробное описание ZK Coin. Как человек, который всегда следит за этим проектом, мне это кажется довольно интересным. В конце концов, они хотят создать универсальную инфраструктуру для ZK-доказательств.

Во-первых, сам проект Boundless. Он по сути разрабатывает универсальный протокол ZK-доказательств, позволяя всем блокчейнам использовать возможности ZK. Если сейчас каждая цепочка будет строить свою систему ZK-доказательств, это не только дорого, но и неэффективно. Boundless предоставляет услуги ZK-доказательств для каждой цепочки через независимую сеть узлов-доказателей. Это можно также просто понять как аутсорсинг вычислений.

Способы расширения намного проще и грубее, чем существующие решения на основе шардирования или layer2, так как они напрямую увеличивают количество узлов для повышения пропускной способности всей сети.

ZK Coin, как родной токен этой системы, не является чисто управленческим токеном. Каждый запрос на доказательство требует залога ZKC в качестве обеспечения, причем он должен составлять как минимум в 10 раз больше максимальной комиссии. Это означает, что с увеличением объема использования сети заблокированные ZKC также будут расти в несколько раз, что напрямую уменьшает обращающуюся эмиссию.

Существует также механизм проверяемого доказательства работы PoVW, который по сути позволяет узлам-доказателям зарабатывать ZKC, генерируя ZK-доказательства. Но для участия в майнинге необходимо сначала заложить определенное количество ZKC. Это создает положительный цикл: больше запросов на доказательства → больше ZKC заложено → лучшие стимулы производительности → больше узлов участвует.

Что касается распределения токенов, 49% выделено на развитие экосистемы. Но если внимательно посмотреть на логику распределения, 31% экосистемного фонда в основном используется для трех направлений: финансирование проверяемых приложений, интеграция протоколов и инструменты разработки, поддержка протоколов и разработка инфраструктуры. 18% стратегического фонда роста специально предназначены для интеграции с предприятиями и узлами-доказателями на уровне организаций. Такой способ распределения показывает, что действительно строится экосистема.

Команда и ранние участники получают 23,5%, из которых 3,5% специально выделены RISC Zero для будущего найма и исследований. Этот момент подчеркивает глубокую связь между Boundless и RISC Zero, а RISC Zero действительно имеет значительный опыт в области zkVM.

Продажа токенов для сообщества и аирдроп составляют всего 6%, что не так уж и много. Однако учитывая, что это проект инфраструктуры, этот процент кажется разумным. Просто не знаю, сколько Yapper сможет получить в дальнейшем.

Распределение для инвесторов составляет 21,5%, механизм блокировки такой же, как и у команды: 1 год заморозки, затем 2 года линейного освобождения. Такой дизайн гарантирует, что интересы ранних инвесторов и команды связаны, и не произойдет ситуации, когда после запуска токены будут сброшены.

Механизм инфляции в первый год составляет 7%, затем постепенно снижается до 3% начиная с 8-го года. Но ключевым моментом является то, что каждый запрос на доказательство требует залога ZKC, фактическое обращение будет сокращаться с увеличением объема использования сети. Плюс 50% от залога, который будет срезан, будет напрямую уничтожен, что создает балансирующий механизм инфляции и дефляции.

Лично я вижу два основных момента в @boundless_xyz:

1️⃣ Это не ZK, предназначенный для какой-то конкретной цепочки, а действительно желание создать универсальную ZK-инфраструктуру для всех цепочек. Выбранное направление действительно является необходимым, технологии ZK в области блокчейнов будут применяться все шире и станут незаменимым основанием.

2️⃣ Дизайн токена напрямую связан с бизнес-требованиями. Чем больше доказательств, тем больше ZKC заморожено, спрос на токены и использование сети линейно связаны.

46,11K

Вчера я увидел две группы данных для сравнения, и это действительно было довольно интересно. Хочу поделиться с вами. Это данные Story и Camp, хотя я понимаю, что это сравнение может быть не совсем точным, ведь одна сеть — это основная, а другая — тестовая, но данные Camp действительно выглядят неплохо.

1️⃣ Данные Story Protocol

7,6 миллиона блоков

43,7 миллиона транзакций

4 миллиона адресов

192 тысячи транзакций в день

Время создания блока — 2,4 секунды

2️⃣ Данные тестовой сети Camp

16,2 миллиона блоков

84,9 миллиона транзакций

6,6 миллиона адресов

842 тысячи транзакций в день

Время создания блока — 0,9 секунды

Судя по данным, @campnetworkxyz на этапе тестовой сети уже превзошел основную сеть Story по нескольким параметрам. Количество блоков более чем в два раза больше, объем транзакций близок к двум, количество адресов также имеет явное преимущество, а ежедневный объем транзакций достиг более чем в четыре раза превышающего Story.

Story только что запустил основную сеть, в то время как Camp все еще находится на этапе тестирования, поэтому отношение и поведение пользователей, безусловно, различаются. Пользователи тестовой сети, возможно, более склонны к частым взаимодействиям, так как нет давления со стороны Gas. Но эти цифры, отражающие активность пользователей и способность сети обрабатывать данные, действительно довольно убедительны.

Архитектурный дизайн @campnetworkxyz действительно имеет некоторые уникальные особенности. Протокол Proof of Provenance не только занимается правами на интеллектуальную собственность, но и, похоже, строит систему обмена ценностями между ИИ и создателями. Пользователи могут регистрировать свой контент как интеллектуальную собственность, а затем, когда ИИ использует эти данные для обучения или генерации контента, создатели могут получать соответствующее распределение доходов.

Эта модель действительно имеет свою уникальную ценность на фоне текущего массового потребления данных для обучения ИИ. Особенно с учетом того, что высококачественные обучающие данные становятся все более дефицитными, механизм Camp, позволяющий пользователям активно вносить данные и получать за это вознаграждение, может стать еще более важным.

С технической точки зрения, время создания блока Camp в 0,9 секунды действительно значительно быстрее, чем 2,4 секунды у Story. Это преимущество в производительности будет очень полезно при обработке большого количества регистраций и транзакций по правам на интеллектуальную собственность. Кроме того, они поддерживают регистрацию интеллектуальной собственности без газа, что снижает барьер для обычных пользователей.

Camp все еще находится на этапе тестирования, и судя по этим данным, после запуска основной сети это определенно будет проектом, на который стоит обратить внимание. Особенно в направлении сочетания ИИ и интеллектуальной собственности, ожидаем прорыва от Camp.

35,89K

Топ

Рейтинг

Избранное

В тренде ончейн

В тренде в Х

Самые инвестируемые

Наиболее известные