热门话题

#

Bonk 生态迷因币展现强韧势头

#

有消息称 Pump.fun 计划 40 亿估值发币,引发市场猜测

#

Solana 新代币发射平台 Boop.Fun 风头正劲

Meta

Gamefi资深玩家

一二级项目投研、投资

🏅Co-founder @Opensky_888

🏅 Core Members @InFuture_Web3

自从@0G_labs 和Web3Labs推出0G全球加速器以来,全球有很多初创团队提交了自己的项目。虽然入选的项目目前还没有公布,但大家都在期待8月29日在香港举行的Demo day。这些申请项目的共同点是都在围绕0G的技术栈进行深度整合。

一些关键领域,已成为0G关注的方向🎯

1️⃣AI驱动的预测市场

传统预测市场像Polymarket还在依赖人工创建和有争议的解决机制,而这些新项目正在探索自我改进的预言机网络和多模型解决机制。有个项目甚至在开发将信念与价格链接的新模型,配合AI驱动的市场创建和结果验证。

2️⃣原生AI交易平台

并不是在现有的DeFi平台上加AI功能,而是从头构建为AI Agent原生的执行环境。有项目在用MCP动态整合跨市场数据流,让系统能持续适应变化的市场条件。

3️⃣代币化AI智能体/智能NFT

0G的ERC-7857 iNFT标准让链上AI智能体的创建、拥有、训练和货币化成为可能。现在有多个项目在探索从消费级智能体市场到完全由可交易iNFT驱动的服务。

4️⃣去中心化科学

DeSci项目主要聚焦在AI与数据所有权和存储的结合,这正好契合0G的存储应用模块和AI作为公共产品的价值观。

@0G_labs 作为首个AI原生的L1,通过模块化架构、可验证推理、AI专用执行层,提供了将AI完全上链的缺失基础设施。

从这些信号可以看出,构建者们正在寻找一个技术基础,让智能体、模型和数据能够无需信任地运作,并且可组合性是默认特性。这与0G的设计理念不谋而合。

23.66K

越来越多的人开始意识到 AI 正在经历“硬分叉”。从过去什么都想做的“大模型”,慢慢转向更专注的“专业型模型”。 @OpenledgerHQ 推文提到的五个原因,背后是整个行业都在做的选择题。

从实际应用层面看,通用AI就像是万能工具,什么都能做,但什么都做不精。而专业化AI则是为特定场景量身定制的解决方案。

🎯 针对性解决问题

专业化AI模型是为特定领域深度优化的。AI不需要处理无关的数据和场景,所有的算力和参数都专注于解决一个垂直领域的问题。这种专注带来的效果是指数级的提升。

🔍 可解释性成为刚需

在金融这类高风险场景,不能只依靠黑盒给到答案。监管要求、合规需求、责任认定,都需要AI的每一步推理过程都能被追溯和验证。专业化模型可以针对特定场景设计对应的决策路径。

⛓️ 链上验证与信任机制

区块链技术让AI的推理过程可以被永久记录和验证。专业化AI配合链上存证,可以构建完整的信任链条。每一次推理、每一个决策节点都有迹可循,对于需要审计和合规的企业场景来说是刚需。

📊 解决幻觉问题

通用AI的幻觉很大程度来自于训练数据的复杂性和多样性。专业化AI通过限定训练数据的范围和质量,可以显著降低幻觉率。在垂直领域,数据质量可控,知识边界清晰,模型更容易给出准确可靠的答案。

💰 成本效益的重新计算

虽然通用AI看起来一个模型可以解决所有问题,但实际部署成本极高。专业化AI可以用更小的模型规模达到更好的效果,推理成本更低,部署更灵活。

@OpenledgerHQ 提出这五点背后,其实是对行业真实需求的回应。这不只是路线之争,更是效率与可落地性的选择。大模型代表的是探索,专业模型代表的是产业化。

而 Openledger 这样在链上基础设施上布局的团队,很可能就是这波变革的下游基建商。

35.69K

昨天听完 @anoma 的AMA,感觉anoma也是真的快了。

从最开始建设anoma到每天去测试网踩自行车

感觉时间过得好快,从之前期待TGE的激动,到现在的平静。甚至对即将结束的测试网,有点恋恋不舍。

昨晚也是推出了新的游戏“老虎机”,原以为和之前的游戏一样会使用Fitcoin作为游戏的筹码。没想到最终竟然选择了Points。

众所周知Points的总量决定了Ranking的排名,而测试网明牌奖励的驱使下Ranking的重要性不言而喻。我其实是挺背的那种人,昨天刚上线赌性大发,直接梭没了10万Points,结果自然是没有回本。据说大奖还能拿100万Points。

今天梭哈成功后,总积分在556万,排名在500名左右。准备梭哈100个小球,看看怎么个事儿!

梭哈结束,总计Points为579万,排名为427名。对比梭哈100个小球前,共计获得23万Points。平均每个小球获得2300Points。

目前测试网总计发出Code25000个左右,官方预计发出30000个。仍有5000个属于未发送的状态。跻身进到前500,差不多是测试网前2%。不过说实话点100个小球的时候,我是真的想“意图驱动”。告诉它我想点100个小球,给我点的头皮发麻🤣

除了 @anoma 测试网的交互记得每天去跟进外,记得如果有贡献可以每周三去DC提交贡献证明。Dc role后期应该也会在快照内,有机会一定记得拿。还有一个需要注意的点是NFT,一定要想办法获得。希望大家最终都能拿到大结果!

40.02K

很多人提到 AI 的时候,脑子里都是LLM大模型、智能问答、AGI 路线图,但其实很少人真正意识到一件事:AI 未来最核心的价值战场,很可能不在模型本身,而在于它吃进去的内容素材,也就是 IP。

目前全球 IP 经济的估值是 61.9 万亿美元。但问题是这么庞大的内容资源,基本上还都锁在一堆合同、中心化平台、法律框架和封闭系统里。AI 想用得先过五关斩六将,而且还可能踩雷。

所以当下的 AI 模型大多只能偷偷抓数据。互联网上的文章、图片、声音、视频,全都被默默拿来喂给模型学习。但这种方式,随着版权问题爆发、平台封锁、法律诉讼越来越多,基本上已经走不下去了。

@campnetworkxyz 的思路很清晰:不要封锁,不要偷去,而是让 IP 本身上链,变成可以被合法组合、透明授权的可编程资产。

这也是 Camp 最踏实的地方。不是要打造某个AI 内容平台,而是直接构建一套底层协议和基础设施,让所有创作者、IP 持有人,都能把自己的内容注册在链上,写清楚授权条件,定义好收益分配方式。AI 模型要用,就直接按条件付费。

最关键的是,这整个流程是可组合的。未来 AI 模型不是在一个巨大的黑盒子里吸数据,而是像搭积木一样,根据不同的内容来源、用途、风格,自由调配可授权的内容模块。而这一切的起点,就是每个 IP 上链并设有授权条款 + 收益逻辑。

这件事的意义很重大,因为它把AI & IP的关系,从被动抽取、剥削,转变为一种对等的合作。创作者不再是被抄袭的受害者,而是成为 AI 训练的供应方、商业收益的参与者。

@campnetworkxyz 提出的 “The biggest market AI will touch is IP” 观点,我个人也非常认同。模型再强,也得靠数据来养。内容再多,如果没有合规使用,迟早会给自己埋雷⛺️

41.13K

很多人讲交易工具的时候,无非就是快一点、省一点、丝滑一点。但如果经常做多链交易,尤其是跨 Solana、ETH、Base、BSC 这种,就会明白这些话说起来容易,真正能做到的,基本上没有。

@LABtrade_本质上是想做一个多链交易的基础设施层。平时用什么交易软件还是用什么,但速度更快,手续费更低,功能更强。这个思路其实挺聪明的,不强迫用户改变习惯,而是在底层做优化。从数据上看,20天1.5亿美金交易量,70万美金营收还是挺强的。

LAB提供四个产品:交易机器人、应用程序、侧边栏、浏览器插件。这些工具可以无缝运行在任何交易终端上。不用换平台,不用重新适应界面,直接在你熟悉的环境里享受更快的速度和更低的手续费。

从商业逻辑上看,LAB抓住了一个很实际的痛点。大家做链上交易,最头疼的就是手续费贵、速度慢、操作复杂。传统DEX手续费1%起步,还要等确认,体验确实不太行。LAB把手续费降到0.5%,而且没有交易量门槛,这对散户来说吸引力还是很大的。

从投资方阵容来看,Lemniscap领投,Animoca、OKX Ventures、Mirana这些都是圈内知名机构。这个投资组合还是挺靠谱的,至少说明项目在机构那里是通过了尽调的。

从技术角度看,LAB已经支持Solana、Ethereum、Base、BSC这些主流链。多链支持在现在这个生态割裂的环境下确实是刚需,用户不用在不同链之间来回切换钱包和工具。

总的来说,LAB这个项目思路还是不错的,抓住了用户的真实需求,数据表现也还可以。但能不能在激烈的竞争中站稳脚跟,还需要时间验证。对于想参与的朋友,建议先小额试水,体验一下产品,再决定是否深度参与。

传送门:

34.7K

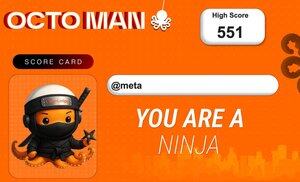

今天 @OpenledgerHQ 推出了自己的小游戏Octoman,本来想着随便玩玩打发时间,结果一上手就停不下来了。这个游戏的核心玩法就是控制一个章鱼人在空中荡来荡去,尽可能飞得更远,但是这种简单的机制反而让人上瘾。

游戏的核心是Timing Timing Timing啊!!!

游戏的操作逻辑不复杂,手机上就两个方向键加一个发射蛛丝的按钮,电脑上用WAD三个键就能搞定。但是想要真正玩好这个游戏,关键在于掌握物理引擎的节奏感。什么时候松开蛛丝,什么时候重新抓取,这个timing掌握好了,你就能在空中飞得又远又稳。

比较有意思的是,每次你刷新个人最佳成绩,系统就会自动生成一张专属的成绩卡片。这个卡片不是随便做的,而是根据你的分数高低,会解锁不同稀有度的角色形象。分数越高,角色越稀有,这种设计确实会刺激你不断去刷新纪录。

现在他们搞了一个为期两天的活动,规则也很直接。你把自己的成绩卡发到推特上,@OpenledgerHQ,然后加上 #iloveplayingoctoman 这个标签就行。看得出来他们希望玩家能真正参与进来。

从产品设计的角度来说,Octoman做得还是挺聪明的。游戏本身足够简单,任何人都能上手,但是要玩好需要练习和技巧。成绩卡系统给了玩家炫耀的理由,社交媒体传播又能带来新用户。

我自己随便玩了一下,拿了551分。直接给我了个忍者小章鱼!这画面直接拉满了,和我头像真是万分契合。也不打算突破了,就这样吧。爱了爱了!!!

22.68K

Reddit正式封杀了Internet Archive抓取内容用于AI训练,从表面看这是平台保护自己数据的常规操作,但在这背后反映的是整个AI经济模型的根本问题。

当下的情况就是AI公司需要海量高质量数据来训练模型,但内容平台和创作者从这个过程中得不到任何奖励。辛辛苦苦创作的内容,被AI公司免费拿去训练,然后大公司用训练好的模型赚钱,创作者一分钱都拿不到。

越来越多平台开始设置壁垒,Reddit封杀Internet Archive只是个开始。问题是单纯的封杀解决不了根本问题,它只是限制了访问,并没有建立一个合理的授权和分润机制。

真正需要的是一套基础设施,让使用条款、归属权、版权费这些东西在设计层面就能被强制执行。

Camp 提出了一条新路线:与其封杀,不如换个方式重新设计 AI 训练数据的使用规则。核心逻辑其实很简单:

1️⃣内容注册在链上,有来源证明

2️⃣创作者自己定义授权条件

3️⃣AI 如果要用,就必须付费

4️⃣版税自动回流给创作者

底层逻辑:与其阻止AI使用内容,不如让各方利益对齐。AI公司需要数据,创作者需要收益,平台需要生态价值,大家各取所需。

目前@campnetworkxyz 上已经有超过 150 万个创作被注册,不只是图片、音乐,还有视频、叙事内容等等,已经成为一个去中心化的 IP 原始数据库。对 AI 模型来说,它提供的是合法、可持续、可扩展的数据来源。对创作者来说,这终于是不再被白嫖的方式。

35.98K

IQ AI 和 NEAR 的合作,其背后的核心逻辑就是让 AI 代理能够自己跨链做事,不需要人工干预。

从技术层面看, @NEARProtocol 的 600ms 出块、1.2 秒确认这个速度确实够快。对于 AI 代理来说,等待时间越短越好,毕竟AI决策速度本来就比人快,如果还要等一定时间才能执行,那么整个效率就相对滞后。现在这个速度基本能做到实时响应。

之前跨链操作对普通用户来说就已经够复杂了,更别说让 AI 代理去处理各种桥接逻辑。现在直接集成到开发工具包里,AI 代理可以自主完成跨链操作,无形中降低了操作门槛。

从战略意义上看,是在抢占 AI 经济的基础设施地位。现在 AI Agent的热度水涨船高,但真正能让 AI 代理直接访问交易层、参与链上经济活动的基础设施还不多。NEAR 通过这次合作巩固了作为人工智能和代理的 L1 基础设施的低位。

其实AI 代理的需求和用户本身的需求不太一样。人类可以忍受复杂的操作流程,可以等待确认时间,可以手动处理各种异常情况。但 AI 代理需要的是标准化、自动化、高效率的执行环境。

从应用场景来看,跨链交易执行确实很实用。如果 AI 代理可以同时监控多条链上的套利机会,发现机会后自动执行跨链套利,整个过程不需要用户参与,其实套利机会远大于用户本身操作。如果同时能够兼顾多代理协同工作,可能会产生更大的价值。

对于 NEAR 来说,这是一个很好的差异化定位。在一堆 L1 都在拼 TPS、拼生态的时候,通过与@IQAICOM 合作,专注于 AI 代理这个垂直领域,早期积累好基础对于后期来讲还是很有意义。

NEAR Protocol8月13日 21:06

代币化的人工智能代理不再是科幻小说。@IQAICOM 与 NEAR 的新集成解锁了快速、最终且安全的自主跨链操作。

这就是链抽象在实际应用中的样子。

7.3K

刚看到 @boundless_xyz 昨天公布了ZK Coin的详细介绍,作为一直在关注这个项目的人,感觉还是挺有意思的。毕竟他们想做的是ZK证明的通用基础设施。

首先Boundless这个项目本身。它本质上是在做通用的ZK证明协议,让所有区块链都能用上ZK的能力。如果现在每条链都要自己搭建ZK证明系统,成本高不说,效率也不行。Boundless通过独立的证明节点网络,为各条链提供ZK证明服务。也可以简单理解成计算外包。

扩展方式对比原有的分片式或者layer2方案要简单粗暴的多,直接通过增加节点来提升整个网络的吞吐量。

ZK Coin作为这个系统的原生代币,不算是那种纯粹的治理代币。每个证明请求都需要质押ZKC作为抵押,而且是至少10倍于最大费用的抵押。这意味着随着网络使用量增加,被锁定的ZKC也会成倍增长,直接减少流通供应。

还有可验证工作量证明PoVW机制,本质上是让证明节点通过生成ZK证明来挖矿赚取ZKC。但要参与挖矿,必须先质押一定数量的ZKC。这就形成了一个正循环:更多证明需求→更多ZKC被质押→更好的性能激励→更多节点参与。

从代币分配上看,49%给生态发展。但仔细看分配逻辑,31%的生态基金主要用于三个方向:可验证应用的资助、协议集成和开发工具、协议维护和基础设施开发。18%的战略增长基金则专门针对企业集成和机构级证明节点。这种分配方式说明是真的在构建生态。

团队和早期贡献者拿23.5%,其中还有3.5%专门给RISC Zero用于未来招聘和研究。这个细节说明Boundless和RISC Zero的关系很深,而RISC Zero在zkVM领域确实有不少积累。

社区代币销售和空投只占6%,比例不算高。不过考虑到这是基础设施项目,这个比例也算合理。就是不知道后面Yapper能分多少走。

投资者21.5%的分配,锁仓机制和团队一样,1年cliff然后2年线性释放。这种设计能保证早期投资者和团队利益绑定,不会出现上线就砸盘的情况。

通胀机制第一年7%,然后逐步降到第8年开始的3%。但关键是由于每个证明请求都需要质押ZKC,实际流通供应会随着网络使用量增加而收缩。再加上质押被砍的50%会直接销毁,这就形成了一个通胀和通缩的平衡机制。

我自己看 @boundless_xyz 的亮点在于两点

1️⃣不是某个链专用的 ZK,而是真的想做所有链的通用 ZK 基建。选择的方向确实是刚需,ZK技术在区块链领域的应用只会越来越广泛,会成为不可或缺的底层。

2️⃣代币设计和业务需求直接绑定。proof 越多,ZKC 锁仓越多,代币的需求和网络使用是线性相关。

@TinaLiu333 @RiscZeroCN

46.11K

昨天看到了两组数据对比,感觉还是挺有意思的。给大家分享一下。分别是Story和Camp的数据,虽然我知道这个对比可能不是特别准确,毕竟一个主网一个测试网,但是Camp的数据表现真的挺不错的。

1️⃣Story Protocol数据

760万个区块

4370万笔交易

400万个地址

每天19.2万笔交易

2.4秒的出块时间

2️⃣Camp 测试网数据

1620万个区块

8490万笔交易

660万个地址

每天84.2万笔交易

0.9秒的出块时间

从数据上看, @campnetworkxyz 在测试网阶段就已经在多个维度超过了Story的主网表现。区块数量是Story的两倍多,交易量接近两倍,地址数量也有明显优势,每日交易量更是达到了Story的4倍多。

Story刚主网上线不久,而Camp还在测试网阶段,用户参与的心态和行为模式肯定不一样。测试网用户可能更愿意频繁交互,因为没有Gas带来的压力。但这些数字背后反映的用户活跃度和网络处理能力,还是挺有说服力的。

@campnetworkxyz 的架构设计相比较之下确实有些独特之处。Proof of Provenance协议不只是在做IP确权,更像是在构建AI和创作者之间的价值交换体系。用户可以把自己的内容注册为IP,然后AI在使用这些数据训练或生成内容时,创作者能够获得相应的收益分配。

这种模式在当前AI大量消耗训练数据的背景下,确实有其独特价值。特别是随着高质量训练数据越来越稀缺,Camp这种让用户主动贡献数据并获得回报的机制,可能会变得更加重要。

从技术层面看,Camp的0.9秒出块时间确实比Story的2.4秒要快不少。这种性能优势在处理大量IP注册和授权交易时会很有用。而且他们支持gasless的IP注册,这对普通用户来说门槛更低。

Camp目前还在测试网阶段,从这些数据表现来看,主网上线后,肯定会是一个值得关注的项目。特别是在AI和IP结合这个方向上,期待Camp的突破。

35.89K

热门

排行

收藏

链上热点

X 热门榜

近期融资

最受认可