Tendencias del momento

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Aquí está el Digest de Investigación Ritual de esta semana, un boletín que cubre lo último en el mundo de los LLM y la intersección de Crypto x AI.

Con cientos de artículos publicados semanalmente, mantenerse al día con lo último es imposible. Hacemos la lectura para que tú no tengas que hacerlo.

Think-at-Hard: Iteraciones Latentes Selectivas para Mejorar los Modelos de Lenguaje de Razonamiento

La iteración latente dinámica es difícil: necesita contexto completo, objetivos adaptativos, reutilización de parámetros, pero el acoplamiento de calidad de política causa inestabilidad en el entrenamiento.

Este trabajo presenta TaH, un pensamiento latente dinámico que itera solo sobre tokens duros mediante el desarrollo de una arquitectura de modelo especializada y un método de entrenamiento estable, aplicando selectivamente la iteración latente.

Ajustado a partir de Qwen3-0.6/1.7B-Base, TaH logra un +4% en 5 benchmarks de razonamiento.

P1: Dominando las Olimpiadas de Física con Aprendizaje por Refuerzo

Este trabajo presenta P1, una familia de modelos de razonamiento físico de código abierto. Integran tanto la escalabilidad en el tiempo de entrenamiento como en el tiempo de prueba, asegurando una mayor capacidad de razonamiento desplegada de manera adaptativa en la inferencia.

Los modelos P1 se entrenan exclusivamente a través de RL después del entrenamiento en LMs base en un marco de RL de múltiples etapas. Para el tiempo de prueba, combinan modelos P1 con el marco de agentes PhysicsMinions.

Su modelo P1-235B-A22B logra un rendimiento de medalla de oro en la IPhO 2025.

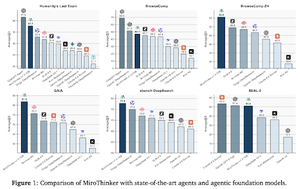

MiroThinker: Ampliando los límites de rendimiento de los agentes de investigación de código abierto a través de modelos, contexto y escalado interactivo

El documento presenta un agente de investigación que mejora el rendimiento en 3 dimensiones: tamaño del modelo, longitud del contexto y profundidad de interacción.

Para mantener procesos de razonamiento profundos, el modelo está equipado con una ventana de contexto de 256K y hasta 600 llamadas a herramientas por tarea.

MiroThinker v1.0, equipado con un agente ReAct simple, logra un rendimiento SOTA entre los agentes de investigación de código abierto.

¿Qué se necesita para ser un buen agente de investigación en IA? Estudiando el papel de la diversidad en la ideación

Este artículo propone métodos para cuantificar y controlar la diversidad en la ideación del agente. La elección del andamiaje agente influye significativamente en la diversidad de la ideación.

A través de un diseño experimental controlado, establecen una relación causal, mostrando que aumentar la diversidad de ideación conduce a una mejora en el rendimiento en las tareas de MLE-bench. También establecen robustez cuando se evalúan con métricas de rendimiento alternativas.

DR Tulu: Aprendizaje por Refuerzo con Rubricas Evolutivas para Investigación Profunda

Este artículo entrena a Tulu de investigación profunda (DR Tulu-8B) entrenado para tareas de investigación profunda abiertas y de formato largo.

Para abordar la verificación en tareas de formato largo, DR-Tulu se ajusta finamente con datos de usuario de alta calidad, y luego se entrena a través de RL con rúbricas en evolución (RLER), en las que las rúbricas co-evolucionan con el modelo de política durante el entrenamiento. Obtienen resultados mejores que los modelos abiertos más fuertes de 8-32.

Síguenos en @ritualdigest para más información sobre todo lo relacionado con la investigación en cripto x IA, y

@ritualnet para aprender más sobre lo que Ritual está construyendo.

3,03K

Parte superior

Clasificación

Favoritos