Tópicos populares

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Aqui está o Digest do Ritual Research desta semana, um boletim informativo que cobre as últimas novidades no mundo dos LLMs e a interseção entre Crypto x AI.

Com centenas de artigos publicados semanalmente, é impossível manter-se atualizado com o que há de mais recente. Nós fazemos a leitura para que você não precise.

Think-at-Hard: Iterações Latentes Seletivas para Melhorar Modelos de Linguagem de Raciocínio

A iteração latente dinâmica é difícil: precisa de contexto completo, objetivos adaptativos, reutilização de parâmetros, mas o acoplamento de qualidade de política causa instabilidade no treinamento.

Este trabalho apresenta o TaH, um pensamento latente dinâmico que itera apenas sobre tokens difíceis, desenvolvendo uma arquitetura de modelo especializada e um método de treinamento estável, aplicando seletivamente a iteração latente.

Aprimorado a partir do Qwen3-0.6/1.7B-Base, o TaH alcança +4% em 5 benchmarks de raciocínio.

P1: Dominando as Olimpíadas de Física com Aprendizagem por Reforço

Este trabalho apresenta o P1, uma família de modelos de raciocínio em física OSS. Eles integram tanto a escalabilidade em tempo de treino quanto em tempo de teste, garantindo uma capacidade de raciocínio mais forte implantada de forma adaptativa na inferência.

Os modelos P1 são treinados puramente através de RL após o treinamento em LMs base em uma estrutura de RL de múltiplas etapas. Para o tempo de teste, eles combinam modelos P1 com a estrutura de agentes PhysicsMinions.

O seu modelo P1-235B-A22B alcança desempenho de medalha de ouro na IPhO 2025.

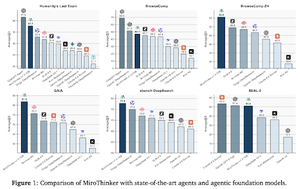

MiroThinker: Aumentando os Limites de Desempenho de Agentes de Pesquisa de Código Aberto através de Modelo, Contexto e Escalonamento Interativo

O artigo apresenta um agente de pesquisa que aumenta o desempenho em 3 dimensões: tamanho do modelo, comprimento do contexto e profundidade da interação.

Para sustentar processos de raciocínio profundo, o modelo é equipado com uma janela de contexto de 256K e até 600 chamadas de ferramentas por tarefa.

MiroThinker v1.0, equipado com um agente ReAct simples, alcança desempenho SOTA entre agentes de pesquisa de código aberto.

O que é necessário para ser um bom agente de pesquisa em IA? Estudando o papel da diversidade de ideação

Este artigo propõe métodos para quantificar e controlar a diversidade de ideação do agente. A escolha do suporte agente influencia significativamente a diversidade de ideação.

Através de um design experimental controlado, eles estabelecem uma relação causal, mostrando que o aumento da diversidade de ideação leva a um desempenho melhorado nas tarefas do MLE-bench. Eles também estabelecem robustez quando avaliados com métricas de desempenho alternativas.

DR Tulu: Aprendizagem por Reforço com Rubricas Evolutivas para Pesquisa Profunda

Este artigo treina a pesquisa profunda Tulu (DR Tulu-8B) treinada para tarefas de pesquisa profunda abertas e de longo prazo.

Para abordar a verificação em tarefas de longo prazo, o DR-Tulu é ajustado com dados de usuários de alta qualidade e, em seguida, treinado via RL com rubricas em evolução (RLER), nas quais as rubricas co-evoluem com o modelo de política durante o treinamento. Eles obtêm resultados melhores do que os modelos abertos mais fortes de 8-32.

Siga-nos @ritualdigest para mais informações sobre tudo relacionado a pesquisa em cripto x IA, e

@ritualnet para saber mais sobre o que a Ritual está construindo.

3,13K

Top

Classificação

Favoritos