Populaire onderwerpen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Hier is de Ritual Research Digest van deze week, een nieuwsbrief die de laatste ontwikkelingen in de wereld van LLM's en de kruising van Crypto x AI behandelt.

Met honderden gepubliceerde artikelen per week is het onmogelijk om bij te blijven met het laatste nieuws. Wij doen het lezen zodat jij dat niet hoeft te doen.

Think-at-Hard: Selectieve Latente Iteraties om Redenerings Taalmodellen te Verbeteren

Dynamische latente iteratie is moeilijk: het heeft volledige context, adaptieve doelstellingen, parameterhergebruik nodig, maar beleidskwaliteit koppeling veroorzaakt trainingsinstabiliteit.

Dit werk introduceert TaH, dynamisch latent denken dat alleen over harde tokens iteraties uitvoert door een gespecialiseerde modelarchitectuur en een stabiele trainingsmethode te ontwikkelen, waarbij selectief latent iteratie wordt toegepast.

Fijn afgestemd van Qwen3-0.6/1.7B-Base, behaalt TaH +4% over 5 redeneerbenchmarks.

P1: Beheersing van de Natuurkunde Olympiades met Versterkend Leren

Dit werk introduceert P1, een familie van OSS natuurkunde redeneer modellen. Ze integreren zowel schaling tijdens de training als tijdens de test, wat zorgt voor een sterkere redeneervaardigheid die adaptief wordt ingezet tijdens de inferentie.

P1-modellen worden puur getraind via RL na de training op basis-LM's in een multi-stage RL-framework. Voor de testtijd combineren ze P1-modellen met het PhysicsMinions-agentframework.

Hun model P1-235B-A22B behaalt een gouden medaille-prestatie op de IPhO 2025.

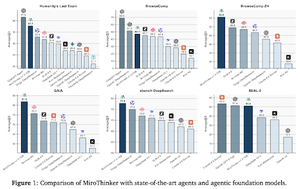

MiroThinker: De prestatielimieten van open-source onderzoeksagenten verleggen via model, context en interactieve schaalvergroting

Het paper introduceert een onderzoeksagent die de prestaties op 3 dimensies verbetert: modelgrootte, contextlengte en interactiediepte.

Om diepgaande redeneerprocessen te ondersteunen, is het model uitgerust met een contextvenster van 256K en tot 600 tool-aanroepen per taak.

MiroThinker v1.0, uitgerust met een eenvoudige ReAct-agent, behaalt SOTA-prestaties onder open-source onderzoeksagents.

Wat is er nodig om een goede AI-onderzoeksagent te zijn? Het bestuderen van de rol van diversiteit in ideevorming

Dit paper stelt methoden voor om de diversiteit in ideevorming van de agent te kwantificeren en te beheersen. De keuze van het agentische kader heeft een significante invloed op de diversiteit in ideevorming.

Door middel van een gecontroleerd experimenteel ontwerp stellen ze een causaal verband vast, waarbij ze aantonen dat een toename van de diversiteit in ideeën leidt tot een verbeterde prestatie op MLE-bench taken. Ze stellen ook de robuustheid vast wanneer ze worden geëvalueerd met alternatieve prestatiemetrics.

DR Tulu: Versterkend Leren met Evoluerende Rubrieken voor Diep Onderzoek

Dit paper traint diep onderzoek Tulu (DR Tulu-8B) getraind voor open-eindige, lange diep onderzoekstaken.

Om verificatie aan te pakken in langdurige taken, is DR-Tulu verfijnd op hoogwaardige gebruikersdata en vervolgens getraind via RL met evoluerende rubrieken (RLER), waarbij rubrieken samen evolueren met het beleidsmodel tijdens de training. Ze behalen resultaten die beter zijn dan de sterkste open 8-32 modellen.

Volg ons @ritualdigest voor meer over alles wat met crypto x AI-onderzoek te maken heeft, en @ritualnet om meer te leren over wat Ritual aan het bouwen is.

3,06K

Boven

Positie

Favorieten