Trendande ämnen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Google Research har precis släppt två genombrott inom sekvensmodellering:

🔹Titans, en djup neuralminnesarkitektur

🔹MIRAS, ett enhetligt ramverk för långtids-AI-minne.

Titans lär sig och uppdaterar minnet i farten med hjälp av en "överraskningsmetrik" för att bara fånga den viktigaste nya informationen.

MIRAS tillhandahåller ritningen: realtidsoptimering, minnesavgång och icke-euklidiska förlustfunktioner som överträffar Transformers och Mamba på ultralånga uppgifter som skalar till 2M+ tokens.

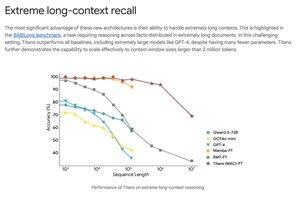

Titans slår GPT-4 på extrema långkontextbenchmarks som BABILong med betydligt färre parametrar.

Topp

Rankning

Favoriter