Актуальные темы

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Google Research только что представила два прорыва в моделировании последовательностей:

🔹Titans, архитектура глубоких нейронных памяти

🔹MIRAS, объединяющая структура для долгосрочной памяти ИИ.

Titans обучается и обновляет память на лету, используя "метрику сюрприза", чтобы захватывать только самую важную новую информацию.

MIRAS предоставляет план: оптимизация в реальном времени, распад памяти и неевклидидные функции потерь, которые превосходят Transformers и Mamba в задачах с ультра-долгими контекстами, масштабируемыми до 2M+ токенов.

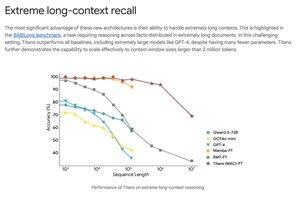

Titans обходит GPT-4 по экстремальным бенчмаркам долгого контекста, таким как BABILong, используя гораздо меньше параметров.

Топ

Рейтинг

Избранное