Tendencias del momento

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Google Research acaba de presentar dos avances en modelado de secuencias:

🔹Titans, una arquitectura de memoria neuronal profunda

🔹MIRAS, un marco unificador para la memoria de IA a largo plazo.

Titans aprende y actualiza la memoria sobre la marcha utilizando una "métrica de sorpresa" para capturar solo la información nueva más importante.

MIRAS proporciona el plano: optimización en tiempo real, decadencia de la memoria y funciones de pérdida no euclidianas que superan a los Transformers y Mamba en tareas ultra largas que escalan a más de 2M de tokens.

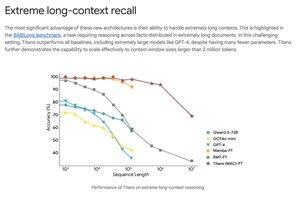

Titans supera a GPT-4 en benchmarks de contexto extremadamente largo como BABILong utilizando muchos menos parámetros.

Parte superior

Clasificación

Favoritos