Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Google Research har nettopp sluppet to gjennombrudd innen sekvensmodellering:

🔹Titaner, en dyp nevral minnearkitektur

🔹MIRAS, et samlende rammeverk for langtids AI-minne.

Titans lærer og oppdaterer minnet underveis ved hjelp av en "overraskelsesmetrikk" for å fange kun den viktigste nye informasjonen.

MIRAS gir blåkopien: sanntidsoptimalisering, minneforfall og ikke-euklidske tapsfunksjoner som overgår Transformers og Mamba på ultralange oppgaver som skalerer til 2M+ tokens.

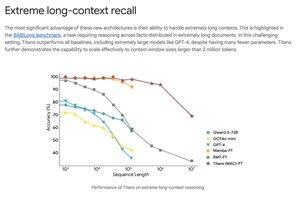

Titans slår GPT-4 på ekstreme langkontekst-benchmarks som BABILong ved å bruke langt færre parametere.

Topp

Rangering

Favoritter