Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Google Research właśnie zaprezentowało dwa przełomy w modelowaniu sekwencji:

🔹Titans, głęboka architektura pamięci neuronowej

🔹MIRAS, zjednoczona struktura dla długoterminowej pamięci AI.

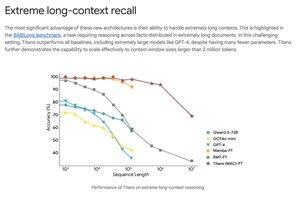

Titans uczy się i aktualizuje pamięć na bieżąco, używając „metryki zaskoczenia”, aby uchwycić tylko najważniejsze nowe informacje.

MIRAS dostarcza plan: optymalizacja w czasie rzeczywistym, zanikanie pamięci i funkcje strat nieeuklidesowe, które przewyższają Transformery i Mambę w ultra-długich zadaniach, skalujących się do 2M+ tokenów.

Titans przewyższa GPT-4 w ekstremalnych benchmarkach długiego kontekstu, takich jak BABILong, używając znacznie mniejszej liczby parametrów.

Najlepsze

Ranking

Ulubione