Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Vous êtes dans un entretien de Chercheur Scientifique chez Google.

Interviewer : Nous avons un LLM de base qui est terrible en maths. Comment le transformeriez-vous en une puissance en maths et en raisonnement ?

Vous : Je vais faire étiqueter quelques problèmes et affiner le modèle.

Entretien terminé.

Voici ce que vous avez manqué :

Lorsque les résultats sont vérifiables, les étiquettes deviennent optionnelles.

Les mathématiques, le code et la logique peuvent être vérifiés et validés automatiquement.

Utilisons ce fait pour construire un modèle de raisonnement sans étiquetage manuel.

Nous allons utiliser :

- @UnslothAI pour un ajustement fin efficace en paramètres.

- @HuggingFace TRL pour appliquer le GRPO.

Allons-y ! 🚀

Qu'est-ce que GRPO ?

L'optimisation de politique relative de groupe (GRPO) est une méthode d'apprentissage par renforcement qui ajuste les LLM pour des tâches de mathématiques et de raisonnement en utilisant des fonctions de récompense déterministes, éliminant ainsi le besoin de données étiquetées.

Voici un bref aperçu de GRPO avant de plonger dans le code :

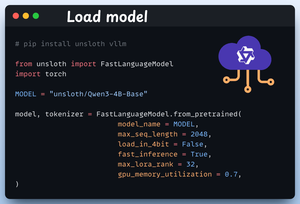

1️⃣ Chargez le modèle

Nous commençons par charger Qwen3-4B-Base et son tokenizer en utilisant Unsloth.

Vous pouvez utiliser n'importe quel autre LLM à poids ouvert ici.

Vérifiez ceci 👇

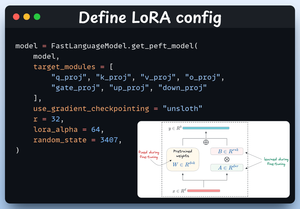

2️⃣ Définir la configuration LoRA

Nous allons utiliser LoRA pour éviter de peaufiner l'ensemble des poids du modèle. Dans ce code, nous utilisons PEFT d'Unsloth en spécifiant :

- Le modèle

- Le rang faible de LoRA (r)

- Les modules pour le peaufiner, etc.

Vérifiez ceci 👇

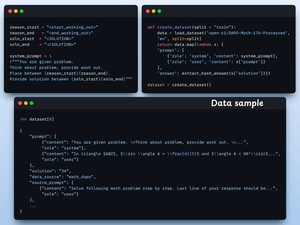

3️⃣ Créez le jeu de données

Nous chargeons le jeu de données Open R1 Math (un jeu de données de problèmes mathématiques) et le formatons pour le raisonnement.

Chaque échantillon comprend :

- Un prompt système imposant un raisonnement structuré

- Une question du jeu de données

- La réponse dans le format requis

Vérifiez ce code 👇

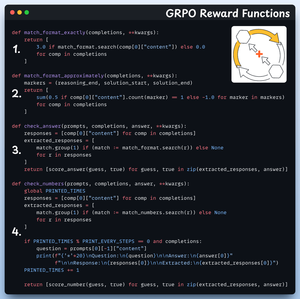

4️⃣ Définir les fonctions de récompense

Dans le GRPO, nous utilisons des fonctions déterministes pour valider la réponse et attribuer une récompense.

Aucune étiquetage manuel requis !

Les fonctions de récompense :

- Correspondre exactement au format

- Correspondre approximativement au format

- Vérifier la réponse

- Vérifier les nombres

Regardez ça 👇

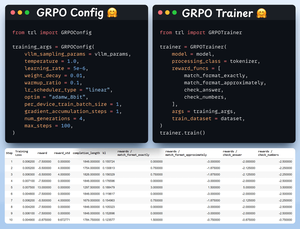

5️⃣ Utilisez GRPO et commencez l'entraînement

Maintenant que nous avons le jeu de données et les fonctions de récompense prêtes, il est temps d'appliquer GRPO.

HuggingFace TRL fournit tout ce que nous avons décrit dans le diagramme GRPO, prêt à l'emploi, sous la forme de GRPOConfig et GRPOTrainer.

Vérifiez cela👇

6️⃣ Comparaison

Encore une fois, nous pouvons voir comment GRPO a transformé un modèle de base en une puissance de raisonnement.

Regardez ça👇

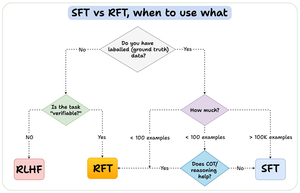

Avant de conclure, permettez-moi d'aborder une question importante :

Quand devriez-vous utiliser le renforcement de l'affinage (RFT) par rapport à l'affinage supervisé (SFT) ?

J'ai créé ce diagramme pour fournir une réponse :

157,41K

Meilleurs

Classement

Favoris