Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Du bist in einem Vorstellungsgespräch als Forschungswissenschaftler bei Google.

Interviewer: Wir haben ein Basis-LLM, das in Mathe schrecklich ist. Wie würdest du es in eine Mathe- und Denkmaschine verwandeln?

Du: Ich werde einige Probleme kennzeichnen und das Modell feinabstimmen.

Interview vorbei.

Hier ist, was du verpasst hast:

Wenn Ausgaben überprüfbar sind, werden Labels optional.

Mathematik, Code und Logik können automatisch überprüft und validiert werden.

Lass uns diese Tatsache nutzen, um ein Denkmodell ohne manuelle Kennzeichnung zu erstellen.

Wir werden verwenden:

- @UnslothAI für parameter-effizientes Feintuning.

- @HuggingFace TRL, um GRPO anzuwenden.

Los geht's! 🚀

Was ist GRPO?

Group Relative Policy Optimization ist eine Methode des Reinforcement Learning, die LLMs für mathematische und logische Aufgaben mit deterministischen Belohnungsfunktionen optimiert und somit die Notwendigkeit für gelabelte Daten beseitigt.

Hier ist eine kurze Übersicht über GRPO, bevor wir in den Code eintauchen:

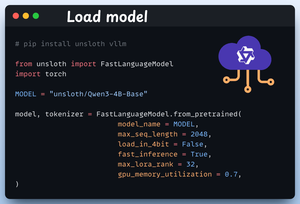

1️⃣ Lade das Modell

Wir beginnen mit dem Laden von Qwen3-4B-Base und seinem Tokenizer mit Unsloth.

Du kannst hier auch ein anderes Open-Weight LLM verwenden.

Überprüfe das 👇

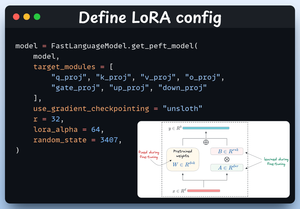

2️⃣ Definiere die LoRA-Konfiguration

Wir werden LoRA verwenden, um das Fine-Tuning der gesamten Modellgewichte zu vermeiden. In diesem Code verwenden wir Unsloth's PEFT, indem wir angeben:

- Das Modell

- LoRA Low-Rank (r)

- Module für das Fine-Tuning usw.

Überprüfe das 👇

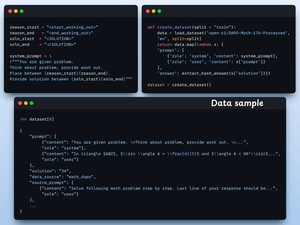

3️⃣ Erstelle den Datensatz

Wir laden den Open R1 Math-Datensatz (einen Datensatz mit Mathematikproblemen) und formatieren ihn für das logische Denken.

Jede Probe umfasst:

- Eine Systemaufforderung, die strukturiertes Denken erzwingt

- Eine Frage aus dem Datensatz

- Die Antwort im erforderlichen Format

Überprüfe diesen Code 👇

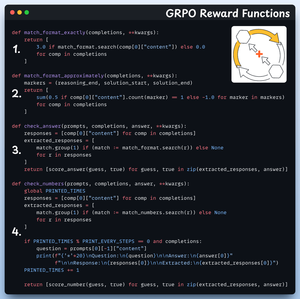

4️⃣ Definiere Belohnungsfunktionen

In GRPO verwenden wir deterministische Funktionen, um die Antwort zu validieren und eine Belohnung zuzuweisen.

Keine manuelle Kennzeichnung erforderlich!

Die Belohnungsfunktionen:

- Format genau übereinstimmen

- Format ungefähr übereinstimmen

- Antwort überprüfen

- Zahlen überprüfen

Sieh dir das an 👇

5️⃣ Verwende GRPO und beginne mit dem Training

Jetzt, da wir den Datensatz und die Belohnungsfunktionen bereit haben, ist es Zeit, GRPO anzuwenden.

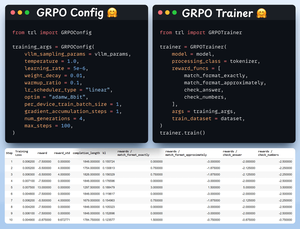

HuggingFace TRL bietet alles, was wir im GRPO-Diagramm beschrieben haben, sofort einsatzbereit in Form von GRPOConfig und GRPOTrainer.

Sieh dir das an👇

6️⃣ Vergleich

Wieder können wir sehen, wie GRPO ein Basis-Modell in eine Denkmaschine verwandelt hat.

Schau dir das an👇

Bevor wir zum Schluss kommen, lassen Sie mich eine wichtige Frage ansprechen:

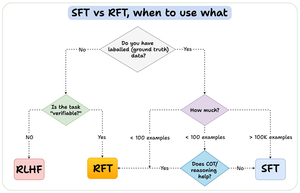

Wann sollten Sie Reinforcement Fine-Tuning (RFT) im Vergleich zu Supervised Fine-Tuning (SFT) verwenden?

Ich habe dieses Diagramm erstellt, um eine Antwort zu geben:

157,39K

Top

Ranking

Favoriten