Temas en tendencia

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Estás en una entrevista para un científico investigador en Google.

Entrevistador: Tenemos un LLM básico que es pésimo en matemáticas. ¿Cómo lo convertirías en una potencia de matemáticas y razonamiento?

Tú: Voy a etiquetar algunos problemas y afinar el modelo.

Entrevista terminada.

Esto es lo que te perdiste:

Cuando las salidas son verificables, las etiquetas se vuelven opcionales.

Las matemáticas, el código y la lógica pueden verificarse y validarse automáticamente.

Usemos este hecho para construir un modelo de razonamiento sin etiquetado manual.

Utilizaremos:

- @UnslothAI para ajustes finos eficientes en parámetros de parámetro.

- @HuggingFace TRL para aplicar GRPO.

¡Vamos! 🚀

¿Qué es GRPO?

La optimización de políticas relativas de grupo es un método de aprendizaje por refuerzo que ajusta los LLM para tareas matemáticas y de razonamiento utilizando funciones de recompensa deterministas, eliminando la necesidad de datos etiquetados.

Aquí hay una breve descripción general de GRPO antes de saltar al código:

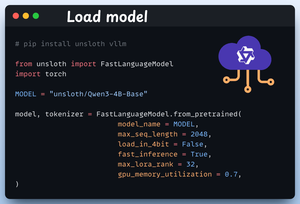

1️⃣ Cargar el modelo

Comenzamos cargando Qwen3-4B-Base y su tokenizador usando Unsloth.

Puede usar cualquier otro LLM de peso abierto aquí.

Mira esto 👇

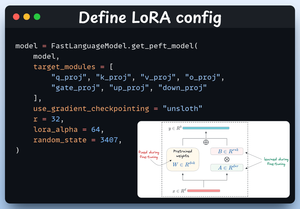

2️⃣ Definir la configuración de LoRA

Usaremos LoRA para evitar ajustar todos los pesos del modelo. En este código, usamos el PEFT de Unsloth especificando:

- El modelo

- LoRA de rango bajo (r)

- Módulos para puesta a punto, etc.

Mira esto 👇

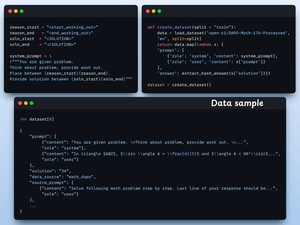

3️⃣ Crear el conjunto de datos

Cargamos el conjunto de datos Open R1 Math (un conjunto de datos de problemas matemáticos) y lo formateamos para razonar.

Cada muestra incluye:

- Un aviso del sistema que impone un razonamiento estructurado

- Una pregunta del conjunto de datos

- La respuesta en el formato requerido

Comprueba este código 👇

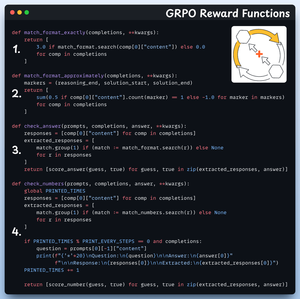

4️⃣ Definir funciones de recompensa

En GRPO utilizamos funciones deterministas para validar la respuesta y asignar una recompensa.

¡No se requiere etiquetado manual!

Las funciones de recompensa:

- Formato de partido exactamente

- Formato de partido aproximadamente

- Comprueba la respuesta

- Números de cheques

Mira esto 👇

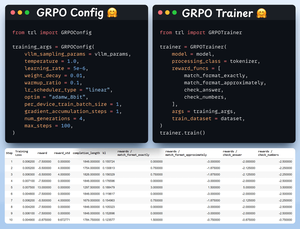

5️⃣ Usa GRPO y comienza a entrenar

Ahora que tenemos listo el conjunto de datos y las funciones de recompensa, es hora de aplicar GRPO.

HuggingFace TRL proporciona todo lo que describimos en el diagrama GRPO, listo para usar, en forma de GRPOConfig y GRPOTrainer.

Mira esto👇

6️⃣ Comparación

Una vez más, podemos ver cómo GRPO convirtió un modelo base en una potencia de razonamiento.

Mira esto👇

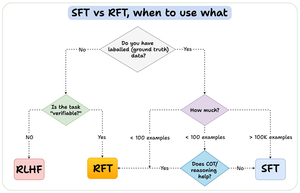

Antes de concluir, permítanme abordar una pregunta importante:

¿Cuándo se debe utilizar el ajuste fino de refuerzo (RFT) frente al ajuste fino supervisado (SFT)?

Creé este diagrama para proporcionar una respuesta:

157.39K

Populares

Ranking

Favoritas