Актуальні теми

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Ви проходите співбесіду на посаду науковця в Google.

Інтерв'юер: У нас базова LLM, яка погано справляється з математикою. Як би ви перетворили його на потужний інструмент у математиці та логіці?

Ти: Я позначу деякі проблеми і доточу модель.

Інтерв'ю закінчено.

Ось що ви пропустили:

Коли результати можна перевірити, мітки стають необов'язковими.

Математика, код і логіка можна автоматично перевіряти та перевіряти.

Давайте використаємо цей факт, щоб побудувати модель мислення без ручного маркування.

Ми використаємо:

- @UnslothAI для параметричного тонкого налаштування.

- @HuggingFace TRL для застосування GRPO.

Пішли! 🚀

Що таке GRPO?

Оптимізація групової відносної політики — це метод навчання з підкріпленням, який точно налаштовує LLM для завдань з математики та міркування за допомогою детермінованих функцій винагороди, усуваючи потребу в мічених даних.

Ось короткий огляд GRPO, перш ніж ми перейдемо до коду:

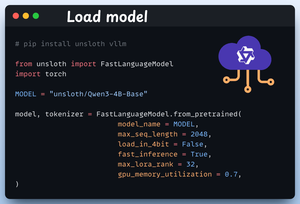

1️⃣ Завантажте модель

Починаємо з завантаження Qwen3-4B-Base та його токенізатора за допомогою Unsloth.

Тут ви можете використовувати будь-який інший LLM з відкритою вагою.

Перевірте це 👇

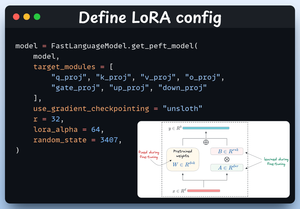

2️⃣ Визначення конфігурації LoRA

Ми будемо використовувати LoRA, щоб уникнути точного налаштування ваги всієї моделі. У цьому коді ми використовуємо PEFT від Unsloth, вказавши:

- Модель

- ЛоРА низького рангу (р)

- Модулі для тонкої настройки і т.д.

Перевірте це 👇

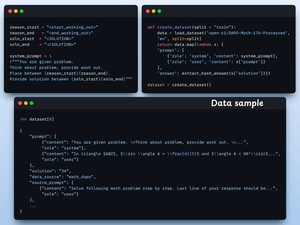

3️⃣ Створіть набір даних

Ми завантажуємо набір даних Open R1 Math (набір даних з математичної задачі) і форматуємо його для міркувань.

Кожен зразок включає:

- Системна підказка, що забезпечує структуроване міркування

- Питання з набору даних

- Відповідь у необхідному форматі

Перевірте цей код 👇

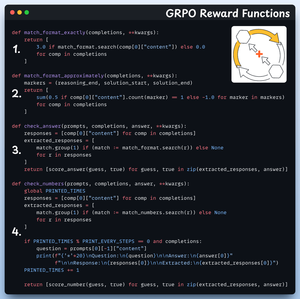

4️⃣ Визначте функції винагороди

У GRPO ми використовуємо детерміновані функції для перевірки відповіді та призначення винагороди.

Ручне маркування не потрібне!

Функції винагороди:

- Точний формат матчу

- Приблизно формат матчу

- Перевірте відповідь

- Контрольні номери

Перевірте 👇 це

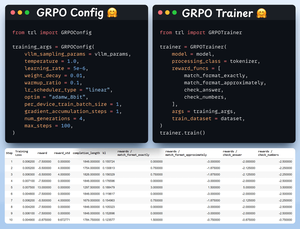

5️⃣ Використовуй GRPO і починай тренування

Тепер, коли у нас є набір даних і функції винагороди, настав час застосувати GRPO.

HuggingFace TRL надає все, що ми описали на діаграмі GRPO, з коробки, у вигляді GRPOConfig і GRPOTrainer.

Перевірте👇 це

6️⃣ Порівняння

Знову ж таки, ми можемо бачити, як GRPO перетворила базову модель на потужну рушійну силу.

Перевірте👇 це

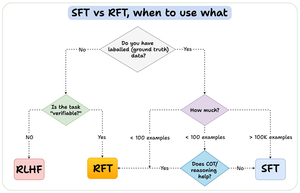

Перш ніж ми закінчимо, дозвольте мені звернутися до важливого питання:

Коли слід використовувати тонке налаштування арматури (RFT) у порівнянні з тонким налаштуванням під наглядом (SFT)?

Я створив цю діаграму, щоб дати відповідь:

157,41K

Найкращі

Рейтинг

Вибране