Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Jesteś na rozmowie kwalifikacyjnej na stanowisko naukowca badawczego w Google.

Interviewer: Mamy bazowy LLM, który jest okropny w matematyce. Jak przekształciłbyś go w potęgę matematyczną i logiczną?

Ty: Oznaczę kilka problemów i dostosuję model.

Rozmowa zakończona.

Oto, co przegapiłeś:

Gdy wyniki są weryfikowalne, etykiety stają się opcjonalne.

Matematyka, kod i logika mogą być automatycznie sprawdzane i weryfikowane.

Wykorzystajmy ten fakt, aby zbudować model rozumowania bez ręcznego etykietowania.

Użyjemy:

- @UnslothAI do efektywnego dostrajania parametrów.

- @HuggingFace TRL do zastosowania GRPO.

Zaczynajmy! 🚀

Czym jest GRPO?

Group Relative Policy Optimization to metoda uczenia przez wzmocnienie, która dostosowuje LLM do zadań matematycznych i rozumowania, wykorzystując deterministyczne funkcje nagrody, eliminując potrzebę danych oznaczonych.

Oto krótki przegląd GRPO, zanim przejdziemy do kodu:

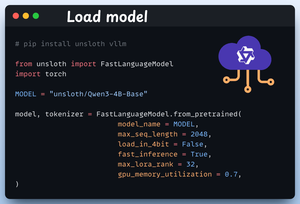

1️⃣ Załaduj model

Zaczynamy od załadowania Qwen3-4B-Base i jego tokenizera za pomocą Unsloth.

Możesz użyć tutaj dowolnego innego modelu LLM o otwartych wagach.

Sprawdź to 👇

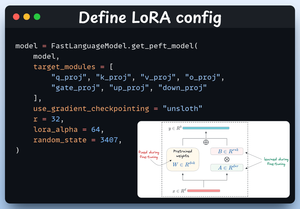

2️⃣ Zdefiniuj konfigurację LoRA

Użyjemy LoRA, aby uniknąć dostrajania całych wag modelu. W tym kodzie korzystamy z PEFT Unslotha, określając:

- Model

- Niski ranga LoRA (r)

- Moduły do dostrajania itp.

Sprawdź to 👇

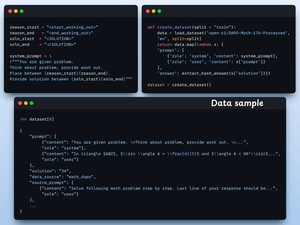

3️⃣ Utwórz zbiór danych

Ładujemy zbiór danych Open R1 Math (zbiór danych z problemami matematycznymi) i formatujemy go do rozumowania.

Każda próbka zawiera:

- Systemowy komunikat wymuszający strukturalne rozumowanie

- Pytanie z zestawu danych

- Odpowiedź w wymaganym formacie

Sprawdź ten kod 👇

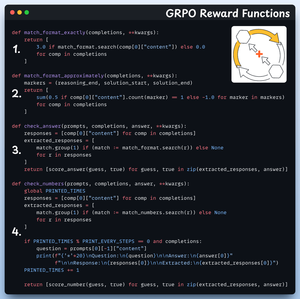

4️⃣ Zdefiniuj funkcje nagród

W GRPO używamy deterministycznych funkcji do walidacji odpowiedzi i przyznawania nagrody.

Nie wymagana ręczna etykietowanie!

Funkcje nagród:

- Dokładnie dopasuj format

- Przybliżone dopasowanie formatu

- Sprawdź odpowiedź

- Sprawdź liczby

Sprawdź to 👇

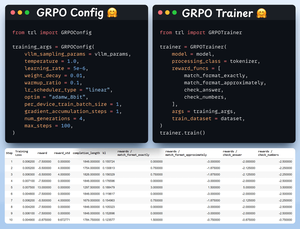

5️⃣ Użyj GRPO i zacznij trening

Teraz, gdy mamy gotowy zbiór danych i funkcje nagród, czas zastosować GRPO.

HuggingFace TRL zapewnia wszystko, co opisaliśmy w diagramie GRPO, od razu, w postaci GRPOConfig i GRPOTrainer.

Sprawdź to👇

6️⃣ Porównanie

Ponownie możemy zobaczyć, jak GRPO przekształciło model bazowy w potęgę rozumowania.

Sprawdź to👇

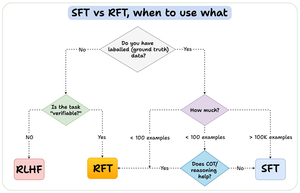

Zanim zakończymy, pozwól, że poruszę ważne pytanie:

Kiedy powinieneś używać wzmocnionego dostrajania (RFT) w porównaniu do nadzorowanego dostrajania (SFT)?

Stworzyłem ten diagram, aby udzielić odpowiedzi:

157,41K

Najlepsze

Ranking

Ulubione