Trendaavat aiheet

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Olet tutkimustieteilijän haastattelussa Googlella.

Haastattelija: Meillä on perus-LLM, joka on surkea matematiikassa. Miten tekisit siitä matematiikan ja päättelyn voimanpesän?

Sinä: Saan joitain ongelmia nimettyä ja hienosäädän mallia.

Haastattelu ohi.

Tässä mitä sinulta jäi huomaamatta:

Kun ulostulot ovat todennettavissa, etiketit muuttuvat valinnaisiksi.

Matematiikka, koodi ja logiikka voidaan tarkistaa ja validoida automaattisesti.

Käytetään tätä faktaa rakentaaksemme päättelymallin ilman manuaalista merkintää.

Käytämme:

- @UnslothAI parametritehokkaaseen hienosäätöön.

- @HuggingFace TRL:ää GRPO:n soveltamiseen.

Mennään! 🚀

Mikä on GRPO?

Group Relative Policy Optimization on vahvistusoppimismenetelmä, joka hienosäätää LLM:iä matemaattisia ja päättelytehtäviä varten determinististen palkitsemisfunktioiden avulla, mikä eliminoi merkittyjen tietojen tarpeen.

Tässä on lyhyt yleiskatsaus GRPO:sta ennen kuin hyppäämme koodiin:

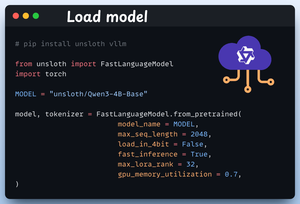

1️⃣ Lataa malli

Aloitamme lataamalla Qwen3-4B-Basen ja sen tokenisaattorin Unslothin avulla.

Voit käyttää mitä tahansa muuta avopainoista LLM:ää täällä.

Tarkista tämä 👇

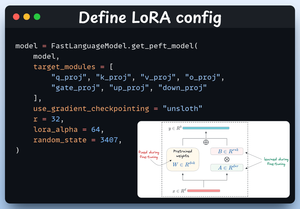

2️⃣ Määritä LoRA-kokoonpano

Käytämme LoRA:ta välttääksemme koko mallin painon hienosäädön. Tässä koodissa käytämme Unslothin PEFT:tä määrittämällä:

- Malli

- LoRA matala-arvoinen (r)

- Moduulit hienosäätöön jne.

Tarkista tämä 👇

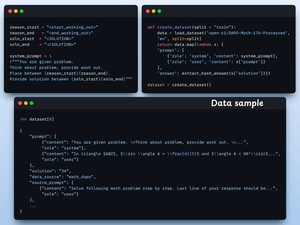

3️⃣ Luo tietojoukko

Lataamme Open R1 Math -tietojoukon (matemaattisen tehtävän tietojoukko) ja muotoilemme sen päättelyä varten.

Jokainen näyte sisältää:

- Järjestelmäkehote, joka pakottaa jäsennellyn päättelyn

- Kysymys aineistosta

- Vastaus vaaditussa muodossa

Tarkista tämä koodi 👇

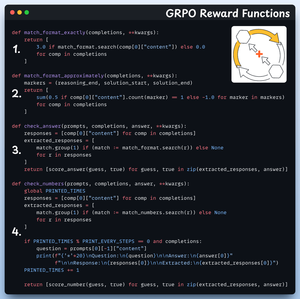

4️⃣ Määritä palkitsemistoiminnot

GRPO:ssa käytämme deterministisiä funktioita vastauksen validointiin ja palkkion määrittämiseen.

Manuaalisia merkintöjä ei tarvita!

Palkitsemistoiminnot:

- Täsmäytä muoto tarkasti

- Ottelun muoto suunnilleen

- Tarkista vastaus

- Tarkista numerot

Tsekkaa tämä 👇

5️⃣ Käytä GRPO:ta ja aloita harjoittelu

Nyt kun meillä on tietojoukko ja palkitsemisfunktiot valmiina, on aika soveltaa GRPO:ta.

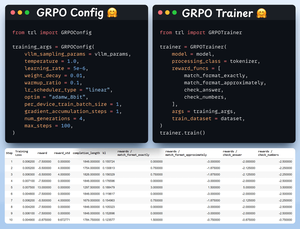

HuggingFace TRL tarjoaa kaiken, mitä kuvasimme GRPO-kaaviossa, suoraan pakkauksesta GRPOConfigin ja GRPOTrainerin muodossa.

Tsekkaa tämä👇

6️⃣ Vertailu

Jälleen voimme nähdä, kuinka GRPO muutti perusmallin päättelyn voimanpesäksi.

Tsekkaa tämä👇

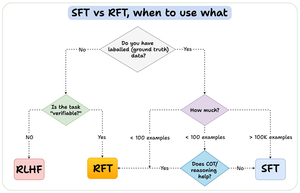

Ennen kuin päätämme puheenvuoroni, haluan käsitellä tärkeää kysymystä:

Milloin sinun pitäisi käyttää raudoituksen hienosäätöä (RFT) verrattuna valvottuun hienosäätöön (SFT)?

Loin tämän kaavion vastauksen antamiseksi:

157,42K

Johtavat

Rankkaus

Suosikit