Topik trending

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Anda sedang dalam wawancara Ilmuwan Riset di Google.

Pewawancara: Kami memiliki LLM dasar yang buruk dalam matematika. Bagaimana Anda mengubahnya menjadi pembangkit tenaga listrik matematika & penalaran?

Anda: Saya akan memberi label beberapa masalah dan menyempurnakan modelnya.

Wawancara selesai.

Inilah yang Anda lewatkan:

Saat output dapat diverifikasi, label menjadi opsional.

Matematika, kode, dan logika dapat diperiksa dan divalidasi secara otomatis.

Mari kita gunakan fakta ini untuk membangun model penalaran tanpa pelabelan manual.

Kami akan menggunakan:

- @UnslothAI untuk penyetelan yang efisien parameter.

- @HuggingFace TRL untuk menerapkan GRPO.

Ayo! 🚀

Apa itu GRPO?

Pengoptimalan Kebijakan Relatif Grup adalah metode pembelajaran penguatan yang menyempurnakan LLM untuk tugas matematika dan penalaran menggunakan fungsi penghargaan deterministik, menghilangkan kebutuhan akan data berlabel.

Berikut adalah ikhtisar singkat GRPO sebelum kita masuk ke kode:

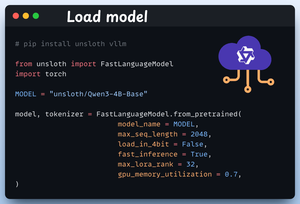

1️⃣ Muat model

Kami mulai dengan memuat Qwen3-4B-Base dan tokenizernya menggunakan Unsloth.

Anda dapat menggunakan LLM bobot terbuka lainnya di sini.

Periksa ini 👇

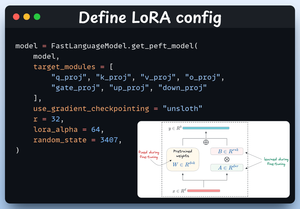

2️⃣ Tentukan konfigurasi LoRA

Kami akan menggunakan LoRA untuk menghindari penyempurnaan seluruh bobot model. Dalam kode ini, kami menggunakan PEFT Unsloth dengan menentukan:

- Model

- LoRA peringkat rendah (r)

- Modul untuk penyempurnaan, dll.

Periksa ini 👇

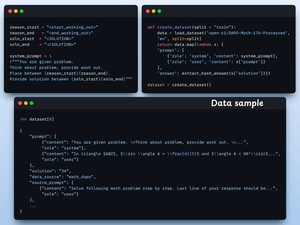

3️⃣ Buat kumpulan data

Kami memuat himpunan data Open R1 Math (himpunan data masalah matematika) dan memformatnya untuk penalaran.

Setiap sampel meliputi:

- Prompt sistem yang menegakkan penalaran terstruktur

- Pertanyaan dari himpunan data

- Jawaban dalam format yang diperlukan

Periksa kode 👇 ini

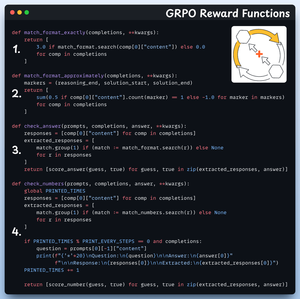

4️⃣ Tentukan fungsi hadiah

Di GRPO kami menggunakan fungsi deterministik untuk memvalidasi respons dan menetapkan hadiah.

Tidak diperlukan pelabelan manual!

Fungsi hadiah:

- Format pencocokan persis

- Format pencocokan kira-kira

- Periksa jawabannya

- Periksa nomor

Lihat 👇 ini

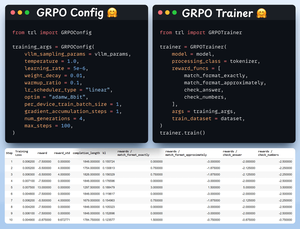

5️⃣ Gunakan GRPO dan mulai pelatihan

Sekarang kita telah menyiapkan fungsi dataset dan hadiah, saatnya untuk menerapkan GRPO.

HuggingFace TRL menyediakan semua yang kami jelaskan dalam diagram GRPO, di luar kotak, dalam bentuk GRPOConfig dan GRPOTrainer.

Lihat👇 ini

6️⃣ Perbandingan

Sekali lagi, kita dapat melihat bagaimana GRPO mengubah model dasar menjadi pembangkit tenaga penalaran.

Lihat👇 ini

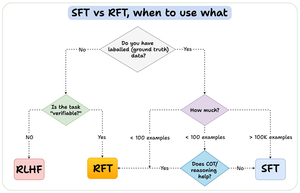

Sebelum kita menyimpulkan, izinkan saya menjawab pertanyaan penting:

Kapan Anda harus menggunakan penguatan fine-tuning (RFT) versus supervised fine-tuning (SFT)?

Saya membuat diagram ini untuk memberikan jawaban:

157,4K

Teratas

Peringkat

Favorit