Populární témata

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Jste na pohovoru na pozici výzkumného vědce ve Googlu.

Tazatel: Máme základní LLM, který je v matematice hrozný. Jak byste z něj udělali silnou sílu v matematice a uvažování?

Ty: Označím pár úloh a doladím model.

Pohovor skončil.

Tady je, co jste přehlédli:

Když jsou výstupy ověřitelné, štítky se stávají volitelnými.

Matematika, kód a logika lze automaticky kontrolovat a ověřovat.

Použijme tento fakt k vytvoření modelu uvažování bez ručního označování.

Použijeme:

- @UnslothAI pro parametrově efektivní jemné ladění.

- @HuggingFace TRL pro aplikaci GRPO.

Jdeme! 🚀

Co je GRPO?

Group Relative Policy Optimization je metoda zpětnovazebního učení, která vylepšuje LLM pro matematické a logické úlohy pomocí deterministických funkcí odměny, čímž eliminuje potřebu označených dat.

Zde je stručný přehled GRPO, než se pustíme do kódu:

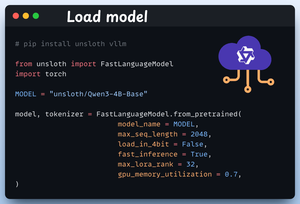

1️⃣ Načíst model

Začneme načtením Qwen3-4B-Base a jeho tokenizeru pomocí Unsloth.

Zde můžete použít jakýkoli jiný LLM s otevřenou váhou.

Zkontrolujte toto 👇

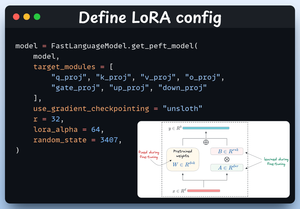

2️⃣ Definujte konfiguraci LoRA

Použijeme LoRA, abychom se vyhnuli dolaďování hmotností celého modelu. V tomto kódu používáme Unslothův PEFT specifikací:

- Model

- LoRA s nízkou hodností (r)

- Moduly pro jemné doladění atd.

Zkontrolujte toto 👇

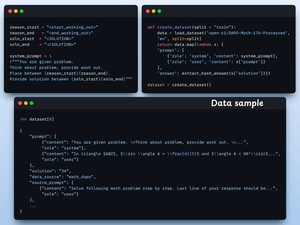

3️⃣ Vytvoření datové sady

Načteme datovou sadu Open R1 Math (datovou sadu matematických problémů) a naformátujeme ji pro účely uvažování.

Každá ukázka obsahuje:

- Systémová výzva vynucující strukturované uvažování

- Otázka z datasetu

- Odpověď v požadovaném formátu

Zkontrolujte tento kód 👇

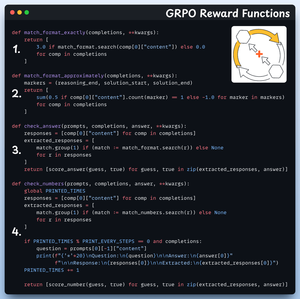

4️⃣ Definujte funkce odměňování

V GRPO používáme deterministické funkce k ověření odpovědi a přiřazení odměny.

Není nutné žádné ruční označování!

Funkce odměny:

- Přesně se shoduje s formátem

- Přibližně odpovídá formátu

- Zkontrolujte odpověď

- Zkontrolujte čísla

Podívejte se na 👇 to

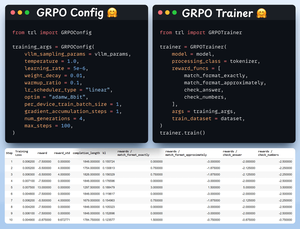

5️⃣ Použijte GRPO a začněte trénovat

Nyní, když máme připravenou datovou sadu a funkce odměn, je čas použít GRPO.

HuggingFace TRL poskytuje vše, co jsme popsali v diagramu GRPO, ihned po vybalení, ve formě GRPOConfig a GRPOTrainer.

Podívejte se na👇 to

6️⃣ Srovnání

Opět můžeme vidět, jak GRPO změnilo základní model na rozumovou sílu.

Podívejte se na👇 to

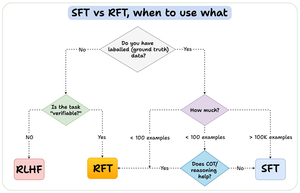

Než skončíme, dovolte mi věnovat se důležité otázce:

Kdy byste měli použít jemné doladění výztuže (RFT) a kdy jemné doladění pod dohledem (SFT)?

Vytvořil jsem tento diagram, abych poskytl odpověď:

157,4K

Top

Hodnocení

Oblíbené