トレンドトピック

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

あなたはGoogleのリサーチサイエンティストの面接を受けていますね。

インタビュアー:数学が苦手な基本のLLMがあります。数学と推論の強豪にするにはどうすればいいですか?

あなた:いくつか問題をラベル付けしてモデルを微調整します。

面接終了。

見落とした内容は以下の通りです:

出力が検証可能であれば、ラベルは任意となります。

数学、コード、論理は自動的にチェック・検証されます。

この事実を使って、手動でラベル付けせずに推論モデルを構築しましょう。

以下を使います:

- パラメータ効率の良い微調整のための@UnslothAI。

- GRPOを適用するためにTRLを@HuggingFace。

行きましょう!🚀

GRPOとは?

グループ相対ポリシー最適化は、決定論的報酬関数を使用して数学および推論タスクのLLMを微調整し、ラベル付けされたデータの必要性を排除する強化学習手法です。

コードに入る前に、GRPO の概要を簡単に説明します。

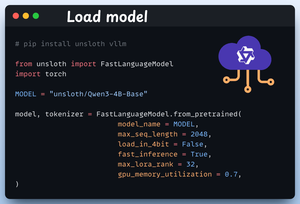

1️⃣ モデルをロードする

まず、Unslothを使用してQwen3-4B-Baseとそのトークナイザーをロードします。

ここでは、他のオープンウェイト LLM を使用できます。

これを👇チェックしてください

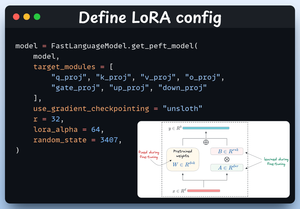

2️⃣ LoRA構成の定義

LoRA を使用して、モデル全体の重みを微調整しないようにします。このコードでは、次のように指定して Unsloth の PEFT を使用します。

- モデル

- LoRA低ランク(r)

- 微調整用モジュールなど

これを👇チェックしてください

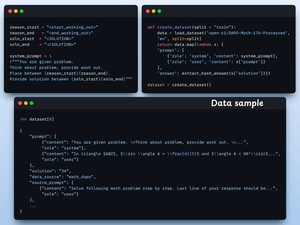

3️⃣ データセットを作成する

Open R1 Mathデータセット(数学の問題データセット)をロードし、推論用にフォーマットします。

各サンプルには次のものが含まれます。

- 構造化推論を強制するシステムプロンプト

- データセットからの質問

- 必要な形式の回答

このコード👇を確認してください

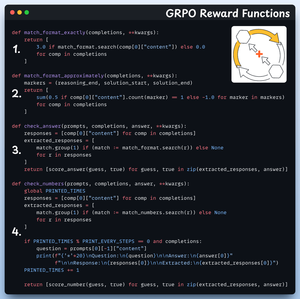

4️⃣ 報酬関数を定義する

GRPO では、決定論的関数を使用して応答を検証し、報酬を割り当てます。

手動ラベリングは不要です!

報酬関数:

- 形式を正確に一致させる

- おおよその一致形式

- 答えを確認する

- 番号を確認する

これがいいと思います 👇

5️⃣ GRPOを使用してトレーニングを開始する

データセットと報酬関数の準備ができたので、GRPO を適用します。

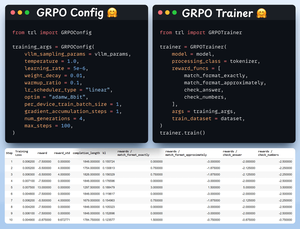

HuggingFace TRLは、GRPOConfigとGRPOTrainerの形式で、GRPO図で説明したすべてのものを箱から出してすぐに提供します。

これがいいと思います👇

6️⃣比較

繰り返しになりますが、GRPO がベース モデルを推論の大国に変えた方法がわかります。

これがいいと思います👇

結論を出す前に、重要な質問に答えさせてください。

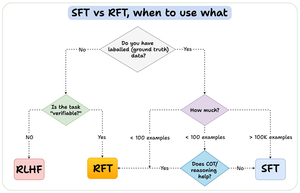

強化ファインチューニング (RFT) と教師ありファインチューニング (SFT) はどのような場合に使用する必要がありますか?

答えを提供するためにこの図を作成しました。

157.4K

トップ

ランキング

お気に入り