Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Frank Downing

Oui.

J'ai entendu dire que "les navigateurs sont la distribution ultime pour les agents". Je pense que c'est à l'envers.

Les agents utiliseront les navigateurs comme un outil, parmi d'autres, pour accomplir des tâches.

Vous penserez à l'agent comme au produit, pas au navigateur.

Vous payez pour l'Agent ChatGPT, qui lance des navigateurs pour accomplir des tâches selon les besoins. Vous pouvez regarder et intervenir, mais vous n'êtes pas obligé.

Même direction pour Comet de Perplexity. Il rencontre les utilisateurs là où ils en sont aujourd'hui, mais au fil du temps, l'agent conduira de plus en plus et vous vous souciez de moins en moins de voir comment la saucisse est faite.

qw22 juil., 03:12

les sites web remplacent la plupart des applications de bureau (les 2 dernières décennies)

puis les agents remplacent la plupart des sites web (les 2 prochaines décennies)

32,74K

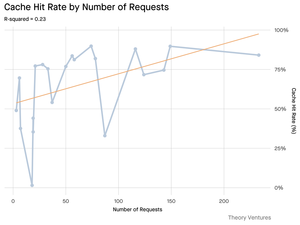

Bonnes données sur l'importance de "l'ingénierie du contexte" :

Les tokens d'entrée peuvent être moins chers que les tokens de sortie, mais les tâches lourdes en contexte (comme le codage) peuvent nécessiter 300 à 400 fois plus de tokens d'entrée de contexte que de tokens de sortie, rendant le contexte 98 % des coûts totaux d'utilisation des LLM.

La latence augmente également avec une taille de contexte plus grande.

Cela souligne l'importance de fournir le bon contexte au bon moment lors de la création d'applications d'IA, et, je suppose, laisse beaucoup de place pour une différenciation concurrentielle dans les applications SaaS natives à l'IA.

Tomasz Tunguz9 juil., 01:36

Lorsque vous interrogez l'IA, elle rassemble des informations pertinentes pour vous répondre.

Mais, combien d'informations le modèle a-t-il besoin ?

Les conversations avec des praticiens ont révélé leur intuition : l'entrée était ~20x plus grande que la sortie.

Mais mes expériences avec l'interface de ligne de commande de l'outil Gemini, qui fournit des statistiques détaillées sur les tokens, ont révélé que c'était beaucoup plus élevé.

300x en moyenne et jusqu'à 4000x.

Voici pourquoi ce rapport élevé entrée-sortie est important pour quiconque construit avec l'IA :

La gestion des coûts dépend entièrement de l'entrée. Avec des appels API tarifés par token, un ratio de 300:1 signifie que les coûts sont dictés par le contexte, pas par la réponse. Cette dynamique de tarification est valable pour tous les principaux modèles.

Sur la page de tarification d'OpenAI, les tokens de sortie pour GPT-4.1 sont 4x plus chers que les tokens d'entrée. Mais lorsque l'entrée est 300x plus volumineuse, les coûts d'entrée représentent toujours 98% de la facture totale.

La latence est une fonction de la taille du contexte. Un facteur important déterminant combien de temps un utilisateur attend une réponse est le temps nécessaire au modèle pour traiter l'entrée.

Cela redéfinit le défi d'ingénierie. Cette observation prouve que le défi principal de la construction avec les LLM n'est pas seulement de donner des instructions. C'est l'ingénierie du contexte.

La tâche critique consiste à construire une récupération de données efficace et un contexte - créer des pipelines capables de trouver les meilleures informations et de les distiller dans l'empreinte de token la plus petite possible.

Le caching devient essentiel. Si 99% des tokens se trouvent dans l'entrée, construire une couche de caching robuste pour les documents fréquemment récupérés ou les contextes de requête courants passe d'un "nice-to-have" à une exigence architecturale fondamentale pour construire un produit rentable et évolutif.

Pour les développeurs, cela signifie que se concentrer sur l'optimisation de l'entrée est un levier critique pour contrôler les coûts, réduire la latence et, en fin de compte, construire un produit alimenté par l'IA réussi.

1,5K

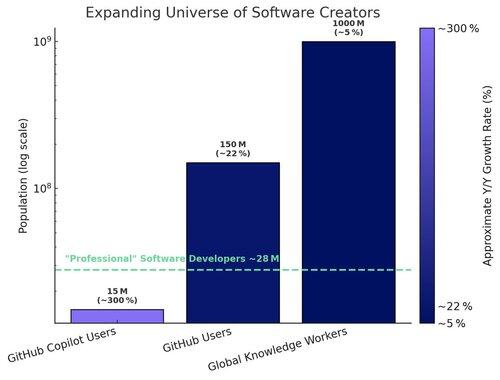

Deux volants d'inertie renforçants accélèrent l'adoption des IDE (environnements de développement intégrés) d'IA :

1. Volant de modèle-produit :

À mesure que les modèles fondamentaux s'améliorent (raisonnement, planification, utilisation d'outils), les IDE d'IA construits sur ces modèles s'améliorent instantanément, entraînant une utilisation accrue des produits. À mesure que les IDE d'IA deviennent de grands consommateurs de tokens, les fournisseurs de modèles fondamentaux sont incités à optimiser ces flux de travail — augmentant encore la performance.

2. Volant utilisateur-données :

À mesure que les IDE d'IA attirent plus de développeurs, ils génèrent des données d'utilisation propriétaires (ce que les développeurs demandent, comment ils codent, où ils rencontrent des difficultés). Ces données peuvent être utilisées pour entraîner des modèles spécialisés ajustés pour l'IDE lui-même — conduisant à une meilleure expérience utilisateur et performance, et à une barrière plus profonde.

Le #1 bénéficie à la catégorie. Le #2 bénéficie au leader de la catégorie.

26,19K

C'est drôle pour moi que Claude fasse un meilleur travail pour répondre aux questions sur mon Gmail que ne le fait le Gemini de Google.

Les dernières versions de Gemini excellent dans les benchmarks et j'ai entendu dire de manière anecdotique qu'elles sont excellentes en programmation, mais l'utilisation réelle de l'application Gemini n'a jamais été à la hauteur pour moi par rapport à ChatGPT, Claude ou Grok.

224,57K

1/ Les logiciels ont toujours eu pour but d’augmenter la productivité humaine, en automatisant les tâches, en rationalisant les flux de travail et en libérant les gens pour qu’ils se concentrent sur un travail créatif à plus forte valeur ajoutée.

Les agents de codage de l’IA portent cela à un nouveau niveau.

136,05K

Nous avons publié un livre blanc avec Coinbase en janvier 2017, 8 mois avant qu’ils ne lèvent leur tour de table de série D à une valorisation de 1,6 milliard de dollars. Nous avons admiré l’approche de l’entreprise pour intégrer de nouveaux utilisateurs à la crypto-économie > en se penchant sur l’innovation avec une vitesse de produit élevée tout en respectant les règles. Aujourd’hui, la société vaut ~65 milliards de dollars, ce qui représente un rendement annualisé d’environ 60 % pour les investisseurs de série D au cours des ~8 dernières années.

Tesla, Palantir et maintenant Coinbase : toutes des entreprises que le marché n’a pas fondamentalement comprises et punies comme si elles allaient faire faillite, maintenant reconnues comme leaders de leur catégorie dans leurs espaces respectifs et faisant partie du S&P 500. Même si nous pensons que certaines des meilleures années de chacune de ces entreprises sont devant elles, il est essentiel d’accéder à l’innovation tôt, avant qu’une entreprise ne fasse partie des grands indices, pour constituer un portefeuille complet.

ARK Invest14 mai 2025

Coinbase is joining the S&P 500. To most, it’s a crypto milestone. To us, it’s a signal. 🧵

264,64K

Meilleurs

Classement

Favoris

Tendance on-chain

Tendance sur X

Récents financements de premier plan

Les plus notables