Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Frank Downing

Ja.

Jeg har hørt "nettlesere er den ultimate distribusjonen for agenter". Jeg tror dette er bakvendt.

Agenter vil bruke nettlesere som et verktøy, blant annet for å utføre oppgaver.

Du vil tenke på agenten som produktet, ikke nettleseren.

Du betaler for ChatGPT Agent, som spinner opp nettlesere for å utføre oppgaver etter behov. Du kan se og hoppe inn, men du trenger ikke.

Samme retning for Perplexitys komet. Den møter brukerne der de er i dag, men over tid vil agenten kjøre mer og mer og du vil bry deg mindre og mindre om å se hvordan pølsen lages.

qw22. juli, 03:12

Nettsteder erstatter de fleste skrivebordsapplikasjoner (siste 2 tiår)

Deretter erstatter agenter de fleste nettsteder (neste 2 tiår)

32,26K

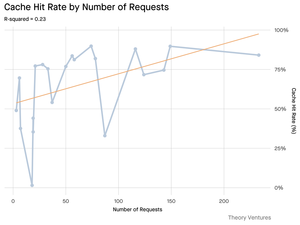

Gode data peker på viktigheten av "kontekstteknikk":

Inndatatokener kan være billigere enn utdatatokener, men konteksttunge oppgaver (som koding) kan kreve 300-400 ganger flere inndatatokener av kontekst enn utdatatokener, noe som gjør kontekst 98 % av de totale LLM-brukskostnadene.

Latens vokser også med større kontekststørrelse.

Understreker viktigheten av å gi riktig kontekst til rett tid når du bygger AI-applikasjoner, og jeg antar at det gir mye rom for konkurransedyktig differensiering i AI-navtive SaaS-apper.

Tomasz Tunguz9. juli, 01:36

When you query AI, it gathers relevant information to answer you.

But, how much information does the model need?

Conversations with practitioners revealed the their intuition : the input was ~20x larger than the output.

But my experiments with Gemini tool command line interface, which outputs detailed token statistics, revealed its much higher.

300x on average & up to 4000x.

Here’s why this high input-to-output ratio matters for anyone building with AI:

Cost Management is All About the Input. With API calls priced per token, a 300:1 ratio means costs are dictated by the context, not the answer. This pricing dynamic holds true across all major models.

On OpenAI’s pricing page, output tokens for GPT-4.1 are 4x as expensive as input tokens. But when the input is 300x more voluminous, the input costs are still 98% of the total bill.

Latency is a Function of Context Size. An important factor determining how long a user waits for an answer is the time it takes the model to process the input.

It Redefines the Engineering Challenge. This observation proves that the core challenge of building with LLMs isn’t just prompting. It’s context engineering.

The critical task is building efficient data retrieval & context - crafting pipelines that can find the best information and distilling it into the smallest possible token footprint.

Caching Becomes Mission-Critical. If 99% of tokens are in the input, building a robust caching layer for frequently retrieved documents or common query contexts moves from a “nice-to-have” to a core architectural requirement for building a cost-effective & scalable product.

For developers, this means focusing on input optimization is a critical lever for controlling costs, reducing latency, and ultimately, building a successful AI-powered product.

1,46K

To forsterkende svinghjul akselererer adopsjonen av AI IDE (integrert utviklingsmiljø):

1. Svinghjul for modellprodukt:

Etter hvert som grunnmodellene forbedres (resonnement, planlegging, verktøybruk), blir AI-IDE-er bygget på toppen av dem umiddelbart bedre, noe som fører til mer produktbruk. Etter hvert som AI-IDE-er blir store token-forbrukere, blir grunnmodellleverandører oppmuntret til å optimalisere for disse arbeidsflytene – noe som øker ytelsen ytterligere.

2. Svinghjul for brukerdata:

Etter hvert som AI IDE-er tiltrekker seg flere utviklere, genererer de proprietære bruksdata (hva utviklere spør, hvordan de koder, hvor de blir sittende fast). Disse dataene kan brukes til å trene spesialiserte modeller som er finjustert for selve IDE – noe som fører til bedre brukeropplevelse og ytelse, og en dypere vollgrav.

#1 fordeler kategorien. #2 er til fordel for kategorilederen.

26,15K

Det er morsomt for meg at Claude gjør en bedre jobb med å svare på spørsmål om Gmail enn Googles Gemini gjør.

Siste versjoner av Gemini knuser den på benchmarks og har hørt annektodaly at de er gode til å kode, men bruk av Gemini-appen i den virkelige verden har aldri matchet meg i forhold til ChatGPT, Claude eller Grok

224,53K

Vi publiserte en whitepaper med Coinbase i januar 2017, 8 måneder før de hevet serie D-runden til en verdsettelse på 1,6 milliarder dollar. Vi beundret selskapets tilnærming til å ta inn nye brukere til kryptoøkonomien - > å lene seg inn i innovasjon med høy produkthastighet mens vi spiller etter reglene. I dag er selskapet verdt ~65 milliarder dollar, noe som representerer en årlig avkastning på omtrent 60 % til serie D-investorer de siste ~8 årene.

Tesla, Palantir og nå Coinbase: Alle selskaper som markedet fundamentalt sett ikke forsto og straffet som om de gikk konkurs, nå anerkjent som kategoriledere i sine respektive områder og en del av S&P 500. Selv om vi fortsatt tror at noen av de beste årene for hvert av disse selskapene ligger foran dem, er tilgang til innovasjon tidlig, før et selskap kommer inn i de store indeksene, nøkkelen til å bygge en komplett portefølje.

ARK Invest14. mai 2025

Coinbase blir med i S&P 500. For de fleste er det en kryptomilepæl. For oss er det et signal. 🧵

264,6K

Topp

Rangering

Favoritter

Trendende onchain

Trendende på X

Nylig toppfinansiering

Mest lagt merke til