Populaire onderwerpen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Frank Downing

Ja.

Ik heb gehoord dat "browsers de ultieme distributie voor agents zijn". Ik denk dat dit verkeerd is.

Agents zullen browsers gebruiken als een hulpmiddel, naast andere, om taken te voltooien.

Je zult de agent als het product beschouwen, niet de browser.

Je betaalt voor de ChatGPT Agent, die browsers opstart om taken uit te voeren wanneer dat nodig is. Je kunt kijken en instappen, maar dat hoeft niet.

Zelfde richting voor Perplexity's Comet. Het ontmoet gebruikers waar ze vandaag zijn, maar na verloop van tijd zal de agent steeds meer aansturen en zul je steeds minder geïnteresseerd zijn in hoe de worst wordt gemaakt.

qw22 jul, 03:12

websites vervangen de meeste desktopapplicaties (laatste 2 decennia)

dan vervangen agents de meeste websites (volgende 2 decennia)

32,72K

Goede gegevenspunten over het belang van "context engineering":

Invoertokens kunnen goedkoper zijn dan uitvoertokens, maar contextzware taken (zoals coderen) kunnen 300-400x meer invoertokens aan context vereisen dan uitvoertokens, waardoor context 98% van de totale kosten voor LLM-gebruik uitmaakt.

De latentie groeit ook met een grotere contextgrootte.

Dit benadrukt het belang van het bieden van de juiste context op het juiste moment bij het bouwen van AI-toepassingen, en ik neem aan dat dit veel ruimte laat voor competitieve differentiatie in AI-native SaaS-apps.

Tomasz Tunguz9 jul, 01:36

When you query AI, it gathers relevant information to answer you.

But, how much information does the model need?

Conversations with practitioners revealed the their intuition : the input was ~20x larger than the output.

But my experiments with Gemini tool command line interface, which outputs detailed token statistics, revealed its much higher.

300x on average & up to 4000x.

Here’s why this high input-to-output ratio matters for anyone building with AI:

Cost Management is All About the Input. With API calls priced per token, a 300:1 ratio means costs are dictated by the context, not the answer. This pricing dynamic holds true across all major models.

On OpenAI’s pricing page, output tokens for GPT-4.1 are 4x as expensive as input tokens. But when the input is 300x more voluminous, the input costs are still 98% of the total bill.

Latency is a Function of Context Size. An important factor determining how long a user waits for an answer is the time it takes the model to process the input.

It Redefines the Engineering Challenge. This observation proves that the core challenge of building with LLMs isn’t just prompting. It’s context engineering.

The critical task is building efficient data retrieval & context - crafting pipelines that can find the best information and distilling it into the smallest possible token footprint.

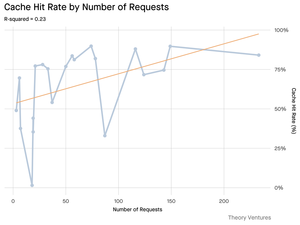

Caching Becomes Mission-Critical. If 99% of tokens are in the input, building a robust caching layer for frequently retrieved documents or common query contexts moves from a “nice-to-have” to a core architectural requirement for building a cost-effective & scalable product.

For developers, this means focusing on input optimization is a critical lever for controlling costs, reducing latency, and ultimately, building a successful AI-powered product.

1,48K

Twee versterkende vliegwielen versnellen de adoptie van AI IDE (geïntegreerde ontwikkelomgeving):

1. Model-product vliegwiel:

Naarmate fundamentmodellen verbeteren (redeneren, plannen, gebruik van tools), worden AI IDE's die bovenop deze modellen zijn gebouwd onmiddellijk beter, wat leidt tot meer productgebruik. Aangezien AI IDE's grote tokenverbruikers worden, worden aanbieders van fundamentmodellen gestimuleerd om te optimaliseren voor die workflows — wat de prestaties verder verhoogt.

2. Gebruikers-data vliegwiel:

Naarmate AI IDE's meer ontwikkelaars aantrekken, genereren ze eigendomsgebruikdata (wat ontwikkelaars vragen, hoe ze coderen, waar ze vastlopen). Deze data kan worden gebruikt om gespecialiseerde modellen te trainen die fijn zijn afgestemd op de IDE zelf — wat leidt tot een betere gebruikerservaring en prestaties, en een diepere bescherming.

#1 komt de categorie ten goede. #2 komt de categorieleider ten goede.

26,17K

Het is grappig voor mij dat Claude beter vragen over mijn Gmail beantwoordt dan Google's Gemini.

De nieuwste versies van Gemini presteren geweldig op benchmarks en ik heb anekdotisch gehoord dat ze geweldig zijn in coderen, maar het gebruik van de Gemini-app in de echte wereld heeft voor mij nooit overeengekomen met ChatGPT, Claude of Grok.

224,54K

We publiceerden een whitepaper met Coinbase in januari 2017, 8 maanden voordat ze hun serie D-ronde verhoogden tegen een waardering van $ 1,6 miljard. We bewonderden de aanpak van het bedrijf om nieuwe gebruikers aan boord te krijgen van de crypto-economie > het leunen op innovatie met een hoge productsnelheid terwijl ze zich aan de regels houden. Vandaag de dag is het bedrijf ~ $ 65 miljard waard, wat neerkomt op een jaarlijks rendement van ongeveer 60% voor Series D-investeerders over de afgelopen ~8 jaar.

Tesla, Palantir en nu Coinbase: alle bedrijven die de markt fundamenteel niet begreep en strafte alsof ze failliet gingen, nu erkend als categorieleiders in hun respectievelijke ruimtes en onderdeel van de S&P 500. Hoewel we nog steeds denken dat enkele van de beste jaren voor elk van deze bedrijven voor hen liggen, is vroege toegang tot innovatie, voordat een bedrijf in de grote indices terechtkomt, de sleutel tot het opbouwen van een complete portefeuille.

ARK Invest14 mei 2025

Coinbase is joining the S&P 500. To most, it’s a crypto milestone. To us, it’s a signal. 🧵

264,62K

Boven

Positie

Favorieten

Populair op onchain

Populair op X

Recente topfinanciering

Belangrijkste