Chủ đề thịnh hành

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Frank Downing

Có.

Tôi đã nghe nói "trình duyệt là phương tiện phân phối tối ưu cho các tác nhân". Tôi nghĩ điều này là ngược lại.

Các tác nhân sẽ sử dụng trình duyệt như một công cụ, bên cạnh những công cụ khác, để hoàn thành nhiệm vụ.

Bạn sẽ nghĩ về tác nhân như là sản phẩm, chứ không phải trình duyệt.

Bạn trả tiền cho ChatGPT Agent, cái mà khởi động trình duyệt để hoàn thành nhiệm vụ khi cần. Bạn có thể theo dõi và tham gia, nhưng bạn không cần phải làm vậy.

Cùng một hướng đi cho Comet của Perplexity. Nó gặp gỡ người dùng ở nơi họ đang có hôm nay, nhưng theo thời gian, tác nhân sẽ điều khiển ngày càng nhiều và bạn sẽ quan tâm ít hơn đến việc xem cách mà xúc xích được làm ra.

qw03:12 22 thg 7

các trang web thay thế hầu hết các ứng dụng trên máy tính để bàn (20 năm qua)

sau đó, các đại lý sẽ thay thế hầu hết các trang web (20 năm tới)

32,72K

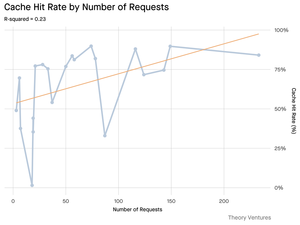

Các điểm dữ liệu tốt về tầm quan trọng của "kỹ thuật ngữ cảnh":

Các token đầu vào có thể rẻ hơn token đầu ra, nhưng các tác vụ nặng về ngữ cảnh (như lập trình) có thể yêu cầu 300-400 lần nhiều token đầu vào ngữ cảnh hơn token đầu ra, khiến ngữ cảnh chiếm 98% tổng chi phí sử dụng LLM.

Độ trễ cũng tăng lên với kích thước ngữ cảnh lớn hơn.

Điều này nhấn mạnh tầm quan trọng của việc cung cấp ngữ cảnh đúng vào thời điểm đúng khi xây dựng các ứng dụng AI, và, tôi giả định, để lại nhiều không gian cho sự khác biệt cạnh tranh trong các ứng dụng SaaS gốc AI.

Tomasz Tunguz01:36 9 thg 7

When you query AI, it gathers relevant information to answer you.

But, how much information does the model need?

Conversations with practitioners revealed the their intuition : the input was ~20x larger than the output.

But my experiments with Gemini tool command line interface, which outputs detailed token statistics, revealed its much higher.

300x on average & up to 4000x.

Here’s why this high input-to-output ratio matters for anyone building with AI:

Cost Management is All About the Input. With API calls priced per token, a 300:1 ratio means costs are dictated by the context, not the answer. This pricing dynamic holds true across all major models.

On OpenAI’s pricing page, output tokens for GPT-4.1 are 4x as expensive as input tokens. But when the input is 300x more voluminous, the input costs are still 98% of the total bill.

Latency is a Function of Context Size. An important factor determining how long a user waits for an answer is the time it takes the model to process the input.

It Redefines the Engineering Challenge. This observation proves that the core challenge of building with LLMs isn’t just prompting. It’s context engineering.

The critical task is building efficient data retrieval & context - crafting pipelines that can find the best information and distilling it into the smallest possible token footprint.

Caching Becomes Mission-Critical. If 99% of tokens are in the input, building a robust caching layer for frequently retrieved documents or common query contexts moves from a “nice-to-have” to a core architectural requirement for building a cost-effective & scalable product.

For developers, this means focusing on input optimization is a critical lever for controlling costs, reducing latency, and ultimately, building a successful AI-powered product.

1,48K

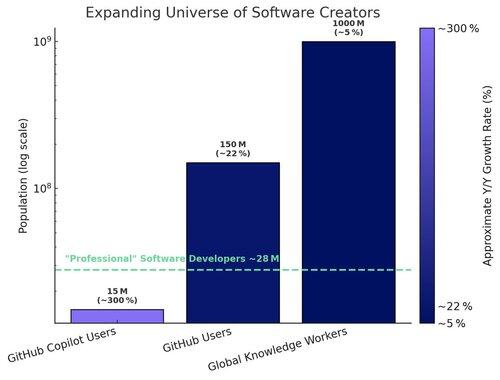

Hai bánh đà tăng cường đang thúc đẩy việc áp dụng AI IDE (môi trường phát triển tích hợp):

1. Bánh đà mô hình-sản phẩm:

Khi các mô hình nền tảng cải thiện (lập luận, lập kế hoạch, sử dụng công cụ), các AI IDE được xây dựng trên chúng ngay lập tức trở nên tốt hơn, thúc đẩy việc sử dụng sản phẩm nhiều hơn. Khi các AI IDE trở thành người tiêu thụ token chính, các nhà cung cấp mô hình nền tảng được khuyến khích tối ưu hóa cho những quy trình làm việc đó — làm tăng hiệu suất hơn nữa.

2. Bánh đà người dùng-dữ liệu:

Khi các AI IDE thu hút nhiều nhà phát triển hơn, chúng tạo ra dữ liệu sử dụng độc quyền (những gì các nhà phát triển hỏi, cách họ lập trình, nơi họ gặp khó khăn). Dữ liệu này có thể được sử dụng để đào tạo các mô hình chuyên biệt được tinh chỉnh cho chính IDE — dẫn đến trải nghiệm người dùng và hiệu suất tốt hơn, cùng với một rào cản sâu hơn.

#1 mang lại lợi ích cho danh mục. #2 mang lại lợi ích cho người dẫn đầu danh mục.

26,17K

Thật buồn cười khi tôi thấy Claude trả lời các câu hỏi về Gmail của tôi tốt hơn cả Google Gemini.

Các phiên bản mới nhất của Gemini vượt trội trong các bài kiểm tra hiệu suất và tôi đã nghe nói rằng chúng rất giỏi trong lập trình, nhưng việc sử dụng thực tế ứng dụng Gemini chưa bao giờ đạt được như ChatGPT, Claude, hoặc Grok.

224,55K

Chúng tôi đã xuất bản một tài liệu trắng với Coinbase vào tháng 1 năm 2017, 8 tháng trước khi họ huy động vòng Series D với định giá 1,6 tỷ đô la. Chúng tôi ngưỡng mộ cách tiếp cận của công ty trong việc đưa người dùng mới vào nền kinh tế tiền điện tử -> tập trung vào đổi mới với tốc độ sản phẩm cao trong khi vẫn tuân thủ quy tắc. Ngày nay, công ty có giá trị khoảng 65 tỷ đô la, đại diện cho lợi nhuận hàng năm khoảng 60% cho các nhà đầu tư Series D trong khoảng 8 năm qua.

Tesla, Palantir, và bây giờ là Coinbase: Tất cả các công ty mà thị trường cơ bản không hiểu và trừng phạt như thể họ đang phá sản, giờ đây được công nhận là những người dẫn đầu trong danh mục của họ và là một phần của S&P 500. Mặc dù chúng tôi vẫn nghĩ rằng một số năm tuyệt vời nhất của mỗi công ty này đang ở phía trước, việc tiếp cận đổi mới sớm, trước khi một công ty lọt vào các chỉ số lớn, là chìa khóa để xây dựng một danh mục đầu tư hoàn chỉnh.

ARK Invest14 thg 5, 2025

Coinbase is joining the S&P 500. To most, it’s a crypto milestone. To us, it’s a signal. 🧵

264,62K

Hàng đầu

Thứ hạng

Yêu thích

Onchain thịnh hành

Thịnh hành trên X

Ví funding hàng đầu gần đây

Được chú ý nhất