Tópicos populares

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Frank Downing

Sim.

Ouvi dizer que "os navegadores são a distribuição definitiva para agentes". Acho que isso está ao contrário.

Os agentes usarão navegadores como uma ferramenta, entre outras, para realizar tarefas.

Você deve pensar no agente como o produto, não no navegador.

Você paga pelo ChatGPT Agent, que ativa navegadores para realizar tarefas conforme necessário. Você pode assistir e intervir, mas não precisa.

Mesma direção para o Comet da Perplexity. Ele encontra os usuários onde estão hoje, mas com o tempo o agente irá conduzir cada vez mais e você se importará cada vez menos em ver como a salsicha é feita.

qw22/07, 03:12

os websites substituem a maioria das aplicações de desktop (últimas 2 décadas)

depois, os agentes substituem a maioria dos websites (próximas 2 décadas)

32,72K

Boas informações sobre a importância da "engenharia de contexto":

Os tokens de entrada podem ser mais baratos do que os tokens de saída, mas tarefas que exigem muito contexto (como programação) podem requerer 300-400x mais tokens de entrada de contexto do que tokens de saída, tornando o contexto 98% dos custos totais de uso de LLM.

A latência também aumenta com o tamanho do contexto.

Isso sublinha a importância de fornecer o contexto certo no momento certo ao construir aplicações de IA e, suponho, deixa muito espaço para diferenciação competitiva em aplicações SaaS nativas de IA.

Tomasz Tunguz9/07, 01:36

Quando você consulta a IA, ela reúne informações relevantes para te responder.

Mas, quanta informação o modelo precisa?

Conversas com profissionais revelaram a sua intuição: a entrada era ~20x maior que a saída.

Mas meus experimentos com a interface de linha de comando da ferramenta Gemini, que fornece estatísticas detalhadas de tokens, revelaram que é muito maior.

300x em média e até 4000x.

Aqui está o porquê dessa alta relação entrada-saída ser importante para quem está construindo com IA:

A Gestão de Custos é Tudo Sobre a Entrada. Com chamadas de API precificadas por token, uma relação de 300:1 significa que os custos são ditados pelo contexto, não pela resposta. Essa dinâmica de preços se mantém verdadeira em todos os principais modelos.

Na página de preços da OpenAI, os tokens de saída para o GPT-4.1 são 4x mais caros que os tokens de entrada. Mas quando a entrada é 300x mais volumosa, os custos de entrada ainda representam 98% da conta total.

A Latência é uma Função do Tamanho do Contexto. Um fator importante que determina quanto tempo um usuário espera por uma resposta é o tempo que o modelo leva para processar a entrada.

Isso Redefine o Desafio de Engenharia. Essa observação prova que o desafio central de construir com LLMs não é apenas a solicitação. É a engenharia de contexto.

A tarefa crítica é construir recuperação de dados eficiente e contexto - criando pipelines que podem encontrar as melhores informações e destilá-las na menor pegada de token possível.

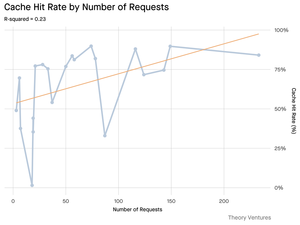

O Cache Torna-se Crítico. Se 99% dos tokens estão na entrada, construir uma camada de cache robusta para documentos frequentemente recuperados ou contextos de consulta comuns passa de um "bom de ter" para um requisito arquitetônico central para construir um produto escalável e econômico.

Para os desenvolvedores, isso significa que focar na otimização da entrada é uma alavanca crítica para controlar custos, reduzir latência e, em última análise, construir um produto bem-sucedido alimentado por IA.

1,47K

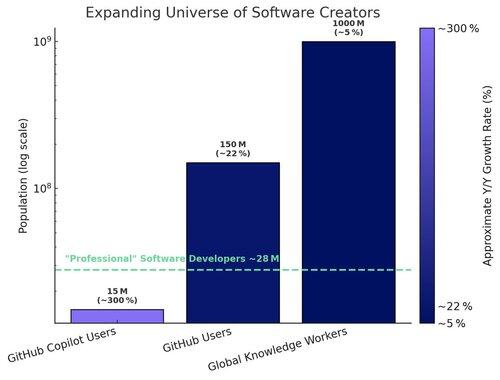

Dois volantes de reforço estão acelerando a adoção de IDEs de IA (ambiente de desenvolvimento integrado):

1. Volante modelo-produto:

À medida que os modelos fundamentais melhoram (raciocínio, planejamento, uso de ferramentas), as IDEs de IA construídas sobre eles instantaneamente se tornam melhores, impulsionando mais uso do produto. À medida que as IDEs de IA se tornam grandes consumidoras de tokens, os provedores de modelos fundamentais são incentivados a otimizar para esses fluxos de trabalho — aumentando ainda mais o desempenho.

2. Volante usuário-dados:

À medida que as IDEs de IA atraem mais desenvolvedores, elas geram dados de uso proprietários (o que os desenvolvedores perguntam, como codificam, onde ficam presos). Esses dados podem ser usados para treinar modelos especializados ajustados para a própria IDE — levando a uma melhor experiência do usuário e desempenho, e a uma barreira mais profunda.

O #1 beneficia a categoria. O #2 beneficia o líder da categoria.

26,16K

É engraçado para mim que o Claude faz um trabalho melhor ao responder perguntas sobre o meu Gmail do que o Gemini do Google.

As versões mais recentes do Gemini arrasam nos benchmarks e ouvi anedoticamente que são ótimas em programação, mas o uso real do aplicativo Gemini nunca se comparou para mim em relação ao ChatGPT, Claude ou Grok.

224,54K

Publicamos um whitepaper com a Coinbase em janeiro de 2017, 8 meses antes de eles levantarem sua rodada série D em uma avaliação de US$ 1,6 bilhão. Admiramos a abordagem da empresa para integrar novos usuários à economia cripto - > inclinando-se para a inovação com alta velocidade do produto enquanto joga de acordo com as regras. Hoje a empresa vale ~$65 bilhões, representando um retorno anualizado de aproximadamente 60% para os investidores da Série D nos últimos ~8 anos.

Tesla, Palantir e agora Coinbase: Todas as empresas que o mercado fundamentalmente não entendia e punia como se estivessem indo à falência, agora reconhecidas como líderes da categoria em seus respetivos espaços e parte do S&P 500. Embora ainda pensemos que alguns dos melhores anos para cada uma dessas empresas estão à sua frente, acessar a inovação cedo, antes de uma empresa entrar nos grandes índices, é fundamental para construir um portfólio completo.

ARK Invest14/05/2025

A Coinbase está se juntando ao S&P 500. Para a maioria, é um marco cripto. Para nós, é um sinal. 🧵

264,61K

Top

Classificação

Favoritos

Tendências on-chain

Popular no X

Principais financiamentos atuais

Mais notável