Trendande ämnen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Frank Downing

Ja.

Jag har hört att "webbläsare är den ultimata distributionen för agenter". Jag anser att detta är bakvänt.

Agenter kommer att använda webbläsare som ett verktyg, bland annat, för att utföra uppgifter.

Du kommer att tänka på agenten som produkten, inte webbläsaren.

Du betalar för ChatGPT Agent, som snurrar upp webbläsare för att utföra uppgifter efter behov. Du kan titta och hoppa in, men du behöver inte göra det.

Samma riktning för Perplexitys komet. Det möter användarna där de befinner sig idag, men med tiden kommer agenten att köra mer och mer och du kommer att bry dig mindre och mindre om att se hur korven tillverkas.

qw22 juli 03:12

Webbplatser ersätter de flesta skrivbordsprogram (senaste 2 decennierna)

Sedan ersätter agenter de flesta webbplatser (nästa 2 decennier)

32,73K

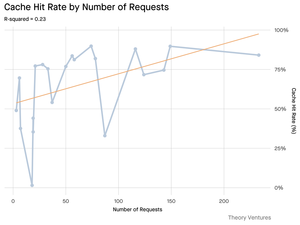

Bra data pekar på vikten av "context engineering":

Indatatoken kan vara billigare än utdatatoken, men kontexttunga uppgifter (som kodning) kan kräva 300-400 gånger fler indatatoken för kontext än utdatatoken, vilket gör kontext till 98 % av de totala LLM-användningskostnaderna.

Svarstiden växer också med större kontextstorlek.

Understryker vikten av att tillhandahålla rätt sammanhang vid rätt tidpunkt när man bygger AI-applikationer, och jag antar att det lämnar mycket utrymme för konkurrenskraftig differentiering i AI-navtive SaaS-appar.

Tomasz Tunguz9 juli 01:36

När du frågar AI samlar den in relevant information för att svara dig.

Men hur mycket information behöver modellen?

Samtal med utövare avslöjade deras intuition: indata var ~20 gånger större än output.

Men mina experiment med Gemini-verktygets kommandoradsgränssnitt, som matar ut detaljerad tokenstatistik, avslöjade att det är mycket högre.

300x i genomsnitt och upp till 4000x.

Här är anledningen till att det här höga input-to-output-förhållandet är viktigt för alla som bygger med AI:

Cost Management handlar om input. Med API-anrop prissatta per token innebär ett förhållande på 300:1 att kostnaderna dikteras av sammanhanget, inte svaret. Denna prisdynamik gäller för alla större modeller.

På OpenAI:s prissida är utdatatoken för GPT-4.1 4 gånger så dyra som indatatokens. Men när insatsen är 300 gånger mer omfattande är insatskostnaderna fortfarande 98 % av den totala räkningen.

Latens är en funktion av kontextstorleken. En viktig faktor som avgör hur länge en användare väntar på ett svar är den tid det tar för modellen att bearbeta indata.

Det omdefinierar den tekniska utmaningen. Denna observation bevisar att den största utmaningen med att bygga med LLM inte bara är att uppmana. Det är kontextteknik.

Den kritiska uppgiften är att bygga effektiv datahämtning och kontext – att skapa pipelines som kan hitta den bästa informationen och destillera den till minsta möjliga tokenfotavtryck.

Cachelagring blir verksamhetskritisk. Om 99 % av token finns i indata går byggandet av ett robust cachelagringslager för ofta hämtade dokument eller vanliga frågekontexter från ett "trevligt att ha" till ett grundläggande arkitektoniskt krav för att skapa en kostnadseffektiv och skalbar produkt.

För utvecklare innebär detta att fokus på inputoptimering är en viktig hävstång för att kontrollera kostnaderna, minska latensen och i slutändan bygga en framgångsrik AI-driven produkt.

1,48K

Två förstärkande svänghjul påskyndar införandet av AI IDE (integrerad utvecklingsmiljö):

1. Modell-produkt svänghjul:

I takt med att grundmodellerna förbättras (resonemang, planering, verktygsanvändning) blir AI-IDE:er som bygger på dem omedelbart bättre, vilket leder till ökad produktanvändning. I takt med att AI IDE:er blir stora tokenkonsumenter uppmuntras leverantörer av grundmodeller att optimera för dessa arbetsflöden – vilket ytterligare ökar prestandan.

2. Svänghjul för användardata:

I takt med att AI IDE:er lockar fler utvecklare genererar de proprietära användningsdata (vad utvecklare frågar, hur de kodar, var de fastnar). Dessa data kan användas för att träna specialiserade modeller som är finjusterade för själva IDE – vilket leder till bättre UX och prestanda och en djupare vallgrav.

#1 gynnar kategorin. #2 gynnar kategoriledaren.

26,17K

Det är roligt för mig att Claude gör ett bättre jobb med att svara på frågor om min Gmail som Googles Gemini gör.

De senaste versionerna av Gemini krossar den på benchmarks och har hört att de är bra på att koda, men verklig användning av Gemini-appen har aldrig matchat för mig i förhållande till ChatGPT, Claude eller Grok

224,55K

Vi publicerade ett whitepaper med Coinbase i januari 2017, 8 månader innan de höjde sin serie D-runda till en värdering på 1,6 miljarder dollar. Vi beundrade företagets tillvägagångssätt för att ta in nya användare i kryptoekonomin > att luta sig mot innovation med hög produkthastighet samtidigt som de spelar enligt reglerna. Idag är företaget värt ~65 miljarder dollar, vilket motsvarar en årlig avkastning på ungefär 60% till serie D-investerare under de senaste ~8 åren.

Tesla, Palantir och nu Coinbase: Alla företag som marknaden i grunden inte förstod och straffade som om de skulle gå i konkurs, erkändes nu som kategoriledare inom sina respektive områden och en del av S&P 500. Även om vi fortfarande tror att några av de bästa åren för vart och ett av dessa företag ligger framför dem, är det viktigt att få tillgång till innovation tidigt, innan ett företag tar sig in i de stora indexen, för att bygga en komplett portfölj.

ARK Invest14 maj 2025

Coinbase ansluter sig till S&P 500. För de flesta är det en milstolpe för krypto. För oss är det en signal. 🧵

264,62K

Topp

Rankning

Favoriter

Trendande på kedjan

Trendande på X

Senaste toppfinansieringarna

Mest anmärkningsvärda