热门话题

#

Bonk 生态迷因币展现强韧势头

#

有消息称 Pump.fun 计划 40 亿估值发币,引发市场猜测

#

Solana 新代币发射平台 Boop.Fun 风头正劲

Frank Downing

是的。

我听说过“浏览器是代理的终极分发工具”。我认为这是错误的。

代理将把浏览器作为工具之一来完成任务。

你会把代理视为产品,而不是浏览器。

你为 ChatGPT 代理付费,它会根据需要启动浏览器来完成任务。你可以观看并参与,但你不必这样做。

Perplexity 的 Comet 也是同样的方向。它在用户当前的位置满足他们,但随着时间的推移,代理将驱动越来越多,而你会越来越不关心制作香肠的过程。

qw7月22日 03:12

网站取代了大多数桌面应用程序(过去20年)

然后代理取代了大多数网站(未来20年)

32.74K

关于“上下文工程”重要性的良好数据点:

输入令牌可能比输出令牌便宜,但上下文密集型任务(如编码)可能需要300-400倍于输出令牌的上下文输入令牌,使得上下文占总LLM使用成本的98%。

延迟也随着上下文大小的增加而增长。

强调了在构建AI应用时在正确的时间提供正确上下文的重要性,并且,我想,这为AI原生SaaS应用中的竞争差异化留下了很大的空间。

Tomasz Tunguz7月9日 01:36

当你查询AI时,它会收集相关信息来回答你。

但是,模型需要多少信息呢?

与从业者的对话揭示了他们的直觉:输入大约是输出的20倍。

但我使用Gemini工具命令行界面进行的实验显示,这个比例要高得多。

平均300倍,最高可达4000倍。

以下是这个高输入与输出比率对任何与AI构建相关的人来说的重要性:

成本管理完全取决于输入。由于API调用按令牌计费,300:1的比例意味着成本由上下文决定,而不是答案。这个定价动态在所有主要模型中都适用。

在OpenAI的定价页面上,GPT-4.1的输出令牌价格是输入令牌的4倍。但当输入的体量是300倍时,输入成本仍占总账单的98%。

延迟是上下文大小的函数。决定用户等待答案时间的重要因素是模型处理输入所需的时间。

它重新定义了工程挑战。这一观察证明,使用LLM构建的核心挑战不仅仅是提示,而是上下文工程。

关键任务是构建高效的数据检索和上下文——设计能够找到最佳信息并将其提炼成尽可能小的令牌足迹的管道。

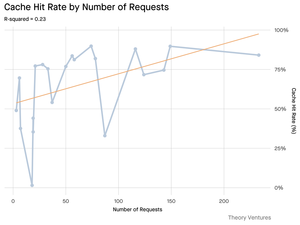

缓存变得至关重要。如果99%的令牌在输入中,为频繁检索的文档或常见查询上下文构建一个强大的缓存层,从“可有可无”变成了构建一个具有成本效益和可扩展产品的核心架构要求。

对于开发者来说,这意味着关注输入优化是控制成本、减少延迟以及最终构建成功的AI驱动产品的关键杠杆。

1.49K

我们在2017年1月与Coinbase合作发布了一份白皮书,比他们在8个月后以16亿美元估值完成D轮融资早了一步。我们钦佩该公司在引导新用户进入加密经济方面的方式——以高产品速度推动创新,同时遵守规则。如今,该公司的市值约为650亿美元,这意味着在过去约8年中,D轮投资者获得了约60%的年化回报。

特斯拉、Palantir以及现在的Coinbase:这些公司曾被市场严重误解并受到惩罚,仿佛它们濒临破产,但如今它们被公认为各自领域的领导者,并成为标普500的一部分。虽然我们仍然认为这些公司最辉煌的年份还在未来,但在公司进入大型指数之前,尽早接触创新是构建完整投资组合的关键。

ARK Invest2025年5月14日

Coinbase 正在加入 S&P 500。对大多数人来说,这是一个加密里程碑。对我们来说,这是一个信号。🧵

264.63K

热门

排行

收藏

链上热点

X 热门榜

近期融资

最受认可