Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

EigenPhi HQ 🎯 Wisdom of DeFi (🔭, 🎙) 🦇🔊

Les cas d'utilisation de l'IA d'entreprise sont souvent là où la vérification devient compliquée. Mais si vous pouvez exploiter des journaux structurés, l'intention économique ou le comportement des agents, vous pouvez renforcer le signal. Travaillons ensemble pour intégrer ces comportements vérifiables dans les régimes d'entraînement des modèles.

Salesforce AI Research24 sept., 08:57

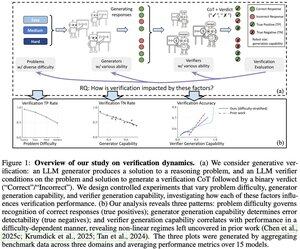

📣 Variation dans la vérification : Comprendre la dynamique de la vérification dans les grands modèles de langage

📄 Document :

🔗 Projet :

Vous vous êtes déjà demandé si votre vérificateur de LLM est réellement fiable pour votre tâche ? Notre cadre d'analyse révèle trois facteurs clés qui déterminent le succès de la vérification en fonction de la difficulté du problème, de la capacité du générateur et de la capacité du vérificateur.

Principales conclusions :

📈 La difficulté du problème influence la reconnaissance des réponses correctes - les vérificateurs excellent sur les problèmes faciles mais ont du mal avec les difficiles

🔍 La force du générateur affecte la détection des erreurs - les générateurs faibles produisent des erreurs évidentes, les forts créent des solutions élégantes mais incorrectes

⚖️ L'échelle du vérificateur montre des rendements décroissants dans certains régimes - parfois GPT-4o dépasse à peine les modèles plus petits

💡 Pour l'échelle de test : générateurs faibles + vérification peuvent égaler la performance des générateurs forts, et les vérificateurs coûteux ne valent pas toujours le coup.

Excellent travail de Yefan Zhou @LiamZhou98, Austin Xu @austinsxu, Yilun Zhou @YilunZhou, Janvijay Singh @iamjanvijay, Jiang Gui @JiangGui, Shafiq Joty @JotyShafiq !

#LLM #AIVerification #TestTimeScaling #FutureOfAI #EnterpriseAI

754

Bravo à l'équipe TOOL 👏 Élever Ethereum en tant que coprocesseur hyperscale est un changement de jeu. De notre côté, l'infrastructure de mise à l'échelle ne prospère que lorsqu'elle est associée à des données transparentes et auditées sur le traitement des transactions et la priorisation. Sans cela, la finalité à faible latence ouvre la porte à la centralisation.

0xprincess24 sept., 22:26

1// Nous sommes fiers d'annoncer le lancement du Testnet TOOL !

3,36K

La loi du vérificateur est une excellente perspective, Jason. Je suis curieux de savoir ce que tu penses de domaines comme la cryptographie ou les enregistrements on-chain—où la vérification est presque gratuite mais la complexité des solutions explose ? 💭🔐

Jason Wei16 juil. 2025

Nouveau billet de blog sur l’asymétrie de la vérification et la « loi du vérificateur » :

L’asymétrie de vérification – l’idée que certaines tâches sont beaucoup plus faciles à vérifier qu’à résoudre – devient une idée importante depuis que nous avons l’apprentissage par renforcement qui fonctionne enfin en général.

D’excellents exemples d’asymétrie de vérification sont des choses comme les puzzles sudoku, l’écriture du code pour un site Web comme Instagram et les problèmes BrowseComp (il faut ~100 sites Web pour trouver la réponse, mais facile à vérifier une fois que vous avez la réponse).

D’autres tâches ont une quasi-symétrie de vérification, comme la somme de deux nombres à 900 chiffres ou certains scripts de traitement de données. Pourtant, il est beaucoup plus facile de proposer des solutions réalisables pour d’autres tâches que de les vérifier (par exemple, vérifier les faits d’un long essai ou énoncer un nouveau régime alimentaire comme « ne mangez que du bison »).

Une chose importante à comprendre à propos de l’asymétrie de vérification est que vous pouvez améliorer l’asymétrie en effectuant un travail au préalable. Par exemple, si vous avez le corrigé d’un problème mathématique ou si vous avez des cas de test pour un problème Leetcode. Cela augmente considérablement l’ensemble des problèmes avec l’asymétrie de vérification souhaitable.

La « loi du vérificateur » stipule que la facilité d’entraînement de l’IA à résoudre une tâche est proportionnelle à la vérifiabilité de la tâche. Toutes les tâches qui sont possibles à résoudre et faciles à vérifier seront résolues par l’IA. La capacité d’entraîner l’IA à résoudre une tâche est proportionnelle au fait que la tâche possède les propriétés suivantes :

1. Vérité objective : tout le monde s’accorde sur ce que sont les bonnes solutions

2. Vérification rapide : n’importe quelle solution peut être vérifiée en quelques secondes

3. Évolutif à vérifier : de nombreuses solutions peuvent être vérifiées simultanément

4. Faible bruit : la vérification est aussi étroitement corrélée que possible à la qualité de la solution

5. Récompense continue : il est facile de classer les qualités de plusieurs solutions pour un seul problème

Une instanciation évidente de la loi du vérificateur est le fait que la plupart des points de référence proposés en IA sont faciles à vérifier et ont jusqu’à présent été résolus. Notez que pratiquement tous les benchmarks populaires au cours des dix dernières années correspondent aux critères #1-4 ; Les benchmarks qui ne répondent pas aux critères #1-4 auraient du mal à devenir populaires.

Pourquoi la vérifiabilité est-elle si importante ? La quantité d’apprentissage en IA qui se produit est maximisée lorsque les critères ci-dessus sont satisfaits ; Vous pouvez prendre beaucoup d’étapes de gradient où chaque étape a beaucoup de signal. La vitesse d’itération est essentielle : c’est la raison pour laquelle les progrès dans le monde numérique ont été beaucoup plus rapides que les progrès dans le monde physique.

AlphaEvolve de Google est l’un des meilleurs exemples d’exploitation de l’asymétrie de vérification. Il se concentre sur des configurations qui répondent à tous les critères ci-dessus et a conduit à un certain nombre d’avancées en mathématiques et dans d’autres domaines. Différent de ce que nous avons fait dans l’IA au cours des deux dernières décennies, il s’agit d’un nouveau paradigme dans lequel tous les problèmes sont optimisés dans un cadre où le train est équivalent au test.

L’asymétrie de vérification est partout, et il est passionnant d’envisager un monde d’intelligence déchiquetée où tout ce que nous pouvons mesurer sera résolu.

887

Meilleurs

Classement

Favoris