トレンドトピック

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

EigenPhi HQ 🎯 Wisdom of DeFi (🔭, 🎙) 🦇🔊

エンタープライズ AI のユースケースでは、検証が厄介になることがよくあります。しかし、構造化されたログ、経済的意図、またはエージェントの行動を活用できれば、シグナルを強化できます。これらの検証可能な動作をモデルトレーニング体制に取り入れるために協力しましょう。

Salesforce AI Research9月24日 08:57

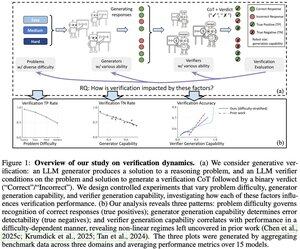

📣 検証のバリエーション: 大規模言語モデルにおける検証ダイナミクスの理解

📄 紙:

🔗 プロジェクト:

LLM 検証ツールが実際にあなたのタスクに対して信頼できるかどうか疑問に思ったことはありませんか?当社の分析フレームワークは、問題の難易度、ジェネレータ能力、および検証者の能力全体で検証の成功を決定する3つの重要な要素を明らかにします。

主な洞察:

📈 問題の難易度が正しい応答の認識を促進する - 検証者は簡単な問題には優れていますが、難しい問題には苦労します

🔍 ジェネレーターの強度はエラー検出に影響します - 弱いジェネレーターは明らかな間違いを生み出し、強いジェネレーターはエレガントだが間違ったソリューションを作成します

⚖️ 検証者のスケーリングは、特定の体制で収益が逓減を示す - GPT-4o が小規模なモデルをかろうじて上回ることもある

💡 テスト時のスケーリングの場合: 弱いジェネレーター + 検証は強力なジェネレーターのパフォーマンスに匹敵する可能性がありますが、高価な検証ツールは必ずしも価値があるとは限りません。

Yefan Zhou @LiamZhou98、Austin Xu @austinsxu、Yilun Zhou @YilunZhou、Janvijay Singh @iamjanvijay、Jiang Gui @JiangGui、Shafiq Joty @JotyShafiqによる素晴らしい作品です!

#LLM #AIVerification #TestTimeScaling #FutureOfAI #EnterpriseAI

740

TOOL チーム👏に敬意を表しますイーサリアムをハイパースケール コプロセッサに昇格させることは、ゲームチェンジャーです。私たちの側では、スケーリング インフラストラクチャは、トランザクション処理と優先順位付けに関する透明で監査可能なデータと一致した場合にのみ繁栄します。これがなければ、低遅延のファイナリティは集中化への扉を開きます。

0xprincess9月24日 22:26

1// TOOLテストネットの立ち上げを発表できることを誇りに思います!

3.34K

検証者の法則は素晴らしいレンズです、ジェイソン。暗号化やオンチェーン レコードなど、検証はほぼ無料であるが、ソリューションの複雑さが爆発的に増すドメインについてどう思いますか?💭🔐

Jason Wei2025年7月16日

New blog post about asymmetry of verification and "verifier's law":

Asymmetry of verification–the idea that some tasks are much easier to verify than to solve–is becoming an important idea as we have RL that finally works generally.

Great examples of asymmetry of verification are things like sudoku puzzles, writing the code for a website like instagram, and BrowseComp problems (takes ~100 websites to find the answer, but easy to verify once you have the answer).

Other tasks have near-symmetry of verification, like summing two 900-digit numbers or some data processing scripts. Yet other tasks are much easier to propose feasible solutions for than to verify them (e.g., fact-checking a long essay or stating a new diet like "only eat bison").

An important thing to understand about asymmetry of verification is that you can improve the asymmetry by doing some work beforehand. For example, if you have the answer key to a math problem or if you have test cases for a Leetcode problem. This greatly increases the set of problems with desirable verification asymmetry.

"Verifier's law" states that the ease of training AI to solve a task is proportional to how verifiable the task is. All tasks that are possible to solve and easy to verify will be solved by AI. The ability to train AI to solve a task is proportional to whether the task has the following properties:

1. Objective truth: everyone agrees what good solutions are

2. Fast to verify: any given solution can be verified in a few seconds

3. Scalable to verify: many solutions can be verified simultaneously

4. Low noise: verification is as tightly correlated to the solution quality as possible

5. Continuous reward: it’s easy to rank the goodness of many solutions for a single problem

One obvious instantiation of verifier's law is the fact that most benchmarks proposed in AI are easy to verify and so far have been solved. Notice that virtually all popular benchmarks in the past ten years fit criteria #1-4; benchmarks that don’t meet criteria #1-4 would struggle to become popular.

Why is verifiability so important? The amount of learning in AI that occurs is maximized when the above criteria are satisfied; you can take a lot of gradient steps where each step has a lot of signal. Speed of iteration is critical—it’s the reason that progress in the digital world has been so much faster than progress in the physical world.

AlphaEvolve from Google is one of the greatest examples of leveraging asymmetry of verification. It focuses on setups that fit all the above criteria, and has led to a number of advancements in mathematics and other fields. Different from what we've been doing in AI for the last two decades, it's a new paradigm in that all problems are optimized in a setting where the train set is equivalent to the test set.

Asymmetry of verification is everywhere and it's exciting to consider a world of jagged intelligence where anything we can measure will be solved.

873

トップ

ランキング

お気に入り