Trendande ämnen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Dubbel nedstigning visar att Lucas-kritiken endast gäller lokalt.

dvs. modellfelet ökar med fler parametrar upp till en punkt ("överanpassning"), men sjunker sedan med fler parametrar.

Det var ett misstag av ekonomin att förenkla modeller för påstådd out-of-sample passning — fortsätt bara!

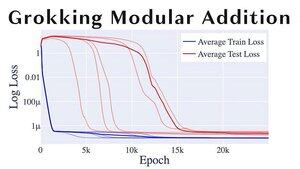

Ett annat roligt ML-ämne är "grokking" där modeller går från överanpassning till generalisering ganska abrupt.

Om du är @alz_zyd_ antar jag att du säger att detta är tecknet på att modellen bara är en tänkande varelse och börjar förstå

108,72K

Topp

Rankning

Favoriter