Tendencias del momento

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

El doble descenso muestra que la Crítica de Lucas solo se aplica localmente.

Es decir, el error del modelo aumenta con más parámetros hasta un punto ("sobreajuste"), pero luego disminuye con más parámetros.

Fue un error para la economía simplificar los modelos para un supuesto ajuste fuera de muestra — ¡sigue adelante!

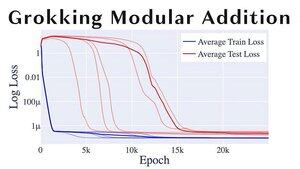

Otro tema divertido de ML es "grokking", en el que los modelos pasan de sobreajustarse a generalizar de manera bastante abrupta.

Si eres @alz_zyd_, supongo que dirías que esta es la señal de que el modelo es solo un ser pensante y comienza a grok.

108,71K

Parte superior

Clasificación

Favoritos