Tópicos populares

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

O duplo descenso mostra que a Crítica de Lucas se aplica apenas localmente.

Ou seja, o erro do modelo aumenta com mais parâmetros até um certo ponto ("overfitting"), mas depois diminui com mais parâmetros.

Foi um erro para a economia simplificar modelos para um suposto ajuste fora da amostra — basta continuar!

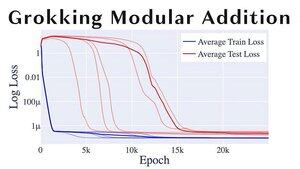

Outro tópico divertido de ML é "grokking", no qual os modelos mudam de sobreajuste para generalização de forma bastante abrupta.

Se você é @alz_zyd_, eu suponho que você diga que este é o sinal de que o modelo é apenas um ser pensante e começa a grok.

108,72K

Top

Classificação

Favoritos