Populární témata

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Dvojitý sestup ukazuje, že Lucasova kritika platí pouze místně.

Tj. chyba modelu roste s více parametry až do určitého bodu ("přepřimínání"), ale pak klesá s dalšími parametry.

Byla chyba ekonomie zjednodušit modely pro údajné neshodné vzorek — prostě pokračujte!

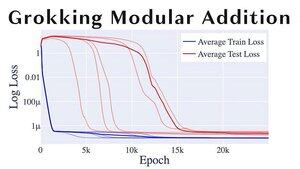

Dalším zábavným tématem ML je "grokking", kdy modely poměrně náhle přecházejí z přemíry k zobecňování.

Pokud @alz_zyd_, asi říkáte, že je to znamení, že model je jen myslící bytost a začíná chápat

27,32K

Top

Hodnocení

Oblíbené