Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Dobbel nedstigning viser at Lucas-kritikken kun gjelder lokalt.

Altså, modellfeilen øker med flere parametere opp til et punkt ("overfitting"), men faller deretter med flere parametere.

Det var en feil av økonomi å forenkle modeller for antatt utvalgstilpasning — bare fortsett!

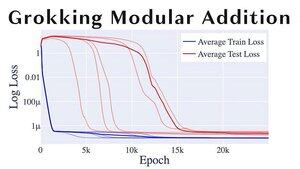

Et annet morsomt ML-tema er «grokking», hvor modellene går fra overtilpasning til generalisering ganske brått.

Hvis du er @alz_zyd_, antar jeg at du sier dette er tegnet på at modellen bare er et tenkende vesen og begynner å forstå

108,7K

Topp

Rangering

Favoritter