Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Il doppio abbassamento mostra che la Critica di Lucas si applica solo localmente.

Cioè, l'errore del modello aumenta con un numero maggiore di parametri fino a un certo punto ("overfitting"), ma poi diminuisce con un numero maggiore di parametri.

È stato un errore per l'economia semplificare i modelli per un presunto adattamento fuori campione — continua così!

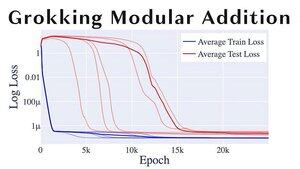

Un altro argomento divertente di ML è "grokking", in cui i modelli passano dall'overfitting alla generalizzazione in modo piuttosto brusco.

Se sei @alz_zyd_, immagino che tu dica che questo è il segno che il modello è solo un essere pensante e inizia a grok.

108,71K

Principali

Ranking

Preferiti