トレンドトピック

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

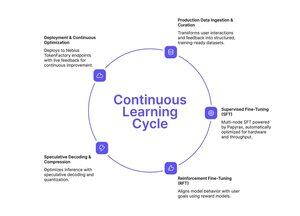

もしTinkerの簡素化された微調整のアプローチを追っているなら、Nebius Token Factoryが似たようなものをリリースしましたが、生産規模向けに作られています。

Nebius Token Factoryでのトレーニング後、フロンティア型LLM(DeepSeek V3、GPT-OSS 120B、Qwen3 Coder 480B)をマルチノードクラスター間でファインチューニングし、エンタープライズグレードのエンドポイントに即座に展開できます。

- 480Bパラメータまでのモデル向けのフルSFT+LoRA FT

- インフラ構築なしのマルチノードトレーニング(8-512 GPU)

- 最大131,000トークンまでのロングコンテキスト安定性

- ライブログからの本番データ取り込み

- SLAとゼロリテンションプライバシーによるワンクリック展開

トレーニング、最適化、展開、サービスがすべて一つのプラットフォームで提供されます。

もし本番トラフィックにスケールし、予測可能な遅延とデータプライバシーを持つカスタムモデルが必要なら、検討する価値があります。

1/2

トップ

ランキング

お気に入り