Tendencias del momento

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

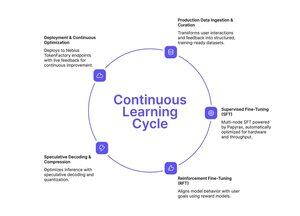

Si has estado siguiendo el enfoque de Tinker para el ajuste fino simplificado, Nebius Token Factory acaba de lanzar algo similar, pero construido para escalas de producción.

El post-entrenamiento en Nebius Token Factory te permite ajustar modelos LLM de frontera (DeepSeek V3, GPT-OSS 120B, Qwen3 Coder 480B) a través de clústeres multinodo y desplegarlos instantáneamente en puntos finales de nivel empresarial.

- SFT completo + LoRA FT para modelos de hasta 480B parámetros

- Entrenamiento multinodo (8-512 GPUs) sin configuración de infraestructura

- Estabilidad de contexto largo de hasta 131k tokens

- Ingesta de datos de producción a partir de registros en vivo

- Despliegue con un clic con SLA y privacidad de cero retención

El pipeline completo: entrenamiento, optimización, despliegue y servicio, todo en una sola plataforma.

Si necesitas modelos personalizados que realmente escalen al tráfico de producción con latencia predecible y privacidad de datos, esto vale la pena explorar.

1/2

Parte superior

Clasificación

Favoritos