Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

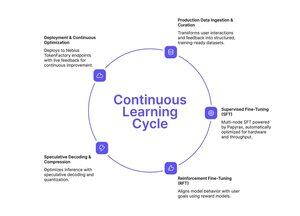

Hvis du har fulgt Tinkers tilnærming til forenklet finjustering, har Nebius Token Factory nettopp lansert noe lignende – men bygget for produksjonsskala.

Ettertrening på Nebius Token Factory lar deg finjustere grense-LLM-er (DeepSeek V3, GPT-OSS 120B, Qwen3 Coder 480B) på tvers av klynger med flere noder og distribuere dem umiddelbart til endepunkter på bedriftsnivå.

- Full SFT + LoRA FT for modeller opp til 480B parametere

- Multi-node-trening (8-512 GPU-er) uten infrastrukturoppsett

- Lang-kontekst stabilitet opp til 131 000 tokens

- Innsamling av produksjonsdata fra levende logger

- Ett-klikk-implementering med SLA-er og null-retensjonspersonvern

Hele pipelinen: opplæring, optimalisering, utrulling og servering – alt i én plattform.

Hvis du trenger tilpassede modeller som faktisk skalerer til produksjonstrafikk med forutsigbar ventetid og datafred, er dette verdt å utforske.

1/2

Topp

Rangering

Favoritter