Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

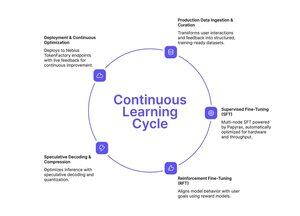

Se hai seguito l'approccio di Tinker al fine-tuning semplificato, Nebius Token Factory ha appena lanciato qualcosa di simile - ma costruito per la scala di produzione.

Il post-training su Nebius Token Factory ti consente di affinare i LLM di frontiera (DeepSeek V3, GPT-OSS 120B, Qwen3 Coder 480B) attraverso cluster multi-nodo e di distribuirli istantaneamente a endpoint di livello enterprise.

- Full SFT + LoRA FT per modelli fino a 480B parametri

- Addestramento multi-nodo (8-512 GPU) senza configurazione dell'infrastruttura

- Stabilità del contesto lungo fino a 131k token

- Ingestione di dati di produzione da log live

- Distribuzione con un clic con SLA e privacy senza retention

L'intero pipeline: addestramento, ottimizzazione, distribuzione e servizio - tutto in un'unica piattaforma.

Se hai bisogno di modelli personalizzati che scalino effettivamente al traffico di produzione con latenza prevedibile e privacy dei dati, questo vale la pena esplorarlo.

1/2

Principali

Ranking

Preferiti