Актуальні теми

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

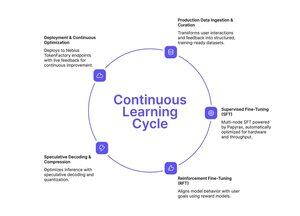

Якщо ви слідували підходу Tinker до спрощеного тонкого налаштування, Nebius Token Factory щойно запустила щось подібне — але створене для масштабу виробництва.

Післянавчання на Nebius Token Factory дозволяє тонко налаштовувати LLM Frontier (DeepSeek V3, GPT-OSS 120B, Qwen3 Coder 480B) у багатовузлових кластерах і миттєво розгортати їх на корпоративних кінцевих точках.

- Повний SFT + LoRA FT для моделей з параметрами до 480B

- Багатовузлове навчання (8-512 GPU) без налаштування інфраструктури

- Стабільність довгого контексту до 131k токенів

- Поглинання виробничих даних із живих логів

- Розгортання в один клік із SLA та нульове збереження конфіденційності

Повний конвеєр: навчання, оптимізація, розгортання та обслуговування — все в одній платформі.

Якщо вам потрібні кастомні моделі, які дійсно масштабуються під продакшн трафік із передбачуваною затримкою та конфіденційністю даних, це варто дослідити.

1/2

Найкращі

Рейтинг

Вибране