热门话题

#

Bonk 生态迷因币展现强韧势头

#

有消息称 Pump.fun 计划 40 亿估值发币,引发市场猜测

#

Solana 新代币发射平台 Boop.Fun 风头正劲

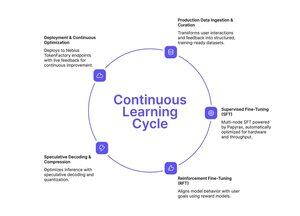

如果你一直关注 Tinker 的简化微调方法,Nebius Token Factory 刚刚推出了类似的东西——但它是为生产规模而构建的。

在 Nebius Token Factory 上进行后训练可以让你在多节点集群中微调前沿 LLM(DeepSeek V3、GPT-OSS 120B、Qwen3 Coder 480B),并立即将它们部署到企业级端点。

- 支持高达 480B 参数的完整 SFT + LoRA FT

- 无需基础设施设置的多节点训练(8-512 个 GPU)

- 长上下文稳定性高达 131k 个令牌

- 从实时日志中进行生产数据摄取

- 一键部署,附带服务水平协议和零保留隐私

完整的流程:训练、优化、部署和服务——全部在一个平台上。

如果你需要能够实际扩展到生产流量的自定义模型,并且具有可预测的延迟和数据隐私,这值得探索。

1/2

热门

排行

收藏