Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Jürgen Schmidhuber

Principes inventifs du méta-apprentissage (1987), des GAN (1990), des Transformers (1991), du très deep learning (1991), etc. Notre IA est utilisée plusieurs milliards de fois chaque jour.

IA physique il y a 10 ans : un robot bébé invente ses propres expériences pour améliorer son modèle de monde neural

Kompella, Stollenga, Luciw, Schmidhuber. Acquisition continue de compétences motivée par la curiosité à partir d'entrées vidéo de haute dimension pour des robots humanoïdes. Intelligence Artificielle, 2015

10,54K

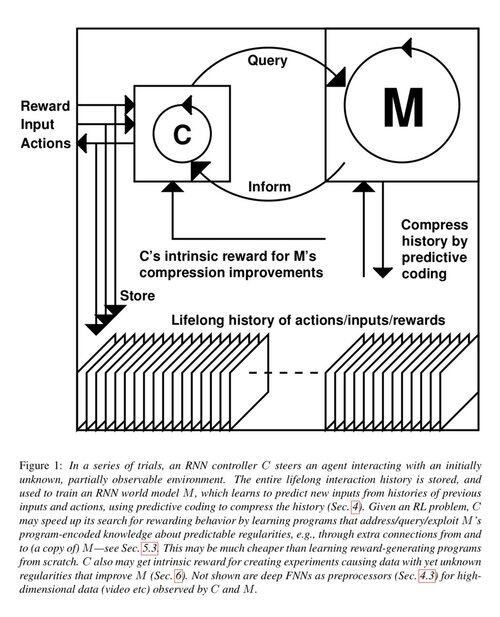

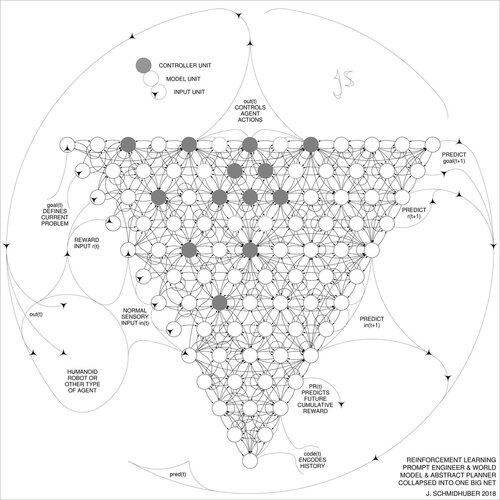

Il y a 1 décennie : Ingénieur en prompts d'apprentissage par renforcement dans la section 5.3 de « Learning to Think … » [2]. Chaîne de pensée adaptative ! Un réseau d'apprentissage par renforcement apprend à interroger un autre réseau pour le raisonnement abstrait et la prise de décision. Allant au-delà du modèle mondial de 1990 pour une planification milliseconde par milliseconde [1].

[2] J. Schmidhuber (JS, 2015). « On Learning to Think: Algorithmic Information Theory for Novel Combinations of RL Controllers and Recurrent Neural World Models. » ArXiv 1210.0118

[1] JS (1990). “Making the world differentiable: On using fully recurrent self-supervised neural networks for dynamic reinforcement learning and planning in non-stationary environments.” TR FKI-126-90, TUM. (Ce rapport a également introduit la curiosité artificielle et la motivation intrinsèque à travers des réseaux antagonistes génératifs.)

23,37K

Il y a 10 ans, en mai 2015, nous avons publié les premiers réseaux de neurones à propagation avant (FNN) très profonds basés sur des gradients, avec des centaines de couches (les FNN précédents avaient un maximum de quelques dizaines de couches). Pour surmonter le problème du gradient qui disparaît, nos réseaux autoroutiers ont utilisé les connexions résiduelles introduites pour la première fois en 1991 par @HochreiterSepp pour obtenir un flux d'erreur constant dans les réseaux de neurones récurrents (RNN), contrôlé par des portes multiplicatives similaires aux portes d'oubli (Gers et al., 1999) de notre RNN LSTM très profond. Les réseaux autoroutiers ont été rendus possibles grâce au travail de mes anciens doctorants @rupspace et Klaus Greff. Régler les portes du réseau autoroutier à 1,0 nous donne effectivement le ResNet publié 7 mois plus tard.

L'apprentissage profond concerne essentiellement la profondeur des réseaux de neurones. Les LSTM ont apporté une profondeur essentiellement illimitée aux RNN ; les réseaux autoroutiers l'ont apportée aux FNN.

20,57K

1991 : première distillation de réseau de neurones [1-3]. Je l'appelais "effondrement" à l'époque, pas "distillation".

Références

[1] J. Schmidhuber (1991). Chunkers de séquence neuronale. Rapport technique FKI-148-91, Université technique de Munich. Sec. 3.2.2. & Sec. 4 traitent de "l'effondrement" ou "de la distillation" ou "de la compression" des connaissances d'un réseau de neurones dans un autre réseau de neurones.

[2] JS (1992). Apprentissage de séquences complexes et étendues en utilisant le principe de compression de l'histoire. Neural Computation, 4(2) : 234-242, 1992. Basé sur [1].

[3] JS (AI Blog, 2021, mis à jour en 2025). 1991 : Premier apprentissage très profond avec pré-entraînement non supervisé. Première distillation de réseau de neurones.

16,06K

Tout le monde parle de l’auto-amélioration récursive et des machines de Gödel maintenant et de la façon dont cela conduira à l’AGI. Quel changement par rapport à il y a 15 ans ! Nous avons organisé l’AGI'2010 à Lugano et présidé l’AGI'2011 chez Google. L’épine dorsale des conférences AGI était l’IA universelle mathématiquement optimale : la machine Gödel de 2003 ( et l’AIXI de @mhutter42 - voir son livre UAI de 2005 et sa récente mise à jour de 2024 ( Je suis fier que le travail AIXI de Marcus Hutter ait été financé par ma bourse suisse SNF 2000 lorsqu’il était postdoc à l’IDSIA.

57,02K

L’IAG ? Un jour, mais pas encore. La seule IA qui fonctionne bien à l’heure actuelle est celle derrière l’écran [12-17]. Mais réussir le test de Turing [9] derrière un écran est facile comparé à l’IA réelle pour de vrais robots dans le monde réel. Aucun robot actuel piloté par l’IA ne pourrait être certifié en tant que plombier [13-17]. Par conséquent, le test de Turing n’est pas une bonne mesure de l’intelligence (et le QI non plus). Et l’IAG sans maîtrise du monde physique n’est pas une AGI. C’est pourquoi j’ai créé le TUM CogBotLab pour les robots d’apprentissage en 2004 [5], co-fondé une entreprise pour l’IA dans le monde physique en 2014 [6], et j’ai fait travailler des équipes chez TUM, IDSIA, et maintenant KAUST sur les bébés robots [4,10-11,18]. De tels robots mous ne se contentent pas d’imiter servilement les humains et ils ne fonctionnent pas simplement en téléchargeant le Web comme les LLM / VLM. Non. Au lieu de cela, ils exploitent les principes de la curiosité artificielle pour améliorer leurs modèles de monde neuronal (deux termes que j’ai utilisés en 1990 [1-4]). Ces robots fonctionnent avec de nombreux capteurs, mais seulement des actionneurs faibles, de sorte qu’ils ne peuvent pas facilement se nuire [18] lorsqu’ils collectent des données utiles en concevant et en exécutant leurs propres expériences qu’ils ont eux-mêmes inventées.

Remarquablement, depuis les années 1970, beaucoup se sont moqués de mon ancien objectif de construire une AGI qui s’améliore elle-même, plus intelligente que moi, puis de prendre ma retraite. Récemment, cependant, beaucoup ont finalement commencé à prendre cela au sérieux, et maintenant certains d’entre eux sont soudainement TROP optimistes. Ces personnes sont souvent parfaitement inconscientes des défis qu’il nous reste à résoudre pour parvenir à une véritable IA. Ma conférence TED de 2024 [15] résume une partie de cela.

RÉFÉRENCES (faciles à trouver sur le web) :

[1] J. Schmidhuber. Rendre le monde différenciable : sur l’utilisation de réseaux neuronaux auto-supervisés (NN) entièrement récurrents pour l’apprentissage par renforcement dynamique et la planification dans des environnements non stationnaires. TR FKI-126-90, TUM, février 1990, révisé en novembre 1990. Cet article a également introduit la curiosité artificielle et la motivation intrinsèque par le biais de réseaux antagonistes génératifs où un générateur NN combat un prédicteur NN dans un jeu minimax.

[2] J. S. Une possibilité d’implémenter la curiosité et l’ennui dans les contrôleurs neuronaux de construction de modèles. Dans J. A. Meyer et S. W. Wilson, éditeurs, Proc. de la Conférence internationale sur la simulation du comportement adaptatif : des animaux aux animats, pages 222-227. MIT Press/Bradford Books, 1991. Basé sur [1].

[3] Blog de J.S. AI (2020). 1990 : Planification et apprentissage par renforcement avec des modèles de monde récurrents et une curiosité artificielle. Résumant des aspects de [1][2] et de nombreux articles ultérieurs, y compris [7][8].

[4] J.S. AI Blog (2021) : Curiosité artificielle et créativité depuis 1990. Résumant des aspects de [1][2] et de nombreux articles ultérieurs, y compris [7][8].

[5] J.S. TU Munich CogBotLab pour les robots d’apprentissage (2004-2009)

[6] NNAISENSE, fondée en 2014, pour l’IA dans le monde physique

[7] J.S. (2015). Sur l’apprentissage de la pensée : théorie de l’information algorithmique pour de nouvelles combinaisons de contrôleurs d’apprentissage par renforcement (RL) et de modèles de monde neuronal récurrent. arXiv 1210.0118. La section 5.3 décrit un ingénieur d’invite RL qui apprend à interroger son modèle pour un raisonnement abstrait, une planification et une prise de décision. Aujourd’hui, c’est ce qu’on appelle la « chaîne de pensée ».

[8] J.S. (2018). Un grand filet pour tout. arXiv 1802.08864. Voir aussi le brevet US11853886B2 et mon tweet DeepSeek : DeepSeek utilise des éléments de l’ingénieur d’incitation à l’apprentissage par renforcement de 2015 [7] et de son raffinement de 2018 [8] qui réduit la machine RL et le modèle du monde de [7] en un seul filet. Cela utilise ma procédure de distillation par réseau neuronal de 1991 : une chaîne distillée de système de pensée.

[9] J.S. Turing a survendu. Ce n’est pas la faute de Turing, cependant. AI Blog (2021, était #1 sur Hacker News)

[10] J.S. Intelligente Roboter werden vom Leben fasziniert sein. (Les robots intelligents seront fascinés par la vie.) F.A.Z., 2015

[11] J.S. à Falling Walls : le passé, le présent et l’avenir de l’intelligence artificielle. Scientific American, Observations, 2017.

[12] J.S. KI ist eine Riesenchance für Deutschland. (L’IA est une énorme chance pour l’Allemagne.) F.A.Z., 2018

[13] H. Jones. J.S. dit que le travail de sa vie ne mènera pas à la dystopie. Magazine Forbes, 2023.

[14] Entretien avec J.S. Jazzyear, Shanghai, 2024.

[15] Conférence de J.S. TED à TED AI Vienne (2024) : Pourquoi 2042 sera une grande année pour l’IA. Voir le clip vidéo ci-joint.

[16] J.S. Baut den KI-gesteuerten Allzweckroboter ! (Construisez le robot polyvalent contrôlé par l’IA !) F.A.Z., 2024

[17] J.S. 1995-2025 : Le déclin de l’Allemagne et du Japon contre les États-Unis et la Chine. Les robots polyvalents peuvent-ils alimenter un retour en force ? AI Blog, janvier 2025, basé sur [16].

[18] M. Alhakami, D. R. Ashley, J. Dunham, Y. Dai, F. Faccio, E. Feron, J. Schmidhuber. Vers un bébé robot extrêmement robuste avec une riche capacité d’interaction pour des algorithmes d’apprentissage automatique avancés. Prépublication arxiv 2404.08093, 2024.

66,83K

DeepSeek [1] utilise des éléments de l'ingénierie de prompt d'apprentissage par renforcement de 2015 [2] et son perfectionnement de 2018 [3] qui fusionne le modèle de machine RL et le modèle du monde de [2] en un seul réseau grâce à la procédure de distillation de réseau neuronal de 1991 [4] : un système de chaîne de pensée distillée.

RÉFÉRENCES (faciles à trouver sur le web) :

[1] #DeepSeekR1 (2025) : Incitation à la capacité de raisonnement dans les LLM via l'apprentissage par renforcement. arXiv 2501.12948

[2] J. Schmidhuber (JS, 2015). Sur l'apprentissage à penser : Théorie de l'information algorithmique pour des combinaisons nouvelles de contrôleurs d'apprentissage par renforcement et de modèles de monde neuronaux récurrents. arXiv 1210.0118. La section 5.3 décrit l'ingénierie de prompt d'apprentissage par renforcement (RL) qui apprend à interroger activement et itérativement son modèle pour le raisonnement abstrait, la planification et la prise de décision.

[3] JS (2018). Un grand réseau pour tout. arXiv 1802.08864. Voir aussi US11853886B2. Cet article fusionne l'apprenant par renforcement et le modèle du monde de [2] (par exemple, un modèle de base) en un seul réseau, en utilisant la procédure de distillation de réseau neuronal de 1991 [4]. Essentiellement ce qu'on appelle maintenant un système "Chaîne de Pensée" RL, où les améliorations successives sont continuellement distillées en un seul réseau. Voir aussi [5].

[4] JS (1991). Apprendre des séquences complexes et étendues en utilisant le principe de compression de l'histoire. Neural Computation, 4(2) :234-242, 1992. Basé sur TR FKI-148-91, TUM, 1991. Premier apprenant profond fonctionnel basé sur une hiérarchie de réseaux neuronaux récurrents profonds (avec différentes échelles de temps auto-organisées), surmontant le problème du gradient qui disparaît grâce à un pré-entraînement non supervisé (le P dans CHatGPT) et au codage prédictif. Aussi : compresser ou distiller un réseau enseignant (le chunker) en un réseau étudiant (l'automatisateur) qui n'oublie pas ses anciennes compétences - de telles approches sont maintenant largement utilisées. Voir aussi [6].

[5] JS (AI Blog, 2020). 30e anniversaire de la planification et de l'apprentissage par renforcement avec des modèles de monde récurrents et de la curiosité artificielle (1990, introduction de signaux de récompense de haute dimension et du principe GAN). Contient des résumés de [2][3] ci-dessus.

[6] JS (AI Blog, 2021). 30e anniversaire : Premier apprentissage très profond avec pré-entraînement non supervisé (1991) [4]. Le codage prédictif hiérarchique non supervisé trouve des représentations internes compactes de données séquentielles pour faciliter l'apprentissage en aval. La hiérarchie peut être distillée [4] en un seul réseau neuronal profond. 1993 : résoudre des problèmes de profondeur >1000.

786,95K

Le #NobelPrize en physique 2024 pour Hopfield & Hinton s’avère être un prix Nobel pour plagiat. Ils ont republié les méthodologies développées en #Ukraine et #Japan par Ivakhnenko et Amari dans les années 1960 et 1970, ainsi que d’autres techniques, sans citer les inventeurs originaux. Aucun des algorithmes importants pour l’IA moderne n’a été créé par Hopfield & Hinton.

Aujourd’hui, je publie un rapport technique détaillé à ce sujet :

Bien sûr, je l’ai fait vérifier par des pionniers des réseaux neuronaux et des experts en IA pour m’assurer qu’il était inattaquable.

Est-il maintenant acceptable pour moi de demander à de jeunes doctorants de lire de vieux articles, de les réécrire et de les soumettre à nouveau comme s’il s’agissait de leurs propres travaux ? Quelle que soit l’intention, ce prix dit que, oui, c’est parfaitement bien.

Certaines personnes ont perdu leur titre ou leur emploi à cause du plagiat, par exemple, l’ancien président de Harvard [PLAG7]. Mais après ce prix Nobel, comment les conseillers peuvent-ils continuer à dire à leurs étudiants qu’ils doivent éviter le plagiat à tout prix ?

Il est bien connu que le plagiat peut être soit « involontaire », soit « intentionnel ou imprudent » [PLAG1-6], et le plus innocent des deux peut très bien être partiellement le cas ici. Mais la science a une manière bien établie de traiter les « découvertes multiples » et le plagiat - qu’ils soient involontaires [PLAG1-6][CONN21] ou non [FAKE,FAKE2] - basés sur des faits tels que les horodatages des publications et les brevets. La déontologie de la science exige que les plagiaires involontaires corrigent leurs publications par des errata et créditent ensuite correctement les sources originales à l’avenir. Ce n’est pas le cas des lauréats ; au lieu de cela, les lauréats ont continué à collecter des citations pour les inventions d’autres chercheurs [NOB][DLP]. Ce comportement ne transforme-t-il pas le plagiat, même involontaire, en une forme intentionnelle ?

Je suis vraiment préoccupé par le message que cela envoie à tous ces jeunes étudiants.

RÉFÉRENCES

[NOB] J. Schmidhuber (2024). Un prix Nobel pour plagiat. Rapport technique IDSIA-24-24.

[NOB+] Tweet : le #NobelPrize en physique 2024 pour Hopfield & Hinton récompense le plagiat et l’attribution incorrecte en informatique. Il s’agit surtout du « réseau Hopfield » d’Amari et de la « machine Boltzmann ». (1/7e de la popularité de l’annonce originale de la Fondation Nobel)

[DLP] J. Schmidhuber (2023). Comment les lauréats de 3 Turing ont republié des méthodes et des idées clés dont ils n’ont pas crédité les créateurs. Rapport technique IDSIA-23-23, Swiss AI Lab IDSIA, 14 déc. 2023.

[DLP+] Tweet pour [DLP] :

[PLAG1] Guide d’Oxford sur les types de plagiat (2021). Citation : « Le plagiat peut être intentionnel ou imprudent, ou involontaire. »

[PLAG2] Collège communautaire d’État de Jackson (2022). Plagiat involontaire.

[PLAG3] R. L. Foster. Éviter le plagiat involontaire. Journal des spécialistes en soins infirmiers pédiatriques ; Hoboken Vol. 12, Iss. 1, 2007.

[PLAG4] N. Das. Intentionnel ou non, il n’est jamais bon de plagier : une note sur la façon dont les universités indiennes sont conseillées de gérer le plagiat. Perspect Clin Res 9:56-7, 2018.

[PLAG5] InfoSci-OnDemand (2023). Qu’est-ce que le plagiat involontaire ?

[PLAG6] (2022). Comment éviter le plagiat accidentel et involontaire (2023). Copie dans Internet Archive. Citation : « Qu’il soit accidentel ou intentionnel, le plagiat reste du plagiat. »

[PLAG7] Revue Cornell, 2024. Le président de Harvard démissionne dans un scandale de plagiat. 6 janvier 2024.

[FAUX] H. HOPF, A. KRIEF, G. MEHTA, S. A. MATLIN. La fausse science et la crise du savoir : l’ignorance peut être fatale. Royal Society Open Science, mai 2019. Citation : « Les scientifiques doivent être prêts à s’exprimer lorsqu’ils voient de fausses informations présentées dans les médias sociaux, la presse écrite traditionnelle ou la presse audiovisuelle » et « doivent dénoncer les fausses informations et la fausse science en circulation et contredire avec force les personnalités publiques qui les promeuvent ».

[FAUX2] L. Stenflo. Les plagiaires intelligents sont les plus dangereux. Nature, vol. 427, p. 777 (février 2004). Citation : « Ce qui est pire, à mon avis, ce sont les cas où les scientifiques réécrivent les découvertes précédentes avec des mots différents, cachant délibérément les sources de leurs idées, puis au cours des années suivantes, prétendent avec force qu’ils ont découvert de nouveaux phénomènes. »

721,85K

Meilleurs

Classement

Favoris

Tendance on-chain

Tendance sur X

Récents financements de premier plan

Les plus notables