Tendencias del momento

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Jürgen Schmidhuber

Inventó principios de metaaprendizaje (1987), GAN (1990), Transformers (1991), aprendizaje muy profundo (1991), etc. Nuestra IA se usa muchos miles de millones de veces al día.

IA física hace 10 años: robot bebé inventa sus propios experimentos para mejorar su modelo neural del mundo

Kompella, Stollenga, Luciw, Schmidhuber. Adquisición continua de habilidades impulsada por la curiosidad a partir de entradas de video de alta dimensión para robots humanoides. Inteligencia Artificial, 2015

10,55K

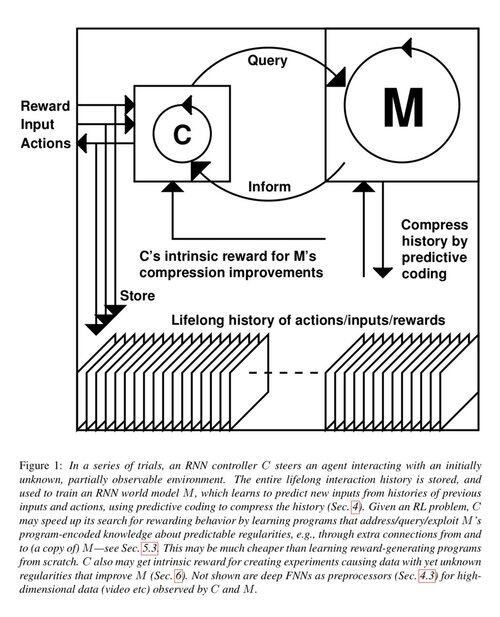

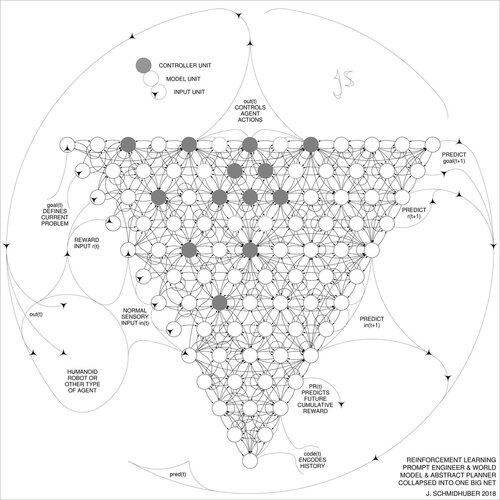

Hace 1 década: Ingeniero de Prompts de Aprendizaje por Refuerzo en la Sección 5.3 de «Learning to Think …» [2]. ¡Cadena de Pensamiento Adaptativa! Una red de RL aprende a consultar a otra red para el razonamiento abstracto y la toma de decisiones. Yendo más allá del Modelo Mundial de 1990 para la planificación milisegundo a milisegundo [1].

[2] J. Schmidhuber (JS, 2015). «On Learning to Think: Algorithmic Information Theory for Novel Combinations of RL Controllers and Recurrent Neural World Models.» ArXiv 1210.0118

[1] JS (1990). “Haciendo el mundo diferenciable: Sobre el uso de redes neuronales recurrentes totalmente auto-supervisadas para el aprendizaje por refuerzo dinámico y la planificación en entornos no estacionarios.” TR FKI-126-90, TUM. (Este informe también introdujo la curiosidad artificial y la motivación intrínseca a través de redes generativas adversariales.)

23,38K

Hace 10 años, en mayo de 2015, publicamos las primeras redes neuronales feedforward (FNN) muy profundas basadas en gradientes que funcionaban, con cientos de capas (las FNN anteriores tenían un máximo de unas pocas docenas de capas). Para superar el problema del gradiente que se desvanece, nuestras Redes de Autopista utilizaron las conexiones residuales que fueron introducidas por primera vez en 1991 por @HochreiterSepp para lograr un flujo de error constante en las redes neuronales recurrentes (RNN), controladas a través de puertas multiplicativas similares a las puertas de olvido (Gers et al., 1999) de nuestra RNN LSTM muy profunda. Las Redes de Autopista fueron posibles gracias al trabajo de mis antiguos estudiantes de doctorado @rupspace y Klaus Greff. Configurar las puertas de la Red de Autopista en 1.0 nos da efectivamente el ResNet publicado 7 meses después.

El aprendizaje profundo se trata de la profundidad de las redes neuronales. Las LSTM trajeron esencialmente una profundidad ilimitada a las RNN; las Redes de Autopista la llevaron a las FNN.

20,57K

1991: primera destilación de redes neuronales [1-3]. Yo lo llamé "colapsar," en ese entonces, no "destilar."

Referencias

[1] J. Schmidhuber (1991). Fragmentadores de secuencias neuronales. Informe técnico FKI-148-91, Universidad Técnica de Múnich. La Sección 3.2.2. y la Sección 4 tratan sobre "colapsar" o "destilar" o "comprimir" el conocimiento de una red neuronal en otra red neuronal.

[2] JS (1992). Aprendiendo secuencias complejas y extendidas utilizando el principio de compresión de la historia. Neural Computation, 4(2):234-242, 1992. Basado en [1].

[3] JS (AI Blog, 2021, actualizado 2025). 1991: Primer aprendizaje profundo muy avanzado con pre-entrenamiento no supervisado. Primera destilación de redes neuronales.

16,06K

Todo el mundo habla de la automejora recursiva y de las máquinas de Gödel ahora y de cómo esto conducirá a la AGI. ¡Qué cambio con respecto a hace 15 años! Tuvimos AGI'2010 en Lugano y presidimos AGI'2011 en Google. La columna vertebral de las conferencias de AGI fue la IA universal matemáticamente óptima: la Máquina Gödel de 2003 ( y el AIXI de @mhutter42 - véase su libro UAI de 2005 y su reciente actualización de 2024 ( Estoy orgulloso de que el trabajo de AIXI de Marcus Hutter haya sido financiado por mi beca suiza SNF de 2000 cuando era postdoc en IDSIA.

57,03K

¿AGI? Algún día, pero todavía no. La única IA que funciona bien en este momento es la que está detrás de la pantalla [12-17]. Pero pasar la prueba de Turing [9] detrás de una pantalla es fácil en comparación con la IA real para robots reales en el mundo real. Ningún robot impulsado por IA actual podría certificarse como plomero [13-17]. Por lo tanto, el test de Turing no es una buena medida de la inteligencia (y tampoco lo es el coeficiente intelectual). Y AGI sin dominio del mundo físico no es AGI. Es por eso que creé el TUM CogBotLab para aprender robots en 2004 [5], cofundé una empresa para la IA en el mundo físico en 2014 [6] e hice que los equipos de TUM, IDSIA y ahora KAUST trabajaran en robots bebés [4,10-11,18]. Estos robots blandos no solo imitan servilmente a los humanos y no funcionan simplemente descargando la web como los LLM/VLM. No. En su lugar, explotan los principios de la Curiosidad Artificial para mejorar sus Modelos de Mundo neuronal (dos términos que utilicé en 1990 [1-4]). Estos robots funcionan con muchos sensores, pero solo con actuadores débiles, de modo que no pueden dañarse fácilmente [18] cuando recopilan datos útiles ideando y ejecutando sus propios experimentos inventados por ellos mismos.

Sorprendentemente, desde la década de 1970, muchos se han burlado de mi antiguo objetivo de construir un AGI que se mejore a sí mismo y sea más inteligente que yo y luego retirarme. Recientemente, sin embargo, muchos finalmente han comenzado a tomar esto en serio, y ahora algunos de ellos de repente son DEMASIADO optimistas. Estas personas a menudo desconocen felizmente los desafíos restantes que tenemos que resolver para lograr una IA real. Mi charla TED de 2024 [15] resume algo de eso.

REFERENCIAS (fácil de encontrar en la web):

[1] J. Schmidhuber. Hacer que el mundo sea diferenciable: Sobre el uso de redes neuronales autosupervisadas (NN) totalmente recurrentes para el aprendizaje y la planificación de refuerzos dinámicos en entornos no estacionarios. TR FKI-126-90, TUM, febrero de 1990, revisado en noviembre de 1990. Este artículo también introdujo la curiosidad artificial y la motivación intrínseca a través de redes generativas adversarias donde un generador NN está luchando contra un predictor NN en un juego minimax.

[2] J. S. Una posibilidad para implementar la curiosidad y el aburrimiento en la construcción de modelos de controladores neuronales. En J. A. Meyer y S. W. Wilson, editores, Proc. de la Conferencia Internacional sobre Simulación de Comportamiento Adaptativo: De los Animales a los Animats, páginas 222-227. MIT Press/Bradford Books, 1991. Basado en [1].

[3] Blog de J.S. AI (2020). 1990: Planificación y Aprendizaje por Refuerzo con Modelos Mundiales Recurrentes y Curiosidad Artificial. Resumiendo aspectos de [1][2] y muchos artículos posteriores, incluyendo [7][8].

[4] J.S. AI Blog (2021): Curiosidad artificial y creatividad desde 1990. Resumiendo aspectos de [1][2] y muchos artículos posteriores, incluyendo [7][8].

[5] J.S. TU, Munich, CogBotLab para el aprendizaje de robots (2004-2009)

[6] NNAISENSE, fundada en 2014, para la IA en el mundo físico

[7] J.S. (2015). Sobre aprender a pensar: Teoría algorítmica de la información para combinaciones novedosas de controladores de aprendizaje por refuerzo (RL) y modelos de mundo neuronal recurrentes. arXiv 1210.0118. La sección 5.3 describe a un ingeniero de avisos de RL que aprende a consultar su modelo para el razonamiento abstracto y la planificación y toma de decisiones. Hoy en día, a esto se le llama "cadena de pensamiento".

[8] J.S. (2018). Una gran red para todo. arXiv 1802.08864. Véase también el US11853886B2 de patentes y mi tweet de DeepSeek: DeepSeek utiliza elementos del ingeniero de sugerencias de aprendizaje por refuerzo de 2015 [7] y su refinamiento de 2018 [8] que colapsa la máquina RL y el modelo mundial de [7] en una sola red. Esto utiliza mi procedimiento de destilación de redes neuronales de 1991: una cadena destilada de sistema de pensamiento.

[9] J.S. Turing sobrevendido. Sin embargo, no es culpa de Turing. AI Blog (2021, fue #1 en Hacker News)

[10] J.S. Intelligente Roboter werden vom Leben fasziniert sein. (Los robots inteligentes estarán fascinados por la vida). F.A.Z., 2015

[11] J.S. en Falling Walls: El pasado, presente y futuro de la inteligencia artificial. Scientific American, Observaciones, 2017.

[12] J.S. KI ist eine Riesenchance für Deutschland. (La IA es una gran oportunidad para Alemania). F.A.Z., 2018

[13] H. Jones. J.S. dice que el trabajo de su vida no lo llevará a la distopía. Revista Forbes, 2023.

[14] Entrevista con J.S. Jazzyear, Shanghái, 2024.

[15] Charla de J.S. TED en TED AI Viena (2024): Por qué 2042 será un gran año para la IA. Vea el videoclip adjunto.

[16] J.S. Baut den KI-gesteuerten Allzweckroboter! (¡Construya el robot multipropósito controlado por IA!) F.A.Z., 2024

[17] J.S. 1995-2025: El declive de Alemania y Japón frente a Estados Unidos y China. ¿Pueden los robots polivalentes impulsar un regreso? AI Blog, enero de 2025, basado en [16].

[18] M. Alhakami, D. R. Ashley, J. Dunham, Y. Dai, F. Faccio, E. Feron, J. Schmidhuber. Hacia un bebé robot extremadamente robusto con una rica capacidad de interacción para algoritmos avanzados de aprendizaje automático. Preimpresión arxiv 2404.08093, 2024.

66,83K

DeepSeek [1] utiliza elementos del ingeniero de prompts de aprendizaje por refuerzo de 2015 [2] y su refinamiento de 2018 [3], que colapsa el modelo de máquina de RL y el modelo del mundo de [2] en una sola red a través del procedimiento de destilación de redes neuronales de 1991 [4]: un sistema de cadena de pensamiento destilado.

REFERENCIAS (fácil de encontrar en la web):

[1] #DeepSeekR1 (2025): Incentivando la capacidad de razonamiento en LLMs a través del aprendizaje por refuerzo. arXiv 2501.12948

[2] J. Schmidhuber (JS, 2015). Sobre aprender a pensar: Teoría de la información algorítmica para combinaciones novedosas de controladores de aprendizaje por refuerzo y modelos de mundo neuronales recurrentes. arXiv 1210.0118. La Sección 5.3 describe el ingeniero de prompts de aprendizaje por refuerzo (RL) que aprende a consultar activamente e iterativamente su modelo para el razonamiento abstracto, la planificación y la toma de decisiones.

[3] JS (2018). Una gran red para todo. arXiv 1802.08864. Véase también US11853886B2. Este artículo colapsa el aprendiz por refuerzo y el modelo del mundo de [2] (por ejemplo, un modelo base) en una sola red, utilizando el procedimiento de destilación de redes neuronales de 1991 [4]. Esencialmente lo que ahora se llama un sistema de "Cadena de Pensamiento" de RL, donde las mejoras posteriores se destilan continuamente en una sola red. Véase también [5].

[4] JS (1991). Aprendiendo secuencias complejas y extendidas utilizando el principio de compresión de la historia. Neural Computation, 4(2):234-242, 1992. Basado en TR FKI-148-91, TUM, 1991. Primer aprendiz profundo funcional basado en una jerarquía de red neuronal recurrente profunda (con diferentes escalas de tiempo autoorganizadas), superando el problema del gradiente que desaparece a través del preentrenamiento no supervisado (la P en CHatGPT) y la codificación predictiva. También: comprimiendo o destilando una red docente (el fragmentador) en una red estudiante (el automatizador) que no olvida sus habilidades antiguas - tales enfoques son ahora ampliamente utilizados. Véase también [6].

[5] JS (AI Blog, 2020). 30 aniversario de la planificación y el aprendizaje por refuerzo con modelos de mundo recurrentes y curiosidad artificial (1990, introduciendo señales de recompensa de alta dimensión y el principio GAN). Contiene resúmenes de [2][3] arriba.

[6] JS (AI Blog, 2021). 30 aniversario: Primer aprendizaje muy profundo con preentrenamiento no supervisado (1991) [4]. La codificación predictiva jerárquica no supervisada encuentra representaciones internas compactas de datos secuenciales para facilitar el aprendizaje posterior. La jerarquía puede ser destilada [4] en una sola red neuronal profunda. 1993: resolviendo problemas de profundidad >1000.

786,95K

El #NobelPrize en Física 2024 para Hopfield & Hinton resulta ser un Premio Nobel por plagio. Volvieron a publicar las metodologías desarrolladas en #Ukraine y #Japan por Ivakhnenko y Amari en las décadas de 1960 y 1970, así como otras técnicas, sin citar a los inventores originales. Ninguno de los algoritmos importantes para la IA moderna fue creado por Hopfield & Hinton.

Hoy estoy publicando un informe técnico detallado sobre este [NOB]:

Por supuesto, lo hice revisar por pioneros de redes neuronales y expertos en IA para asegurarme de que era inexpugnable.

¿Es ahora aceptable para mí dirigir a jóvenes estudiantes de doctorado para que lean artículos antiguos y los reescriban y vuelvan a enviar como si fueran sus propios trabajos? Cualquiera que sea la intención, este premio dice que, sí, eso está perfectamente bien.

Algunas personas han perdido sus títulos o trabajos debido al plagio, por ejemplo, el ex presidente de Harvard [PLAG7]. Pero después de este Premio Nobel, ¿cómo pueden los asesores seguir diciéndoles a sus estudiantes que deben evitar el plagio a toda costa?

Es bien sabido que el plagio puede ser "no intencional" o "intencional o imprudente" [PLAG1-6], y el más inocente de los dos puede muy bien ser parcialmente el caso aquí. Pero la ciencia tiene una forma bien establecida de lidiar con el "descubrimiento múltiple" y el plagio, ya sea involuntario [PLAG1-6] [CONN21] o no [FAKE,FAKE2], basado en hechos como las marcas de tiempo de publicaciones y patentes. La deontología de la ciencia requiere que los plagiarios involuntarios corrijan sus publicaciones a través de erratas y luego acrediten adecuadamente las fuentes originales en el futuro. Los premiados no lo hicieron; en cambio, los galardonados seguían recogiendo citas de invenciones de otros investigadores [NOB][DLP]. ¿Este comportamiento no convierte incluso el plagio no intencional [PLAG1-6] en una forma intencional [FAKE2]?

Estoy realmente preocupado por el mensaje que esto envía a todos estos jóvenes estudiantes.

REFERENCIAS

[NOB] J. Schmidhuber (2024). Un Premio Nobel de Plagio. Informe Técnico IDSIA-24-24.

[NOB+] Tweet: el #NobelPrize en Física 2024 de Hopfield & Hinton premia el plagio y la atribución incorrecta en informática. Se trata principalmente de la "red Hopfield" de Amari y la "máquina Boltzmann". (1/7 tan popular como el anuncio original de la Fundación Nobel)

[DLP] J. Schmidhuber (2023). Cómo 3 ganadores del premio Turing volvieron a publicar métodos e ideas clave a cuyos creadores no lograron acreditar. Informe técnico IDSIA-23-23, Swiss AI Lab IDSIA, 14 de diciembre de 2023.

[DLP+] Tweet para [DLP]:

[PLAG1] Guía de Oxford sobre los tipos de plagio (2021). Cita: "El plagio puede ser intencional o imprudente, o no intencional".

[PLAG2] Colegio Comunitario Estatal de Jackson (2022). Plagio involuntario.

[PLAG3] R. L. Foster. Evitar el plagio involuntario. Revista de Especialistas en Enfermería Pediátrica; Hoboken Vol. 12, Iss. 1, 2007.

[PLAG4] N. Das. Intencional o no intencional, nunca está bien plagiar: Una nota sobre cómo se aconseja a las universidades indias manejar el plagio. Perspect Clin Res 9:56-7, 2018.

[PLAG5] InfoSci-OnDemand (2023). ¿Qué es el plagio involuntario?

[PLAG6] (2022). Cómo evitar el plagio accidental e involuntario (2023). Copia en Internet Archive. Cita: "Ya sea accidental o intencional, el plagio sigue siendo plagio".

[PLAG7] Revisión de Cornell, 2024. El presidente de Harvard renuncia por escándalo de plagio. 6 de enero de 2024.

[FALSO] H. Hopf, A. Krief, G. Mehta, S. A. Matlin. La falsa ciencia y la crisis del conocimiento: la ignorancia puede ser fatal. Royal Society Open Science, mayo de 2019. Cita: "Los científicos deben estar dispuestos a hablar cuando vean que se presenta información falsa en las redes sociales, la prensa impresa o televisiva tradicional" y "deben hablar en contra de la información falsa y la ciencia falsa en circulación y contradecir enérgicamente a las figuras públicas que la promueven".

[FAKE2] L. Stenflo. Los plagiarios inteligentes son los más peligrosos. Nature, vol. 427, p. 777 (febrero de 2004). Lo que es peor, en mi opinión, ..., son los casos en que los científicos reescriben los hallazgos anteriores con diferentes palabras, ocultando deliberadamente las fuentes de sus ideas, y luego, durante los años siguientes, afirman enérgicamente que han descubierto nuevos fenómenos.

721,86K

Parte superior

Clasificación

Favoritos

En tendencia on-chain

En tendencia en X

Principales fondos recientes

Más destacado