Актуальні теми

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Jürgen Schmidhuber

Винайдені принципи мета-навчання (1987), GANs (1990), Transformers (1991), very deep learning (1991) та ін. Наш штучний інтелект використовується багато мільярдів разів щодня.

Фізичний штучний інтелект 10 років тому: робот-малюк винаходить власні експерименти, щоб покращити свою модель нейронного світу

Компелла, Столленга, Люців, Шмідхубер. Постійне набуття навичок на основі цікавості за допомогою високорозмірних відеовходів для гуманоїдних роботів. Штучний інтелект, 2015

10,54K

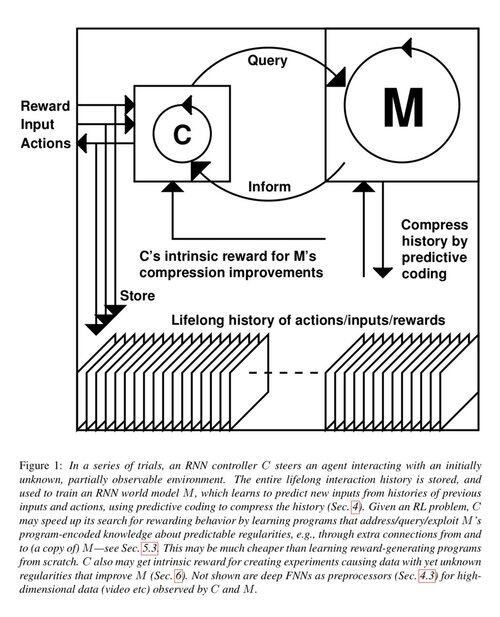

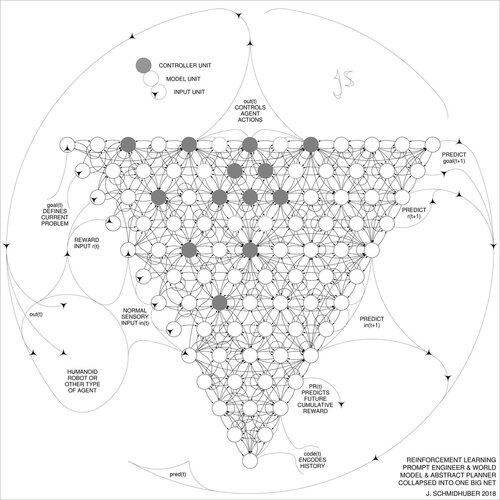

1 десятиліття тому: Інженер з підготовкою до навчання з підкріпленням в розділі 5.3 «Вчимося думати ...» [2]. Адаптивний ланцюжок думок! Мережа RL вчиться запитувати іншу мережу для абстрактних міркувань і прийняття рішень. Вихід за рамки Світової моделі 1990 року для планування мілісекунди на мілісекунду [1].

[2] Й. Шмідгубер (JS, 2015). «Про навчання мислити: алгоритмічна теорія інформації для нових комбінацій контролерів RL та рекурентних моделей нейронного світу.» ArXiv 1210.0118

[1] JS (1990). «Робимо світ диференційованим: про використання повністю рекурентних самоконтрольованих нейронних мереж для динамічного навчання та планування з підкріпленням у нестаціонарних середовищах.» ТР ФКІ-126-90, ТУМ. (Цей звіт також представив штучну цікавість і внутрішню мотивацію за допомогою генеративних змагальних мереж.)

23,37K

10 років тому, у травні 2015 року, ми опублікували перші робочі нейронні мережі прямого зв'язку (FNN) на основі дуже глибокого градієнта (FNN) із сотнями шарів (попередні FNN мали максимум кілька десятків шарів). Щоб подолати проблему зникаючого градієнта, наші мережі автомагістралей використовували залишкові з'єднання, вперше представлені в 1991 році @HochreiterSepp для досягнення постійного потоку помилок у рекурентних NN (RNN), закритих через мультиплікативні вентилі, подібні до задніх воріт (Gers et al., 1999) нашого дуже глибокого LSTM RNN. Будівництво автомагістралей NN стало можливим завдяки роботі моїх колишніх аспірантів @rupspace та Клауса Греффа. Встановлення воріт Highway NN на 1.0 фактично дає нам ResNet, опублікований через 7 місяців.

Глибоке навчання – це глибина NN. ЛСТМ принесли практично необмежену глибину в рекурентні НН; Highway Nets вивели його на зворотний зв'язок NN.

20,56K

1991 р. – перша дистиляція нейронних мереж [1-3]. Тоді я назвав це «руйнуванням», а не «дистиляцією».

Посилання

[1] J. Schmidhuber (1991). Фрагменти нейронних послідовностей. Технічний звіт FKI-148-91, Технічний ун-т Мюнхен. Розділ 3.2.2. & Розділ 4 присвячені «згортанню» або «дистиляції», або «стисненню» знань нейронної мережі в іншу нейронну мережу.

[2] JS (1992). Розучування складних, розширених послідовностей з використанням принципу стиснення історії. Нейронні обчислення, 4(2):234-242, 1992. На основі [1].

[3] JS (AI Blog, 2021, оновлено 2025). 1991: Перше дуже глибоке навчання з попередньою підготовкою без нагляду. Перша дистиляція нейронних мереж.

16,06K

Всі говорять про рекурсивне самовдосконалення та машини Геделя зараз і як це призведе до AGI. Яка ж зміна в порівнянні з тим, що було 15 років тому! Ми проводили AGI'2010 у Лугано та очолювали AGI'2011 у Google. Основою конференцій AGI був математично оптимальний Універсальний штучний інтелект: машина Геделя 2003 року (і AIXI @mhutter42 - див. його книгу UAI 2005 року та її нещодавнє оновлення 2024 року ( Я пишаюся тим, що робота Маркуса Хаттера AIXI була профінансована за рахунок мого швейцарського гранту SNF 2000 року, коли він був постдоком в IDSIA.

57,02K

АГІ? Одного разу, але ще ні. Єдиний штучний інтелект, який зараз добре працює, – це той, що за екраном [12-17]. Але пройти тест Тюрінга [9] за екраном легко в порівнянні з реальним штучним інтелектом для реальних роботів в реальному світі. Жоден сучасний робот, керований штучним інтелектом, не може бути сертифікований як сантехнік [13-17]. Отже, тест Тюрінга не є хорошим показником інтелекту (як і IQ). А AGI без володіння фізичним світом – це не AGI. Ось чому у 2004 році я створив TUM CogBotLab для навчання роботів [5], у 2014 році став співзасновником компанії зі штучного інтелекту у фізичному світі [6], і мав команди в TUM, IDSIA, а тепер і KAUST, які працюють над роботами-малюками [4,10-11,18]. Такі м'які роботи не просто рабськи імітують людей, і вони не працюють, просто завантажуючи веб, як LLM/VLM. Ні. Замість цього вони використовують принципи штучної цікавості для вдосконалення своїх нейронних моделей світу (два терміни, які я використовував ще в 1990 році [1-4]). Ці роботи працюють з великою кількістю датчиків, але лише зі слабкими виконавчими механізмами, так що вони не можуть легко завдати собі шкоди [18], коли збирають корисні дані, розробляючи та проводячи власні експерименти, вигадані самостійно.

Примітно, що з 1970-х років багато хто висміював мою стару мету побудувати самовдосконалюваний AGI, розумніший за мене, а потім піти на пенсію. Однак останнім часом багато хто нарешті почав ставитися до цього серйозно, і тепер деякі з них раптом стали ЗАНАДТО оптимістичними. Ці люди часто блаженно не знають про проблеми, що залишилися, які нам потрібно вирішити, щоб досягти справжнього штучного інтелекту. Мій виступ на TED 2024 року [15] підсумовує дещо з цього.

СПИСОК ЛІТЕРАТУРИ (легко знайти в Інтернеті):

[1] Й. Шмідгубер. Робимо світ диференційованим: Про використання повністю повторюваних самоконтрольованих нейронних мереж (NNs) для динамічного навчання та планування з підкріпленням у нестаціонарних середовищах. TR FKI-126-90, TUM, лютий 1990 р., переглянутий у листопаді 1990 р. Ця стаття також представила штучну цікавість і внутрішню мотивацію за допомогою генеративних змагальних мереж, де генератор NN бореться з предиктором NN у мінімаксній грі.

[2] Дж. Можливість реалізації цікавості та нудьги в нейронних контролерах, що будують моделі. У J. A. Meyer and S. W. Wilson, редактори, Proc. of the International Conference on Simulation of Adaptive Behavior: From Animals to Animats, pages 222-227. Видавництво Массачусетського технологічного інституту / Бредфорд Букс, 1991. На основі [1].

[3] Блог J.S. AI (2020). 1990: Планування та навчання з підкріпленням за допомогою повторюваних моделей світу та штучної цікавості. Узагальнення аспектів [1][2] та багатьох пізніших робіт, включаючи [7][8].

[4] Блог J.S. AI (2021): Штучна цікавість і творчість з 1990 року. Узагальнення аспектів [1][2] та багатьох пізніших робіт, включаючи [7][8].

[5] J.S. TU Мюнхенська лабораторія CogBotLab для навчання роботів (2004-2009)

[6] NNAISENSE, заснована у 2014 році, для штучного інтелекту у фізичному світі

[7] Ж.С. (2015). Про навчання мислити: алгоритмічна теорія інформації для нових комбінацій контролерів навчання з підкріпленням (RL) та рекурентних моделей нейронного світу. arXiv 1210.0118. У п. 5.3 описаний інженер RL, який вчиться запитувати свою модель для абстрактних міркувань і планування та прийняття рішень. Сьогодні це називається «ланцюгом думок».

[8] Ж.С. (2018). Одна велика сітка для всього. arXiv 1802.08864. Дивіться також патентний US11853886B2 та мій твіт DeepSeek: DeepSeek використовує елементи інженера швидкого навчання з підкріпленням 2015 року [7] та його доопрацювання 2018 року [8], що зводить машину RL та світову модель [7] в єдину мережу. Для цього використовується моя процедура дистиляції нейронної мережі 1991 року: дистильований ланцюг системи думок.

[9] Дж.С. Тюрінг Перепроданий. Однак це не провина Тюрінга. AI Blog (2021, був #1 на Hacker News)

[10] J.S. Intelligente Roboter werden vom Leben fasziniert sein. (Розумні роботи будуть зачаровані життям.) Ф.А.З., 2015

[11] J.S. у Falling Walls: минуле, сьогодення та майбутнє штучного інтелекту. Науковий американець, Спостереження, 2017.

[12] J.S. KI ist eine Riesenchance für Deutschland. (Штучний інтелект – це величезний шанс для Німеччини.) Ф.А.З., 2018

[13] Г. Джонс. Джей Сі каже, що справа його життя не призведе до антиутопії. Журнал Forbes, 2023.

[14] Інтерв'ю з J.S. Jazzyear, Шанхай, 2024 рік.

[15] Виступ J.S. TED на TED AI у Відні (2024): Чому 2042 рік стане важливим роком для штучного інтелекту. Дивіться прикріплений відеоролик.

[16] J.S. Baut den KI-gesteuerten Allzweckroboter! (Створіть універсального робота, керованого штучним інтелектом!) Ф.А.З., 2024

[17] J.S. 1995-2025: Занепад Німеччини та Японії проти США та Китаю. Чи можуть універсальні роботи сприяти поверненню? AI Blog, січень 2025 р., на основі [16].

[18] М. Альхакамі, Д. Р. Ешлі, Дж. На шляху до надзвичайно надійного робота-малюка з багатими можливостями взаємодії для передових алгоритмів машинного навчання. Препринт arxiv 2404.08093, 2024.

66,82K

DeepSeek [1] використовує елементи інженера підказки навчання з підкріпленням 2015 року [2] та його доопрацювання 2018 року [3], яке згортає машину RL та модель світу [2] в єдину мережу за допомогою процедури дистиляції нейронної мережі 1991 року [4]: дистильований ланцюг системи мислення.

СПИСОК ЛІТЕРАТУРИ (легко знайти в Інтернеті):

[1] #DeepSeekR1 (2025): Стимулювання здатності міркувати в LLM за допомогою навчання з підкріпленням. arXiv 2501.12948

[2] Й. Шмідгубер (JS, 2015). Про навчання мислити: алгоритмічна теорія інформації для нових комбінацій контролерів навчання з підкріпленням і рекурентних моделей нейронних світів. arXiv 1210.0118. У розділі 5.3 описується інженер з підкріпленням (RL), який вчиться активно та ітеративно запитувати свою модель для абстрактного міркування та планування та прийняття рішень.

[3] JS (2018). Одна велика сітка для всього. arXiv 1802.08864. Дивіться також US11853886B2. У цій роботі об'єднано учня з підкріпленням і модель світу [2] (наприклад, базову модель) в єдину мережу, використовуючи процедуру дистиляції нейронних мереж 1991 року [4]. По суті, це те, що зараз називається системою RL «Ланцюг думок», де подальші вдосконалення постійно переганяються в єдину мережу. Див також [5].

[4] JS (1991). Розучування складних, розширених послідовностей з використанням принципу стиснення історії. Нейронні обчислення, 4(2):234-242, 1992. На основі ТР ФКІ-148-91, ТУМ, 1991. Перший працюючий глибоке навчання на основі глибокої рекурентної ієрархії нейронних мереж (з різними часовими шкалами, що самоорганізуються), подолання проблеми зникаючого градієнта за допомогою попереднього навчання без нагляду (P у CHatGPT) та прогнозного кодування. Також: стиснення або перегонка вчительської сітки (чанкера) в учнівську сітку (автоматизатор), яка не забуває свої старі навички - такі підходи зараз широко використовуються. Див також [6].

[5] JS (AI Blog, 2020). 30-річчя планування та навчання з підкріпленням з використанням повторюваних моделей світу та штучної цікавості (1990 р., впровадження високорозмірних сигналів винагороди та принципу GAN). Містить резюме [2][3] вище.

[6] JS (AI Blog, 2021). 30-річний ювілей: перше дуже глибоке навчання з попереднім навчанням без нагляду (1991) [4]. Неконтрольоване ієрархічне прогнозне кодування знаходить компактні внутрішні представлення послідовних даних для полегшення подальшого навчання. Ієрархія може бути дистильована [4] в єдину глибоку нейронну мережу. 1993: розв'язування задач глибини >1000.

786,94K

#NobelPrize з фізики 2024 року для Hopfield & Hinton виявляється Нобелівською премією за плагіат. Вони перевидали методики, розроблені в #Ukraine і #Japan роках Івахненком і Амарі в 1960-х і 1970-х роках, а також інші методики, не посилаючись на оригінальних винахідників. Жоден з важливих алгоритмів для сучасного ШІ не був створений компанією Hopfield & Hinton.

Сьогодні я публікую детальний технічний звіт з цього приводу:

Звичайно, я перевірив його у піонерів нейронних мереж та експертів зі штучного інтелекту, щоб переконатися, що він неприступний.

Чи прийнятно зараз для мене наказувати молодим аспірантам читати старі статті, переписувати і подавати їх знову, ніби це їхні власні роботи? Якими б не були наміри, ця нагорода говорить про те, що так, це абсолютно нормально.

Деякі люди втратили свої звання або роботу через плагіат, наприклад, колишній президент Гарварду [PLAG7]. Але як після цієї Нобелівської премії консультанти тепер можуть продовжувати говорити своїм студентам, що вони повинні уникати плагіату за будь-яку ціну?

Добре відомо, що плагіат може бути як «ненавмисним», так і «навмисним або необережним» [PLAG1-6], і більш невинний з двох цілком може бути частково таким. Але наука має усталений спосіб боротьби з «множинними відкриттями» та плагіатом – незалежно від того, чи це ненавмисно [PLAG1-6][CONN21], чи ні [FAKE, FAKE2] – заснований на таких фактах, як часові позначки публікацій та патентів. Деонтологія науки вимагає, щоб ненавмисні плагіатори виправляли свої публікації через помилки, а потім у майбутньому належним чином посилалися на оригінальні джерела. Лауреати цього не зробили; натомість лауреати продовжували збирати цитати на винаходи інших дослідників [NOB][DLP]. Чи не перетворює така поведінка навіть ненавмисний плагіат [PLAG1-6] на навмисну форму [ФЕЙК2]?

Я дійсно стурбований тим, яке послання це посилає всім цим молодим студентам.

ПОСИЛАННЯ

[НОБ] Й. Шмідгубер (2024). Нобелівська премія за плагіат. Технічний звіт IDSIA-24-24.

[NOB+] Твітнути: #NobelPrize з фізики 2024 року для Hopfield & Hinton нагороджує плагіат і неправильну атрибуцію в інформатиці. В основному мова йде про «мережу Хопфілда» Амарі і «машину Больцмана». (1/7 менш популярна, ніж оригінальна заява Нобелівського фонду)

[DLP] Й. Шмідгубер (2023). Як 3 лауреати премії Тюрінга перепублікували ключові методи та ідеї, творців яких вони не змогли вказати. Технічний звіт IDSIA-23-23, Швейцарська лабораторія штучного інтелекту IDSIA, 14 грудня 2023 р.

[DLP+] Твіт для [DLP]:

[ПЛАГ1] Оксфордський посібник з видів плагіату (2021). Пряма мова: "Плагіат може бути навмисним або необережним, або ненавмисним".

[ПЛАГ2] Громадський коледж штату Джексон (2022). Ненавмисний плагіат.

[ПЛАГ3] Р. Л. Фостер. Уникнення ненавмисного плагіату. Журнал для спеціалістів з педіатричного медсестринства; Гобокен, т. 12, вип. 1, 2007.

[ПЛАГ4] Н. Дас. Навмисно чи ненавмисно, плагіат ніколи не є прийнятним: Примітка про те, як індійським університетам радять боротися з плагіатом. Perspect Clin Res 9:56-7, 2018.

[ПЛАГ5] InfoSci-OnDemand (2023). Що таке ненавмисний плагіат?

[ПЛАГ 6] (2022). Як уникнути випадкового та ненавмисного плагіату (2023). Скопіюйте в інтернет-архіві. Пряма мова: "Можливо, це випадково чи навмисно, плагіат все одно є плагіатом".

[ПЛАГ 7] Огляд Корнелла, 2024. Президент Гарварду подав у відставку через скандал із плагіатом. 6 січня 2024 року.

[ФЕЙК] Х. Хопф, А. Кріф, Г. Мехта, С. А. Матлін. Фальшива наука та криза знань: невігластво може бути фатальним. Відкрита наука Королівського товариства, травень 2019 року. Дослівно: "Вчені повинні бути готові висловлюватися, коли бачать, що неправдива інформація подається в соціальних мережах, традиційній друкованій або радіомовній пресі" і "повинні виступати проти неправдивої інформації та фальшивої науки в обігу та рішуче суперечити громадським діячам, які її пропагують".

[ФЕЙК2] Л. Стенфло. Найнебезпечнішими є розумні плагіатори. Природа, т. 427, с. 777 (лютий 2004). Пряма мова: "Гірше, на мій погляд, ..., це випадки, коли вчені переписують попередні знахідки іншими словами, навмисно приховуючи джерела своїх ідей, а потім протягом наступних років переконливо стверджують, що відкрили нові явища".

721,85K

Найкращі

Рейтинг

Вибране

Актуальне ончейн

Популярні в X

Нещодавнє найкраще фінансування

Найбільш варте уваги