Tópicos populares

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Jürgen Schmidhuber

Inventou princípios de meta-aprendizagem (1987), GANs (1990), Transformers (1991), aprendizagem muito profunda (1991), etc. Nossa IA é usada muitos bilhões de vezes todos os dias.

IA Física há 10 anos: robô bebé inventa os seus próprios experimentos para melhorar o seu modelo neural do mundo

Kompella, Stollenga, Luciw, Schmidhuber. Aquisição contínua de habilidades impulsionada pela curiosidade a partir de entradas de vídeo de alta dimensão para robôs humanoides. Inteligência Artificial, 2015

10,55K

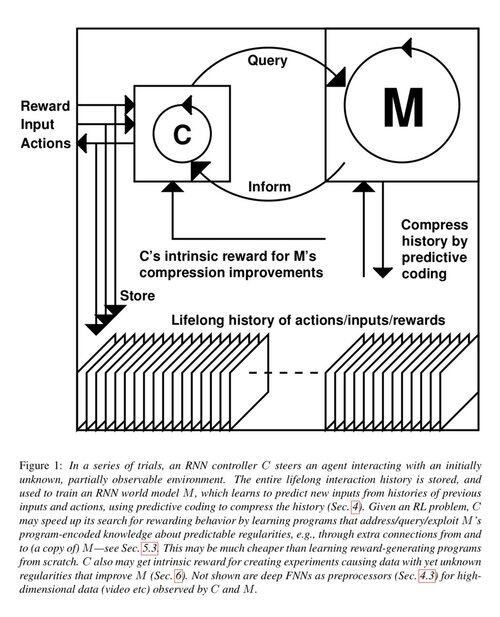

1 década atrás: Engenheiro de Prompt de Aprendizagem por Reforço na Sec. 5.3 de «Learning to Think …» [2]. Cadeia Adaptativa de Pensamento! Uma rede de RL aprende a consultar outra rede para raciocínio abstrato e tomada de decisão. Indo além do Modelo Mundial de 1990 para planejamento milissegundo a milissegundo [1].

[2] J. Schmidhuber (JS, 2015). «On Learning to Think: Algorithmic Information Theory for Novel Combinations of RL Controllers and Recurrent Neural World Models.» ArXiv 1210.0118

[1] JS (1990). “Tornando o mundo diferenciável: Sobre o uso de redes neurais totalmente recorrentes auto-supervisionadas para aprendizagem por reforço dinâmica e planejamento em ambientes não estacionários.” TR FKI-126-90, TUM. (Este relatório também introduziu curiosidade artificial e motivação intrínseca através de redes adversariais generativas.)

23,38K

Há 10 anos, em maio de 2015, publicamos as primeiras redes neurais feedforward (FNNs) muito profundas baseadas em gradientes, com centenas de camadas (as FNNs anteriores tinham no máximo algumas dezenas de camadas). Para superar o problema do gradiente que desaparece, nossas Highway Networks usaram as conexões residuais introduzidas pela primeira vez em 1991 por @HochreiterSepp para alcançar um fluxo de erro constante em redes neurais recorrentes (RNNs), controladas por portas multiplicativas semelhantes às portas de esquecimento (Gers et al., 1999) da nossa LSTM RNN muito profunda. As Highway NNs foram possibilitadas pelo trabalho dos meus ex-alunos de doutorado @rupspace e Klaus Greff. Definir as portas da Highway NN para 1.0 nos dá efetivamente a ResNet publicada 7 meses depois.

O aprendizado profundo é tudo sobre a profundidade das redes neurais. As LSTMs trouxeram essencialmente profundidade ilimitada para as RNNs; as Highway Nets trouxeram isso para as FNNs.

20,57K

1991: primeira destilação de rede neural [1-3]. Eu a chamava de "colapso," na época, não "destilação."

Referências

[1] J. Schmidhuber (1991). Chunkers de sequência neural. Relatório Técnico FKI-148-91, Universidade Técnica de Munique. Sec. 3.2.2. & Sec. 4 falam sobre "colapso" ou "destilação" ou "compressão" do conhecimento de uma rede neural em outra rede neural.

[2] JS (1992). Aprendendo sequências complexas e extensas usando o princípio da compressão de história. Computação Neural, 4(2):234-242, 1992. Baseado em [1].

[3] JS (Blog de IA, 2021, atualizado em 2025). 1991: Primeiro aprendizado profundo muito avançado com pré-treinamento não supervisionado. Primeira destilação de rede neural.

16,06K

Todo mundo fala sobre autoaperfeiçoamento recursivo & Gödel Machines agora & como isso levará ao AGI. Que mudança de 15 anos atrás! Tivemos AGI'2010 em Lugano e presidimos AGI'2011 no Google. A espinha dorsal das conferências AGI foi matematicamente ótima Universal AI: a Máquina de Gödel de 2003 (e AIXI de @mhutter42 - veja seu livro UAI de 2005 e sua recente atualização de 2024 ( Estou orgulhoso de que o trabalho AIXI de Marcus Hutter foi financiado pela minha bolsa SNF suíça de 2000 quando ele era um pós-doutorado na IDSIA.

57,02K

AGI? Um dia, mas ainda não. A única IA que funciona bem agora é a que está atrás da tela [12-17]. Mas passar no Teste de Turing [9] atrás de uma tela é fácil em comparação com a IA real para robôs reais no mundo real. Nenhum robô atual baseado em IA poderia ser certificado como canalizador [13-17]. Assim, o Teste de Turing não é uma boa medida de inteligência (e o QI também não). E AGI sem domínio do mundo físico não é AGI. É por isso que criei o TUM CogBotLab para robôs de aprendizagem em 2004 [5], cofundei uma empresa de IA no mundo físico em 2014 [6] e tive equipas na TUM, IDSIA e agora KAUST a trabalhar para robôs bebés [4,10-11,18]. Esses robôs suaves não apenas imitam servilmente os seres humanos e eles não funcionam apenas baixando a web como LLMs / VLMs. Não. Em vez disso, eles exploram os princípios da Curiosidade Artificial para melhorar seus Modelos de Mundo neurais (dois termos que usei em 1990 [1-4]). Estes robôs trabalham com muitos sensores, mas apenas com atuadores fracos, de tal forma que não podem facilmente prejudicar-se a si próprios [18] quando recolhem dados úteis através da conceção e execução das suas próprias experiências autoinventadas.

Notavelmente, desde a década de 1970, muitos tiraram sarro do meu antigo objetivo de construir uma AGI auto-melhorada mais inteligente do que eu e depois me aposentar. Recentemente, no entanto, muitos finalmente começaram a levar isso a sério, e agora alguns deles estão repentinamente otimistas demais. Essas pessoas muitas vezes desconhecem os desafios remanescentes que temos que resolver para alcançar a IA real. A minha palestra TED de 2024 [15] resume um pouco disso.

REFERÊNCIAS (fácil de encontrar na web):

[1] J. Schmidhuber. Tornando o mundo diferenciável: Sobre o uso de redes neurais autosupervisionadas (NNs) totalmente recorrentes para aprendizagem e planejamento de reforço dinâmico em ambientes não estacionários. TR FKI-126-90, TUM, fevereiro de 1990, revisto em novembro de 1990. Este artigo também introduziu curiosidade artificial e motivação intrínseca através de redes adversárias generativas onde um NN gerador está lutando contra um NN preditor em um jogo minimax.

[2] J. S. Uma possibilidade para implementar curiosidade e tédio em controladores neurais de construção de modelos. In J. A. Meyer e S. W. Wilson, editores, Proc. da Conferência Internacional sobre Simulação de Comportamento Adaptativo: Dos Animais aos Animats, páginas 222-227. MIT Press/Bradford Books, 1991. Com base em [1].

[3] Blog J.S. AI (2020). 1990: Planeamento e Aprendizagem por Reforço com Modelos de Mundo Recorrentes e Curiosidade Artificial. Resumindo aspetos de [1][2] e muitos artigos posteriores, incluindo [7][8].

[4] J.S. AI Blog (2021): Curiosidade artificial e criatividade desde 1990. Resumindo aspetos de [1][2] e muitos artigos posteriores, incluindo [7][8].

[5] J.S. TU Munich CogBotLab para robôs de aprendizagem (2004-2009)

[6] NNAISENSE, fundada em 2014, para IA no mundo físico.

[7] J.S. (2015). Sobre Aprender a Pensar: Teoria da Informação Algorítmica para Novas Combinações de Controladores de Aprendizagem por Reforço (RL) e Modelos de Mundo Neural Recorrente. arXiv 1210.0118. A Seção 5.3 descreve um engenheiro de prompt RL que aprende a consultar seu modelo para raciocínio abstrato, planejamento e tomada de decisão. Hoje isso é chamado de "cadeia de pensamento".

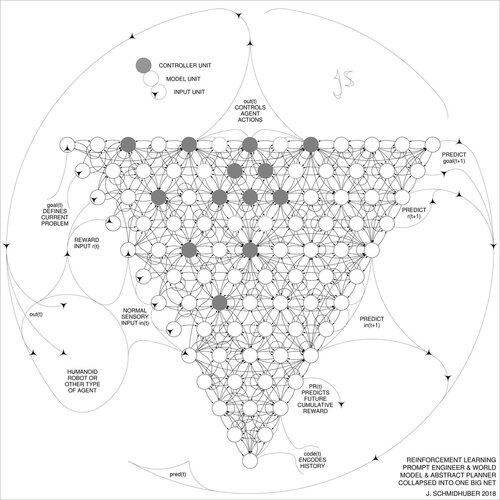

[8] J.S. (2018). Uma grande rede para tudo. arXiv 1802.08864. Veja também o US11853886B2 de patentes e meu tweet DeepSeek: O DeepSeek usa elementos do engenheiro de aprendizado de reforço de 2015 [7] e seu refinamento de 2018 [8], que colapsa a máquina RL e o modelo mundial de [7] em uma única rede. Isso usa meu procedimento de destilação de rede neural de 1991: um sistema de cadeia de pensamento destilado.

[9] J.S. Turing sobrevendido. Mas a culpa não é de Turing. AI Blog (2021, foi #1 no Hacker News)

[10] J.S. Intelligente Roboter werden vom Leben fasziniert sein. (Os robôs inteligentes ficarão fascinados pela vida.) F.A.Z., 2015

[11] J.S. em Falling Walls: O Passado, o Presente e o Futuro da Inteligência Artificial. Scientific American, Observações, 2017.

[12] J.S. KI ist eine Riesenchance für Deutschland. (A IA é uma grande oportunidade para a Alemanha.) F.A.Z., 2018

[13] H. Jones. J.S. diz que o trabalho de sua vida não levará à distopia. Revista Forbes, 2023.

[14] Entrevista com J.S. Jazzyear, Xangai, 2024.

[15] J.S. TED talk no TED AI Viena (2024): Por que 2042 será um grande ano para a IA. Veja o vídeo em anexo.

[16] J.S. Baut den KI-gesteuerten Allzweckroboter! (Construa o robô polivalente controlado por IA!) F.A.Z., 2024

[17] J.S. 1995-2025: O declínio da Alemanha & Japão vs EUA vs. China. Os robôs polivalentes podem alimentar um regresso? AI Blog, janeiro de 2025, com base em [16].

[18] M. Alhakami, D. R. Ashley, J. Dunham, Y. Dai, F. Faccio, E. Feron, J. Schmidhuber. Rumo a um robô bebé extremamente robusto com uma rica capacidade de interação para algoritmos avançados de aprendizagem automática. Pré-impressão arxiv 2404.08093, 2024.

66,83K

DeepSeek [1] utiliza elementos do engenheiro de prompt de aprendizagem por reforço de 2015 [2] e sua refinamento de 2018 [3], que colapsa a máquina de RL e o modelo do mundo de [2] em uma única rede através do procedimento de destilação de rede neural de 1991 [4]: um sistema de cadeia de pensamento destilada.

REFERÊNCIAS (fáceis de encontrar na web):

[1] #DeepSeekR1 (2025): Incentivando a Capacidade de Raciocínio em LLMs via Aprendizagem por Reforço. arXiv 2501.12948

[2] J. Schmidhuber (JS, 2015). Sobre Aprender a Pensar: Teoria da Informação Algorítmica para Novas Combinações de Controladores de Aprendizagem por Reforço e Modelos de Mundo Neurais Recorrentes. arXiv 1210.0118. A Sec. 5.3 descreve o engenheiro de prompt de aprendizagem por reforço (RL) que aprende a consultar ativamente e iterativamente seu modelo para raciocínio abstrato, planejamento e tomada de decisão.

[3] JS (2018). Uma Grande Rede Para Tudo. arXiv 1802.08864. Veja também US11853886B2. Este artigo colapsa o aprendiz por reforço e o modelo do mundo de [2] (por exemplo, um modelo de fundação) em uma única rede, usando o procedimento de destilação de rede neural de 1991 [4]. Essencialmente, o que agora é chamado de sistema de "Cadeia de Pensamento" de RL, onde melhorias subsequentes são continuamente destiladas em uma única rede. Veja também [5].

[4] JS (1991). Aprendendo sequências complexas e extensas usando o princípio da compressão de história. Neural Computation, 4(2):234-242, 1992. Baseado em TR FKI-148-91, TUM, 1991. Primeiro aprendiz profundo funcional baseado em uma hierarquia de rede neural recorrente profunda (com diferentes escalas de tempo auto-organizadoras), superando o problema do gradiente que desaparece através de pré-treinamento não supervisionado (o P em CHatGPT) e codificação preditiva. Também: comprimindo ou destilando uma rede de professor (o chunker) em uma rede de aluno (o automatizador) que não esquece suas habilidades antigas - tais abordagens são agora amplamente utilizadas. Veja também [6].

[5] JS (AI Blog, 2020). 30 anos de planejamento e aprendizagem por reforço com modelos de mundo recorrentes e curiosidade artificial (1990, introduzindo sinais de recompensa de alta dimensão e o princípio GAN). Contém resumos de [2][3] acima.

[6] JS (AI Blog, 2021). 30 anos: Primeiro aprendizado muito profundo com pré-treinamento não supervisionado (1991) [4]. A codificação preditiva hierárquica não supervisionada encontra representações internas compactas de dados sequenciais para facilitar o aprendizado posterior. A hierarquia pode ser destilada [4] em uma única rede neural profunda. 1993: resolvendo problemas de profundidade >1000.

786,95K

O #NobelPrize em Física 2024 para Hopfield e Hinton acaba por ser um Prémio Nobel por plágio. Eles republicaram metodologias desenvolvidas em #Ukraine e #Japan por Ivakhnenko e Amari nas décadas de 1960 e 1970, bem como outras técnicas, sem citar os inventores originais. Nenhum dos algoritmos importantes para a IA moderna foi criado por Hopfield & Hinton.

Hoje estou lançando um relatório técnico detalhado sobre isso [NOB]:

Claro, eu tive que verificá-lo por pioneiros de redes neurais e especialistas em IA para ter certeza de que era inatacável.

Será agora aceitável que eu oriente jovens estudantes de doutoramento a lerem artigos antigos e a reescrevê-los e a reenviá-los como se fossem os seus próprios trabalhos? Seja qual for a intenção, este prémio diz que, sim, tudo bem.

Algumas pessoas perderam seus títulos ou empregos devido a plágio, por exemplo, o ex-presidente de Harvard [PLAG7]. Mas depois deste Prémio Nobel, como podem agora os conselheiros continuar a dizer aos seus alunos que devem evitar o plágio a todo o custo?

É sabido que o plágio pode ser "não intencional" ou "intencional ou imprudente" [PLAG1-6], e o mais inocente dos dois pode muito bem ser parcialmente o caso aqui. Mas a ciência tem uma maneira bem estabelecida de lidar com "descobertas múltiplas" e plágio - seja não intencional [PLAG1-6][CONN21] ou não [FAKE,FAKE2] - com base em fatos como carimbos de tempo de publicações e patentes. A deontologia da ciência exige que plagiadores não intencionais corrijam suas publicações através de erratas e depois creditem as fontes originais adequadamente no futuro. Os premiados não; em vez disso, os premiados continuaram coletando citações para invenções de outros pesquisadores [NOB][DLP]. Este comportamento não transforma mesmo o plágio não intencional [PLAG1-6] numa forma intencional [FAKE2]?

Estou realmente preocupado com a mensagem que isto envia a todos estes jovens estudantes por aí.

REFERÊNCIAS

[NOB] J. Schmidhuber (2024). Prémio Nobel do Plágio. Relatório Técnico IDSIA-24-24.

[NOB+] Tweet: o #NobelPrize em Física 2024 para Hopfield & Hinton recompensa plágio e atribuição incorreta em ciência da computação. É principalmente sobre a "rede Hopfield" de Amari e a "Máquina Boltzmann". (1/7 tão popular quanto o anúncio original da Fundação Nobel)

[DLP] J. Schmidhuber (2023). Como 3 premiados de Turing republicaram métodos-chave e ideias cujos criadores eles não conseguiram creditar. Relatório Técnico IDSIA-23-23, Swiss AI Lab IDSIA, 14 de dezembro de 2023.

[DLP+] Tweet para [DLP]:

[PLAG1] Guia de Oxford sobre tipos de plágio (2021). Citação: "O plágio pode ser intencional ou imprudente, ou não intencional."

[PLAG2] Colégio Comunitário Estadual Jackson (2022). Plágio não intencional.

[PLAG3] R. L. Foster. Evitar o plágio não intencional. Revista de Especialistas em Enfermagem Pediátrica; Hoboken Vol. 12, Iss. 1, 2007.

[PLAG4] N. Das. Intencional ou não, nunca é correto plagiar: uma nota sobre como as universidades indianas são aconselhadas a lidar com o plágio. Perspect Clin Res 9:56-7, 2018.

[PLAG5] InfoSci-OnDemand (2023). O que é plágio não intencional?

[PLAG6] (2022). Como evitar o plágio acidental e não intencional (2023). Copie no Internet Archive. Citação: "Pode ser acidental ou intencional, plágio ainda é plágio."

[PLAG7] Revista Cornell, 2024. Presidente de Harvard demite-se em escândalo de plágio. 6 de janeiro de 2024.

[FAKE] H. Hopf, A. Krief, G. Mehta, S. A. Matlin. A falsa ciência e a crise do conhecimento: a ignorância pode ser fatal. Royal Society Open Science, maio de 2019. Citação: "Os cientistas devem estar dispostos a falar quando virem informações falsas sendo apresentadas nas mídias sociais, na imprensa tradicional impressa ou radiodifundida" e "devem se manifestar contra informações falsas e ciência falsa em circulação e contradizer à força figuras públicas que as promovem".

[FAKE2] L. Stenflo. Os plagiadores inteligentes são os mais perigosos. Nature, vol. 427, p. 777 (fev 2004). Citação: "O que é pior, na minha opinião, ..., são casos em que os cientistas reescrevem descobertas anteriores em palavras diferentes, escondendo propositadamente as fontes das suas ideias, e depois, durante os anos subsequentes, afirmam vigorosamente que descobriram novos fenómenos."

721,85K

Top

Classificação

Favoritos

Tendências on-chain

Popular no X

Principais financiamentos atuais

Mais notável