Актуальные темы

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Jürgen Schmidhuber

Изобрел принципы метаобучения (1987), GAN (1990), трансформеров (1991), very deep learning (1991) и т.д. Наш искусственный интеллект используется миллиарды раз каждый день.

Физический ИИ 10 лет назад: робот-ребенок изобретает свои собственные эксперименты для улучшения своей нейронной модели мира

Компелла, Столленга, Люсив, Шмидхубер. Непрерывное приобретение навыков, основанное на любопытстве, из высокоразмерных видеовходов для гуманоидных роботов. Искусственный интеллект, 2015

10,55K

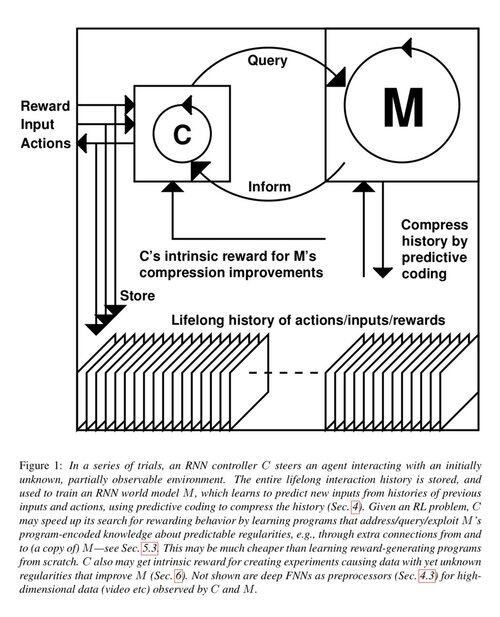

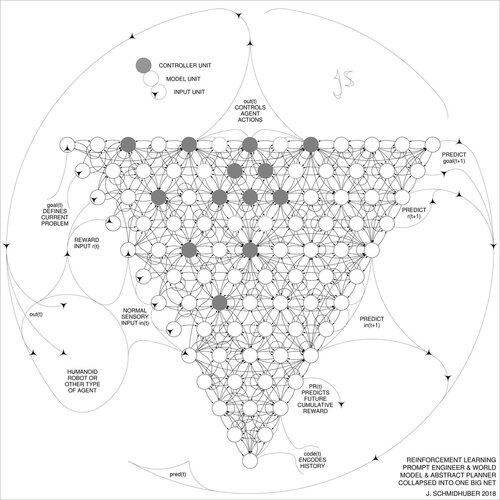

1 десятилетие назад: Инженер по запросам в области обучения с подкреплением в Разделе 5.3 «Обучение мыслить …» [2]. Адаптивная цепочка размышлений! Сеть RL учится запрашивать другую сеть для абстрактного рассуждения и принятия решений. Выходя за пределы Мировой модели 1990 года для планирования с миллисекундной точностью [1].

[2] Дж. Шмидхубер (JS, 2015). «Об обучении мыслить: Алгоритмическая теория информации для новых комбинаций контроллеров RL и рекуррентных нейронных мировых моделей.» ArXiv 1210.0118

[1] JS (1990). “Сделать мир дифференцируемым: о применении полностью рекуррентных самонаблюдающих нейронных сетей для динамического обучения с подкреплением и планирования в нестационарных средах.» TR FKI-126-90, TUM. (Этот отчет также представил искусственное любопытство и внутреннюю мотивацию через генеративные состязательные сети.)

23,39K

10 лет назад, в мае 2015 года, мы опубликовали первые работающие очень глубокие нейронные сети прямого распространения (FNN) на основе градиентов с сотнями слоев (предыдущие FNN имели максимум несколько десятков слоев). Чтобы преодолеть проблему исчезающего градиента, наши Highway Networks использовали остаточные соединения, впервые введенные в 1991 году @HochreiterSepp, чтобы достичь постоянного потока ошибок в рекуррентных нейронных сетях (RNN), управляемых мультипликативными воротами, аналогичными воротам забывания (Gers et al., 1999) нашей очень глубокой LSTM RNN. Highway NNs стали возможны благодаря работе моих бывших аспирантов @rupspace и Клауса Греффа. Установка ворот Highway NN на 1.0 фактически дает нам ResNet, опубликованную через 7 месяцев.

Глубокое обучение — это все о глубине нейронных сетей. LSTM принесли по сути неограниченную глубину в рекуррентные нейронные сети; Highway Nets принесли это в нейронные сети прямого распространения.

20,57K

1991: первая дистилляция нейронной сети [1-3]. Я тогда называл это "коллапсом", а не "дистилляцией".

Ссылки

[1] J. Schmidhuber (1991). Нейронные последовательные чанки. Технический отчет FKI-148-91, Технический университет Мюнхена. Разделы 3.2.2 и 4 посвящены "коллапсу" или "дистилляции" или "сжатию" знаний нейронной сети в другую нейронную сеть.

[2] JS (1992). Обучение сложным, расширенным последовательностям с использованием принципа сжатия истории. Нейронные вычисления, 4(2):234-242, 1992. Основано на [1].

[3] JS (AI Blog, 2021, обновлено в 2025). 1991: Первое очень глубокое обучение с ненадзорной предварительной подготовкой. Первая дистилляция нейронной сети.

16,06K

Все говорят о рекурсивном самоулучшении и машинах Гёделя сейчас и о том, как это приведет к AGI. Какой же это контраст с 15 годами назад! У нас была AGI'2010 в Лугано, и мы председательствовали на AGI'2011 в Google. Основой конференций AGI была математически оптимальная Универсальная ИИ: машина Гёделя 2003 года (и AIXI @mhutter42 - см. его книгу UAI 2005 года и ее недавнее обновление 2024 года (я горжусь тем, что работа Маркуса Хуттера над AIXI была профинансирована моим грантом Швейцарского НФН 2000 года, когда он был постдоком в IDSIA.

57,03K

AGI? Однажды, но не сейчас. Единственный ИИ, который хорошо работает в данный момент, это тот, что за экраном [12-17]. Но пройти тест Тьюринга [9] за экраном проще, чем создать Реальный ИИ для реальных роботов в реальном мире. Ни один современный робот на базе ИИ не может быть сертифицирован как сантехник [13-17]. Поэтому тест Тьюринга не является хорошей мерой интеллекта (и IQ тоже). И AGI без освоения физического мира — это не AGI. Вот почему я создал TUM CogBotLab для обучения роботов в 2004 году [5], соучредил компанию для ИИ в физическом мире в 2014 году [6] и имел команды в TUM, IDSIA и теперь KAUST, работающие над роботами-младенцами [4,10-11,18]. Такие мягкие роботы не просто рабски имитируют людей и не работают, просто загружая интернет, как LLMs/VLMs. Нет. Вместо этого они используют принципы Искусственного Любопытства для улучшения своих нейронных Мировых Моделей (два термина, которые я использовал еще в 1990 году [1-4]). Эти роботы работают с множеством сенсоров, но только с слабыми актуаторами, так что они не могут легко навредить себе [18], когда собирают полезные данные, придумывая и проводя собственные эксперименты.

Замечательно, что с 1970-х годов многие высмеивали мою старую цель создать самоулучшающийся AGI, умнее меня самого, а затем уйти на пенсию. Однако недавно многие наконец начали воспринимать это всерьез, и теперь некоторые из них внезапно стали СЛИШКОМ оптимистичными. Эти люди часто блаженно не осознают оставшихся задач, которые нам нужно решить, чтобы достичь Реального ИИ. Мое выступление на TED в 2024 году [15] резюмирует некоторые из них.

ССЫЛКИ (легко найти в интернете):

[1] J. Schmidhuber. Making the world differentiable: On using fully recurrent self-supervised neural networks (NNs) for dynamic reinforcement learning and planning in non-stationary environments. TR FKI-126-90, TUM, Feb 1990, revised Nov 1990. This paper also introduced artificial curiosity and intrinsic motivation through generative adversarial networks where a generator NN is fighting a predictor NN in a minimax game.

[2] J. S. A possibility for implementing curiosity and boredom in model-building neural controllers. In J. A. Meyer and S. W. Wilson, editors, Proc. of the International Conference on Simulation of Adaptive Behavior: From Animals to Animats, pages 222-227. MIT Press/Bradford Books, 1991. Based on [1].

[3] J.S. AI Blog (2020). 1990: Planning & Reinforcement Learning with Recurrent World Models and Artificial Curiosity. Summarising aspects of [1][2] and lots of later papers including [7][8].

[4] J.S. AI Blog (2021): Artificial Curiosity & Creativity Since 1990. Summarising aspects of [1][2] and lots of later papers including [7][8].

[5] J.S. TU Munich CogBotLab for learning robots (2004-2009)

[6] NNAISENSE, founded in 2014, for AI in the physical world

[7] J.S. (2015). On Learning to Think: Algorithmic Information Theory for Novel Combinations of Reinforcement Learning (RL) Controllers and Recurrent Neural World Models. arXiv 1210.0118. Sec. 5.3 describes an RL prompt engineer which learns to query its model for abstract reasoning and planning and decision making. Today this is called "chain of thought."

[8] J.S. (2018). One Big Net For Everything. arXiv 1802.08864. See also patent US11853886B2 and my DeepSeek tweet: DeepSeek uses elements of the 2015 reinforcement learning prompt engineer [7] and its 2018 refinement [8] which collapses the RL machine and world model of [7] into a single net. This uses my neural net distillation procedure of 1991: a distilled chain of thought system.

[9] J.S. Turing Oversold. It's not Turing's fault, though. AI Blog (2021, was #1 on Hacker News)

[10] J.S. Intelligente Roboter werden vom Leben fasziniert sein. (Intelligent robots will be fascinated by life.) F.A.Z., 2015

[11] J.S. at Falling Walls: The Past, Present and Future of Artificial Intelligence. Scientific American, Observations, 2017.

[12] J.S. KI ist eine Riesenchance für Deutschland. (AI is a huge chance for Germany.) F.A.Z., 2018

[13] H. Jones. J.S. Says His Life's Work Won't Lead To Dystopia. Forbes Magazine, 2023.

[14] Interview with J.S. Jazzyear, Shanghai, 2024.

[15] J.S. TED talk at TED AI Vienna (2024): Why 2042 will be a big year for AI. See the attached video clip.

[16] J.S. Baut den KI-gesteuerten Allzweckroboter! (Build the AI-controlled all-purpose robot!) F.A.Z., 2024

[17] J.S. 1995-2025: The Decline of Germany & Japan vs US & China. Can All-Purpose Robots Fuel a Comeback? AI Blog, Jan 2025, based on [16].

[18] M. Alhakami, D. R. Ashley, J. Dunham, Y. Dai, F. Faccio, E. Feron, J. Schmidhuber. Towards an Extremely Robust Baby Robot With Rich Interaction Ability for Advanced Machine Learning Algorithms. Preprint arxiv 2404.08093, 2024.

66,83K

DeepSeek [1] использует элементы инженера по обучению с подкреплением 2015 года [2] и его усовершенствование 2018 года [3], которое объединяет RL-машину и мировую модель из [2] в единую сеть через процедуру дистилляции нейронной сети 1991 года [4]: дистиллированная система цепочки размышлений.

СПИСОК ЛИТЕРАТУРЫ (легко найти в интернете):

[1] #DeepSeekR1 (2025): Стимулирование способности к рассуждению в LLM через обучение с подкреплением. arXiv 2501.12948

[2] J. Шмидхубер (JS, 2015). О том, как научиться мыслить: Алгоритмическая теория информации для новых комбинаций контроллеров обучения с подкреплением и рекуррентных нейронных мировых моделей. arXiv 1210.0118. Раздел 5.3 описывает инженера по обучению с подкреплением (RL), который учится активно и итеративно запрашивать свою модель для абстрактного рассуждения, планирования и принятия решений.

[3] JS (2018). Одна большая сеть для всего. arXiv 1802.08864. См. также US11853886B2. Эта работа объединяет обучающего с подкреплением и мировую модель из [2] (например, базовую модель) в единую сеть, используя процедуру дистилляции нейронной сети 1991 года [4]. По сути, это то, что сейчас называется системой "Цепочка размышлений" RL, где последующие улучшения постоянно дистиллируются в единую сеть. См. также [5].

[4] JS (1991). Обучение сложным, расширенным последовательностям с использованием принципа сжатия истории. Нейронные вычисления, 4(2):234-242, 1992. Основано на TR FKI-148-91, TUM, 1991. Первый работающий глубокий обучающий алгоритм на основе иерархии глубоких рекуррентных нейронных сетей (с различными самоорганизующимися временными шкалами), преодолевающий проблему исчезающего градиента через несупервизируемое предварительное обучение (P в CHatGPT) и предсказательное кодирование. Также: сжатие или дистилляция сети учителя (разделитель) в сеть ученика (автоматизатор), которая не забывает свои старые навыки - такие подходы сейчас широко используются. См. также [6].

[5] JS (AI Blog, 2020). 30-летие планирования и обучения с подкреплением с рекуррентными мировыми моделями и искусственным любопытством (1990, введение высокоразмерных сигналов вознаграждения и принципа GAN). Содержит резюме [2][3] выше.

[6] JS (AI Blog, 2021). 30-летие: Первое очень глубокое обучение с несупервизируемым предварительным обучением (1991) [4]. Несупервизируемое иерархическое предсказательное кодирование находит компактные внутренние представления последовательных данных для облегчения последующего обучения. Иерархию можно дистиллировать [4] в единую глубокую нейронную сеть. 1993: решение проблем глубины >1000.

786,95K

#НобелевскаяПремия по физике 2024 года для Хопфилда и Хинтона оказывается Нобелевской премией за плагиат. Они перепубликовали методологии, разработанные в #Украине и #Японии Ивахненко и Амари в 1960-х и 1970-х годах, а также другие техники, не упомянув оригинальных изобретателей. Ни один из важных алгоритмов для современного ИИ не был создан Хопфилдом и Хинтоном.

Сегодня я выпускаю подробный технический отчет об этом [NOB]:

Конечно, я проверил его у пионеров нейронных сетей и экспертов по ИИ, чтобы убедиться, что он неоспорим.

Теперь мне допустимо направлять молодых аспирантов читать старые статьи и переписывать и пересдавать их как свои собственные работы? Каковы бы ни были намерения, эта награда говорит, что да, это совершенно нормально.

Некоторые люди потеряли свои титулы или работу из-за плагиата, например, бывший президент Гарварда [PLAG7]. Но после этой Нобелевской премии, как теперь советники могут продолжать говорить своим студентам, что они должны избегать плагиата любой ценой?

Известно, что плагиат может быть либо "непреднамеренным", либо "преднамеренным или безрассудным" [PLAG1-6], и более невинный из двух может вполне быть частично случаем здесь. Но наука имеет хорошо установленный способ справляться с "множественным открытием" и плагиатом - будь то непреднамеренный [PLAG1-6][CONN21] или нет [FAKE,FAKE2] - на основе фактов, таких как временные метки публикаций и патентов. Деонтология науки требует, чтобы непреднамеренные плагиаторы исправляли свои публикации через эррату и затем правильно указывали оригинальные источники в будущем. Лауреаты этого не сделали; вместо этого лауреаты продолжали собирать цитаты за изобретения других исследователей [NOB][DLP]. Не превращает ли это поведение даже непреднамеренный плагиат [PLAG1-6] в преднамеренную форму [FAKE2]?

Я действительно обеспокоен тем, какое сообщение это отправляет всем этим молодым студентам.

Ссылки

[NOB] J. Schmidhuber (2024). Нобелевская премия за плагиат. Технический отчет IDSIA-24-24.

[NOB+] Твит: #НобелевскаяПремия по физике 2024 года для Хопфилда и Хинтона вознаграждает плагиат и неправильное приписывание в компьютерных науках. Это в основном о "сети Хопфилда" Амари и "машине Больцмана". (1/7 популярности оригинального объявления Нобелевского фонда)

[DLP] J. Schmidhuber (2023). Как 3 лауреата премии Тьюринга перепубликовали ключевые методы и идеи, чьих создателей они не упомянули. Технический отчет IDSIA-23-23, Швейцарская лаборатория ИИ IDSIA, 14 декабря 2023 года.

[DLP+] Твит для [DLP]:

[PLAG1] Руководство Оксфорда по типам плагиата (2021). Цитата: "Плагиат может быть преднамеренным или безрассудным, или непреднамеренным."

[PLAG2] Государственный колледж Джексона (2022). Непреднамеренный плагиат.

[PLAG3] R. L. Foster. Избегание непреднамеренного плагиата. Журнал для специалистов по педиатрическому уходу; Хобокен, том 12, выпуск 1, 2007.

[PLAG4] N. Das. Преднамеренный или непреднамеренный, это никогда не нормально плагиатировать: заметка о том, как индийские университеты советуют справляться с плагиатом. Perspect Clin Res 9:56-7, 2018.

[PLAG5] InfoSci-OnDemand (2023). Что такое непреднамеренный плагиат?

[PLAG6] (2022). Как избежать случайного и непреднамеренного плагиата (2023). Копия в Интернет-архиве. Цитата: "Будь то случайный или преднамеренный, плагиат все равно плагиат."

[PLAG7] Cornell Review, 2024. Президент Гарварда уходит в отставку из-за скандала с плагиатом. 6 января 2024 года.

[FAKE] H. Hopf, A. Krief, G. Mehta, S. A. Matlin. Лженаука и кризис знаний: невежество может быть смертельным. Royal Society Open Science, май 2019 года. Цитата: "Ученые должны быть готовы выступать, когда видят, что ложная информация представляется в социальных сетях, традиционной печати или вещательных СМИ" и "должны выступать против ложной информации и лженауки в обращении и решительно противостоять публичным фигурам, которые ее продвигают."

[FAKE2] L. Stenflo. Интеллектуальные плагиаторы самые опасные. Nature, том 427, стр. 777 (февраль 2004 года). Цитата: "Что хуже, на мой взгляд, ..., это случаи, когда ученые переписывают предыдущие выводы другими словами, намеренно скрывая источники своих идей, а затем в последующие годы настойчиво утверждают, что они открыли новые явления."

721,86K

Топ

Рейтинг

Избранное

В тренде ончейн

В тренде в Х

Самые инвестируемые

Наиболее известные