Trendande ämnen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Jürgen Schmidhuber

Uppfann principer för metainlärning (1987), GAN (1990), Transformers (1991), mycket djupinlärning (1991), etc. Vår AI används många miljarder gånger varje dag.

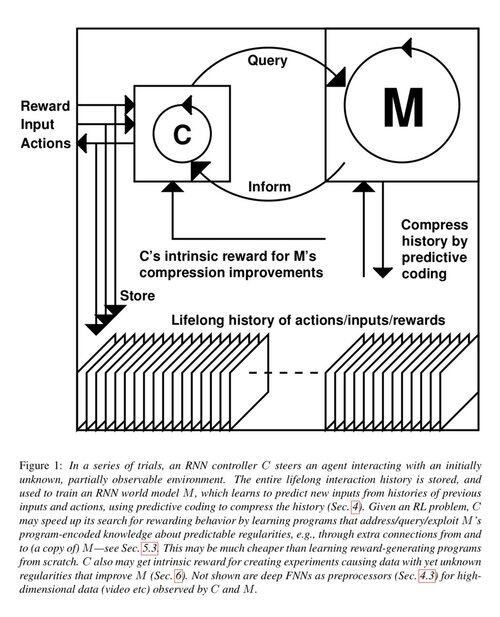

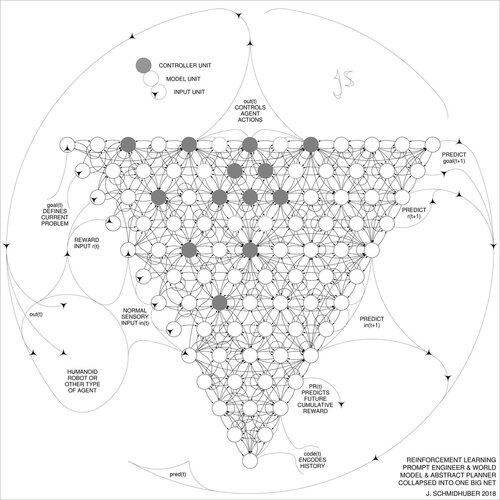

1 decennium sedan: Reinforcement Learning Prompt Engineer i avsnitt 5.3 av «Att lära sig att tänka ...» [2]. Adaptiv tankekedja! Ett RL-nät lär sig att fråga ett annat nät för abstrakt resonemang och beslutsfattande. Att gå bortom 1990 års världsmodell för millisekund-för-millisekund-planering [1].

[2] J. Schmidhuber (JS, 2015). «Om att lära sig att tänka: Algoritmisk informationsteori för nya kombinationer av RL-kontroller och återkommande neurala världsmodeller.» ArXiv 1210.0118

[1] JS (1990). "Att göra världen differentierbar: Om att använda helt återkommande självövervakade neurala nätverk för dynamisk förstärkningsinlärning och planering i icke-stationära miljöer.» TR FKI-126-90, TUM. (Denna rapport introducerade också artificiell nyfikenhet och inneboende motivation genom generativa kontradiktoriska nätverk.)

23,42K

För 10 år sedan, i maj 2015, publicerade vi de första fungerande mycket djupa gradientbaserade feedforward-neurala nätverken (FNN) med hundratals lager (tidigare FNN:er hade maximalt några dussin lager). För att övervinna problemet med försvinnande gradient använde våra motorvägsnät de kvarvarande anslutningarna som först introducerades 1991 av @HochreiterSepp för att uppnå konstant felflöde i återkommande NN (RNN), styrda genom multiplikativa grindar som liknar glömsportarna (Gers et al., 1999) i vår mycket djupa LSTM RNN. Highway NNs möjliggjordes genom arbetet av mina tidigare doktorander @rupspace och Klaus Greff. Genom att ställa in Highway NN-grindarna på 1.0 får vi effektivt det ResNet som publicerades 7 månader senare.

Djupinlärning handlar om NN-djup. LSTM gav i princip obegränsat djup till återkommande NN; Highway Nets förde den till feedforward NNs.

20,59K

1991: Första destillationen av neurala nätverk [1-3]. Jag kallade det att "kollapsa" på den tiden, inte "destillering".

Referenser

[1] J. Schmidhuber (1991). Delar av neurala sekvenser. Tech Report FKI-148-91, Tech Univ. München. Avsnitt 3.2.2. & § 4 handlar om att "kollapsa" eller "destillera" eller "komprimera" kunskapen om ett neuralt nätverk till ett annat neuralt nätverk.

[2] JS (1992). Inlärning av komplexa, utökade sekvenser med hjälp av principen om historiekomprimering. Neural Beräkning, 4(2):234-242, 1992. Baserat på [1].

[3] JS (AI-bloggen, 2021, uppdaterad 2025). 1991: Första mycket djupa inlärningen med oövervakad förträning. Första destillationen av neurala nätverk.

16,08K

Alla pratar om rekursiv självförbättring och Gödel Machines nu och hur detta kommer att leda till AGI. Vilken förändring jämfört med för 15 år sedan! Vi hade AGI'2010 i Lugano och var ordförande för AGI'2011 på Google. Ryggraden i AGI-konferenserna var matematiskt optimal Universal AI: the 2003 Gödel Machine (och @mhutter42:s AIXI - se hans UAI-bok från 2005 och dess senaste uppdatering 2024 ( Jag är stolt över att Marcus Hutters AIXI-arbete finansierades av mitt schweiziska SNF-anslag från 2000 när han var postdoktor vid IDSIA.

57,05K

AGI? En dag, men inte än. Den enda AI som fungerar bra just nu är den bakom skärmen [12-17]. Men att klara Turingtestet [9] bakom en skärm är lätt jämfört med riktig AI för riktiga robotar i den verkliga världen. Ingen nuvarande AI-driven robot kan certifieras som rörmokare [13-17]. Därför är Turingtestet inte ett bra mått på intelligens (och det är inte IQ heller). Och AGI utan att behärska den fysiska världen är ingen AGI. Det var därför jag skapade TUM CogBotLab för lärande robotar 2004 [5], var med och grundade ett företag för AI i den fysiska världen 2014 [6] och hade team på TUM, IDSIA och nu KAUST som arbetade mot babyrobotar [4,10-11,18]. Sådana mjuka robotar imiterar inte bara slaviskt människor och de fungerar inte genom att bara ladda ner webben som LLM:er/VLM:er. Nej. Istället utnyttjar de principerna för artificiell nyfikenhet för att förbättra sina neurala världsmodeller (två termer som jag använde redan 1990 [1-4]). Dessa robotar arbetar med många sensorer, men bara svaga aktuatorer, så att de inte lätt kan skada sig själva [18] när de samlar in användbara data genom att utforma och köra sina egna självuppfunna experiment.

Anmärkningsvärt nog har många sedan 1970-talet gjort narr av mitt gamla mål att bygga en självförbättrande AGI som är smartare än mig själv och sedan gå i pension. På senare tid har dock många äntligen börjat ta detta på allvar, och nu är några av dem plötsligt FÖR optimistiska. Dessa människor är ofta lyckligt omedvetna om de återstående utmaningar vi måste lösa för att uppnå Real AI. Mitt TED-talk från 2024 [15] sammanfattar en del av detta.

REFERENSER (lätt att hitta på webben):

[1] J. Schmidhuber. Att göra världen differentierbar: Om att använda helt återkommande självövervakade neurala nätverk (NN) för dynamisk förstärkningsinlärning och planering i icke-stationära miljöer. TR FKI-126-90, TUM, februari 1990, reviderad nov 1990. Denna uppsats introducerade också artificiell nyfikenhet och inneboende motivation genom generativa kontradiktornätverk där en generator-NN slåss mot en prediktor NN i ett minimax-spel.

[2] J. S. En möjlighet att implementera nyfikenhet och tristess i modellbyggande neurala kontroller. I J. A. Meyer och S. W. Wilson, redaktörer, Proc. of the International Conference on Simulation of Adaptive Behavior: From Animals to Animats, sidorna 222-227. MIT Press/Bradford Books, 1991. Baserat på [1].

[3] J.S. AI-bloggen (2020). 1990: Planering och Reinforcement Learning med återkommande världsmodeller och artificiell nyfikenhet. Sammanfattar aspekter av [1][2] och många senare artiklar, inklusive [7][8].

[4] J.S. AI Blog (2021): Artificiell nyfikenhet och kreativitet sedan 1990. Sammanfattar aspekter av [1][2] och många senare artiklar, inklusive [7][8].

[5] J.S. TU München CogBotLab för lärande robotar (2004-2009)

[6] NNAISENSE, grundat 2014, för AI i den fysiska världen

[7] J.S. (2015). Om att lära sig att tänka: Algoritmisk informationsteori för nya kombinationer av Reinforcement Learning (RL) Controllers och återkommande neurala världsmodeller. arXiv 1210.0118. Avsnitt 5.3 beskriver en RL-promptingenjör som lär sig att fråga sin modell för abstrakt resonemang och planering och beslutsfattande. I dag kallas detta för "tankekedja".

[8] J.S. (2018). Ett stort nät för allt. arXiv 1802.08864. Se även patent-US11853886B2 och min DeepSeek-tweet: DeepSeek använder delar av 2015 reinforcement learning prompt engineer [7] och dess förfining från 2018 [8] som kollapsar RL-maskinen och världsmodellen av [7] till ett enda nät. Detta använder min neurala nätdestillationsprocedur från 1991: ett destillerat tankekedja.

[9] J.S. Turing översåld. Det är dock inte Turings fel. AI Blog (2021, var #1 på Hacker News)

[10] J.S. Intelligente Roboter werden vom Leben fasziniert sein. (Intelligenta robotar kommer att fascineras av livet.) F.A.Z., 2015

[11] J.S. på Falling Walls: The Past, Present and Future of Artificial Intelligence. Scientific American, Observationer, 2017.

[12] J.S. KI ist eine Riesenchance für Deutschland. (AI är en enorm chans för Tyskland.) F.A.Z., 2018

[13] H. Jones. J.S. säger att hans livsverk inte kommer att leda till dystopi. Forbes Magazine, 2023.

[14] Intervju med J.S. Jazzyear, Shanghai, 2024.

[15] J.S. TED-talk på TED AI Wien (2024): Varför 2042 kommer att bli ett stort år för AI. Se bifogat videoklipp.

[16] J.S. Baut den KI-gesteuerten Allzweckroboter! (Bygg den AI-styrda roboten för alla ändamål!) F.A.Z., 2024

[17] J.S. 1995-2025: Nedgången för Tyskland och Japan jämfört med USA och Kina. Kan robotar för alla ändamål ge bränsle till en comeback? AI-blogg, januari 2025, baserat på [16].

[18] M. Alhakami, D. R. Ashley, J. Dunham, Y. Dai, F. Faccio, E. Feron, J. Schmidhuber. Mot en extremt robust babyrobot med rik interaktionsförmåga för avancerade maskininlärningsalgoritmer. Preprint arxiv 2404.08093, 2024.

66,86K

DeepSeek [1] använder delar av 2015 reinforcement learning prompt engineer [2] och dess förfining från 2018 [3] som kollapsar RL-maskinen och världsmodellen av [2] till ett enda nät genom neurala nätdestillationsproceduren från 1991 [4]: ett destillerat tankekedjesystem.

REFERENSER (lätt att hitta på webben):

[1] #DeepSeekR1 (2025): Stimulera resonemangsförmåga hos LLM:er via förstärkningsinlärning. arXiv 2501.12948

[2] J. Schmidhuber (JS, 2015). Om att lära sig att tänka: Algoritmisk informationsteori för nya kombinationer av Reinforcement Learning Controllers och återkommande neurala världsmodeller. arXiv 1210.0118. Avsnitt 5.3 beskriver promptingenjören för förstärkningsinlärning (RL) som lär sig att aktivt och iterativt fråga sin modell för abstrakt resonemang och planering och beslutsfattande.

[3] JS (2018). Ett stort nät för allt. arXiv 1802.08864. Se även US11853886B2. Den här artikeln kollapsar förstärkningsinlärningen och världsmodellen av [2] (t.ex. en grundmodell) till ett enda nätverk, med hjälp av neurala nätverksdestillationsproceduren från 1991 [4]. I huvudsak vad som nu kallas ett RL "Chain of Thought" -system, där efterföljande förbättringar kontinuerligt destilleras till ett enda nät. Se även [5].

[4] JS (1991). Inlärning av komplexa, utökade sekvenser med hjälp av principen om historiekomprimering. Neural Beräkning, 4(2):234-242, 1992. Baserat på TR FKI-148-91, TUM, 1991. Först arbetar man med djupinlärning baserat på en djup återkommande neural näthierarki (med olika självorganiserande tidsskalor), och övervinner problemet med försvinnande gradient genom oövervakad förträning (P:et i CHatGPT) och prediktiv kodning. Dessutom: komprimera eller destillera ett lärarnät (chunkern) till ett elevnät (automatiseraren) som inte glömmer sina gamla färdigheter - sådana metoder används nu i stor utsträckning. Se även [6].

[5] JS (AI-bloggen, 2020). 30-årsjubileum för planering och förstärkningsinlärning med återkommande världsmodeller och artificiell nyfikenhet (1990, introducerade högdimensionella belöningssignaler och GAN-principen). Innehåller sammanfattningar av [2][3] ovan.

[6] JS (AI-bloggen, 2021). 30-årsjubileum: Första mycket djupa inlärningen med oövervakad förutbildning (1991) [4]. Oövervakad hierarkisk prediktiv kodning hittar kompakta interna representationer av sekventiella data för att underlätta inlärning nedströms. Hierarkin kan destilleras [4] till ett enda djupt neuralt nätverk. 1993: Lösa djupproblem >1000.

786,97K

#NobelPrize i fysik 2024 för Hopfield & Hinton visar sig bli ett Nobelpris för plagiering. De återpublicerade metoder som utvecklats #Ukraine och #Japan av Ivakhnenko och Amari på 1960- och 1970-talen, liksom andra tekniker, utan att citera de ursprungliga uppfinnarna. Ingen av de viktiga algoritmerna för modern AI skapades av Hopfield & Hinton.

Idag släpper jag en detaljerad teknisk rapport om detta [NOB]:

Naturligtvis lät jag det kontrolleras av pionjärer inom neurala nätverk och AI-experter för att se till att det var oantastligt.

Är det nu acceptabelt för mig att uppmana unga doktorander att läsa gamla uppsatser och skriva om och lämna in dem på nytt som om de vore deras egna arbeten? Oavsett avsikten säger den här utmärkelsen att, ja, det är helt i sin ordning.

Vissa personer har förlorat sina titlar eller jobb på grund av plagiat, t.ex. Harvards tidigare rektor [PLAG7]. Men hur kan rådgivarna nu efter detta Nobelpris fortsätta att tala om för sina studenter att de till varje pris ska undvika plagiering?

Det är välkänt att plagiering kan vara antingen "oavsiktligt" eller "avsiktligt eller vårdslöst" [PLAG1-6], och det mer oskyldiga av de två kan mycket väl delvis vara fallet här. Men vetenskapen har ett väletablerat sätt att hantera "multipla upptäckter" och plagiering - oavsett om det är oavsiktligt [PLAG1-6][CONN21] eller inte [FAKE,FAKE2] - baserat på fakta som tidsstämplar för publikationer och patent. Vetenskapens deontologi kräver att oavsiktliga plagiatörer korrigerar sina publikationer genom errata och sedan krediterar originalkällorna korrekt i framtiden. Det gjorde inte pristagarna; I stället fortsatte pristagarna att samla in citat för uppfinningar av andra forskare [NOB][DLP]. Innebär inte detta beteende att även oavsiktlig plagiering [PLAG1-6] blir en avsiktlig form [FAKE2]?

Jag är verkligen bekymrad över det budskap som detta sänder till alla dessa unga studenter där ute.

REFERENSER

[NOB] J. Schmidhuber (2024). Nobelpris för plagiering. Teknisk rapport IDSIA-24-24.

[NOB+] Tweet: #NobelPrize in Physics 2024 för Hopfield & Hinton belönar plagiat och felaktig attribuering inom datavetenskap. Det handlar mest om Amaris "Hopfield-nätverk" och "Boltzmann Machine". (1/7 så populär som den ursprungliga tillkännagivandet från Nobelstiftelsen)

[DLP] J. Schmidhuber (2023). Hur 3 Turingpristagare återpublicerade viktiga metoder och idéer vars skapare de misslyckades med att kreditera. Teknisk rapport IDSIA-23-23, Swiss AI Lab IDSIA, 14 dec 2023.

[DLP+] Tweet för [DLP]:

[PLAG1] Oxfords guide till typer av plagiat (2021). Citat: "Plagiering kan vara avsiktligt eller vårdslöst, eller oavsiktligt."

[PLAG2] Jackson State Community College (2022). Oavsiktlig plagiering.

[PLAG3] R. L. Foster. Undvika oavsiktlig plagiering. Tidskrift för specialister i pediatrisk omvårdnad; Hoboken Vol. 12, Iss. 1, 2007.

[PLAG4] N. Das. Avsiktligt eller oavsiktligt, det är aldrig okej att plagiera: En anteckning om hur indiska universitet rekommenderas att hantera plagiering. Perspektiv Clin Res 9:56-7, 2018.

[PLAG5] InfoSci-OnDemand (2023). Vad är oavsiktlig plagiering?

[PLAG6] (2022). Hur man undviker oavsiktlig och oavsiktlig plagiering (2023). Kopiera i Internet Archive. Citat: "Kan det vara oavsiktligt eller avsiktligt, plagiat är fortfarande plagiat."

[PLAG7] Cornell recension, 2024. Harvards rektor avgår i plagiatskandal. den 6 januari 2024.

[FALSK] H. Hopf, A. Krief, G. Mehta, S. A. Matlin. Falsk vetenskap och kunskapskrisen: okunnighet kan vara dödligt. Royal Society Open Science, maj 2019. Citat: "Forskare måste vara villiga att säga ifrån när de ser falsk information presenteras i sociala medier, traditionell press eller eterpress" och "måste tala ut mot falsk information och falsk vetenskap i omlopp och kraftfullt motsäga offentliga personer som främjar den."

[FAKE2] L. Stenflo. Intelligenta plagiatörer är de farligaste. Nature, vol. 427, s. 777 (feb 2004). Citat: "Vad som är värre, enligt min mening, ..., är fall där vetenskapsmän skriver om tidigare resultat med andra ord, avsiktligt döljer källorna till sina idéer, och sedan under de följande åren kraftfullt hävdar att de har upptäckt nya fenomen."

721,87K

Topp

Rankning

Favoriter

Trendande på kedjan

Trendande på X

Senaste toppfinansieringarna

Mest anmärkningsvärda