Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Jürgen Schmidhuber

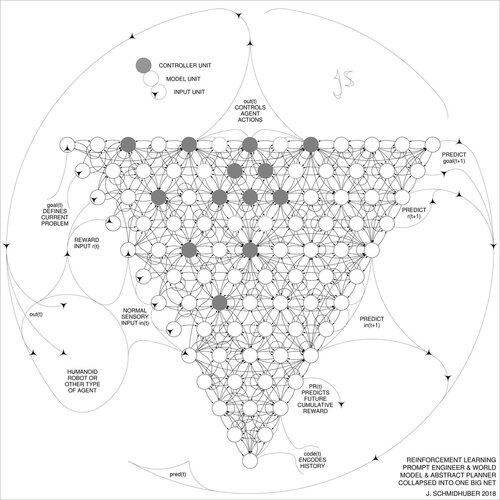

Oppfant prinsipper for meta-læring (1987), GANs (1990), Transformers (1991), veldig dyp læring (1991), etc. Vår AI brukes mange milliarder ganger hver dag.

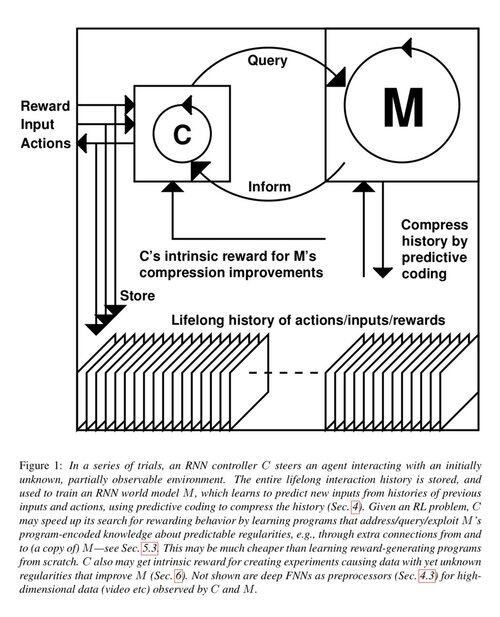

1 tiår siden: Reinforcement Learning Prompt Engineer i avsnitt 5.3 av «Lære å tenke ...» [2]. Adaptiv tankekjede! Et RL-nett lærer å spørre et annet nett for abstrakt resonnement og beslutningstaking. Går utover verdensmodellen fra 1990 for planlegging av millisekund for millisekund [1].

[2] J. Schmidhuber (JS, 2015). «Om å lære å tenke: Algoritmisk informasjonsteori for nye kombinasjoner av RL-kontrollere og tilbakevendende nevrale verdensmodeller.» ArXiv 1210.0118

[1] JS (1990). "Å gjøre verden differensierbar: Om å bruke fullt tilbakevendende selvovervåkede nevrale nettverk for dynamisk forsterkende læring og planlegging i ikke-stasjonære miljøer.» TR FKI-126-90, TUM. (Denne rapporten introduserte også kunstig nysgjerrighet og indre motivasjon gjennom generative kontradiktoriske nettverk.)

23,36K

For 10 år siden, i mai 2015, publiserte vi de første fungerende veldig dype gradientbaserte nevrale nettverkene (FNN) med hundrevis av lag (tidligere FNN-er hadde maksimalt noen få dusin lag). For å overvinne problemet med forsvinningsgradienten brukte våre motorveinettverk de gjenværende forbindelsene som først ble introdusert i 1991 av @HochreiterSepp for å oppnå konstant feilflyt i tilbakevendende NN-er (RNN-er), inngjerdet gjennom multiplikative porter som ligner på glemteportene (Gers et al., 1999) til vår veldig dype LSTM RNN. Highway NNs ble muliggjort gjennom arbeidet til mine tidligere doktorgradsstudenter @rupspace og Klaus Greff. Å sette Highway NN-portene til 1.0 gir oss effektivt ResNet publisert 7 måneder senere.

Dyp læring handler om NN-dybde. LSTM-er brakte i hovedsak ubegrenset dybde til tilbakevendende NN-er; Highway Nets brakte det til feedforward NNs.

20,56K

1991: Første nevrale nettverksdestillasjon [1-3]. Jeg kalte det «kollapsende» den gang, ikke «destillasjon».

Referanser

[1] J. Schmidhuber (1991). Nevrale sekvensdeler. Teknisk rapport FKI-148-91, Tech Univ. München. Seksjon 3.2.2. & Seksjon 4 handler om å "kollapse" eller "destillere" eller "komprimere" kunnskapen om et nevralt nettverk til et annet nevralt nettverk.

[2] JS (1992). Lære komplekse, utvidede sekvenser ved hjelp av prinsippet om historiekomprimering. Nevral beregning, 4(2):234-242, 1992. Basert på [1].

[3] JS (AI-blogg, 2021, oppdatert 2025). 1991: Første veldig dyp læring med uveiledet fortrening. Første nevrale nettverksdestillasjon.

16,05K

Alle snakker om rekursiv selvforbedring og Gödel Machines nå og hvordan dette vil føre til AGI. For en forandring fra 15 år siden! Vi hadde AGI'2010 i Lugano og ledet AGI'2011 hos Google. Ryggraden i AGI-konferansene var matematisk optimal Universal AI: 2003 Gödel Machine (og @mhutter42 AIXI - se hans UAI-bok fra 2005 og dens nylige 2024-oppdatering (Jeg er stolt over at Marcus Hutters AIXI-arbeid ble finansiert av mitt sveitsiske SNF-stipend i 2000 da han var postdoktor ved IDSIA.

57,02K

AGI? En dag, men ikke ennå. Den eneste AI som fungerer bra akkurat nå er den bak skjermen [12-17]. Men å bestå Turing-testen [9] bak en skjerm er enkelt sammenlignet med ekte AI for ekte roboter i den virkelige verden. Ingen nåværende AI-drevet robot kunne sertifiseres som rørlegger [13-17]. Derfor er ikke Turing-testen et godt mål på intelligens (og det er heller ikke IQ). Og AGI uten mestring av den fysiske verden er ingen AGI. Det er derfor jeg opprettet TUM CogBotLab for lærende roboter i 2004 [5], var med på å grunnlegge et selskap for AI i den fysiske verden i 2014 [6], og fikk team ved TUM, IDSIA og nå KAUST til å jobbe mot babyroboter [4,10-11,18]. Slike myke roboter imiterer ikke bare slavisk mennesker, og de fungerer ikke ved å bare laste ned nettet som LLM-er/VLM-er. I stedet utnytter de prinsippene for kunstig nysgjerrighet for å forbedre sine nevrale verdensmodeller (to begreper jeg brukte tilbake i 1990 [1-4]). Disse robotene jobber med mange sensorer, men bare svake aktuatorer, slik at de ikke lett kan skade seg selv [18] når de samler inn nyttige data ved å utarbeide og kjøre sine egne selvoppfunnede eksperimenter.

Bemerkelsesverdig nok har mange siden 1970-tallet gjort narr av mitt gamle mål om å bygge en selvforbedrende AGI smartere enn meg selv og deretter pensjonere seg. I det siste har imidlertid mange endelig begynt å ta dette på alvor, og nå er noen av dem plutselig FOR optimistiske. Disse menneskene er ofte lykkelig uvitende om de gjenværende utfordringene vi må løse for å oppnå ekte AI. Min TED-talk fra 2024 [15] oppsummerer noe av det.

REFERANSER (lett å finne på nettet):

[1] J. Schmidhuber. Gjør verden differensierbar: Om bruk av fullt tilbakevendende selvovervåkede nevrale nettverk (NN) for dynamisk forsterkende læring og planlegging i ikke-stasjonære miljøer. TR FKI-126-90, TUM, februar 1990, revidert november 1990. Denne artikkelen introduserte også kunstig nysgjerrighet og iboende motivasjon gjennom generative kontradiktoriske nettverk der en generator NN kjemper mot en prediktor NN i et minimax-spill.

[2] J. S. En mulighet for å implementere nysgjerrighet og kjedsomhet i modellbyggende nevrale kontrollere. I J. A. Meyer og SW Wilson, redaktører, Proc. av den internasjonale konferansen om simulering av adaptiv atferd: Fra dyr til animater, side 222-227. MIT Press/Bradford Books, 1991. Basert på [1].

[3] JS AI-blogg (2020). 1990: Planlegging og forsterkende læring med tilbakevendende verdensmodeller og kunstig nysgjerrighet. Oppsummering av aspekter ved [1][2] og mange senere artikler, inkludert [7][8].

[4] JS AI-blogg (2021): Kunstig nysgjerrighet og kreativitet siden 1990. Oppsummering av aspekter ved [1][2] og mange senere artikler, inkludert [7][8].

[5] J.S. TU Munich CogBotLab for lærende roboter (2004-2009)

[6] NNAISENSE, grunnlagt i 2014, for AI i den fysiske verden

[7] J.S. (2015). Om å lære å tenke: Algoritmisk informasjonsteori for nye kombinasjoner av forsterkende læring (RL)-kontrollere og tilbakevendende nevrale verdensmodeller. arXiv 1210.0118. Seksjon 5.3 beskriver en RL-promptingeniør som lærer å spørre modellen sin for abstrakt resonnement og planlegging og beslutningstaking. I dag kalles dette «tankekjede».

[8] J.S. (2018). Ett stort nett for alt. arXiv 1802.08864. Se også patent US11853886B2 og min DeepSeek-tweet: DeepSeek bruker elementer fra 2015 reinforcement learning prompt engineer [7] og dens 2018-foredling [8] som kollapser RL-maskinen og verdensmodellen av [7] til ett enkelt nett. Dette bruker min nevrale nettdestillasjonsprosedyre fra 1991: en destillert kjede av tankesystem.

[9] J.S. Turing oversolgte. Det er imidlertid ikke Turings feil. AI-blogg (2021, var #1 på Hacker News)

[10] J.S. Intelligente Roboter werden vom Leben fasziniert sein. (Intelligente roboter vil bli fascinert av livet.) F.A.Z., 2015

[11] J.S. på Falling Walls: The Past, Present and Future of Artificial Intelligence. Scientific American, observasjoner, 2017.

[12] J.S. KI ist eine Riesenchance für Deutschland. (AI er en stor sjanse for Tyskland.) F.A.Z., 2018

[13] H. Jones. JS sier at livsverket hans ikke vil føre til dystopi. Forbes Magazine, 2023.

[14] Intervju med J.S. Jazzyear, Shanghai, 2024.

[15] JS TED-foredrag på TED AI Wien (2024): Hvorfor 2042 vil bli et stort år for AI. Se vedlagte videoklipp.

[16] J.S. Baut den KI-gesteuerten Allzweckroboter! (Bygg den AI-styrte universalroboten!) F.A.Z., 2024

[17] J.S. 1995-2025: Nedgangen til Tyskland og Japan vs USA og Kina. Kan allsidige roboter gi næring til et comeback? AI-blogg, januar 2025, basert på [16].

[18] M. Alhakami, D. R. Ashley, J. Dunham, Y. Dai, F. Faccio, E. Feron, J. Schmidhuber. Mot en ekstremt robust babyrobot med rik interaksjonsevne for avanserte maskinlæringsalgoritmer. Preprint arxiv 2404.08093, 2024.

66,82K

DeepSeek [1] bruker elementer fra 2015 reinforcement learning prompt engineer [2] og dens 2018-foredling [3] som kollapser RL-maskinen og verdensmodellen av [2] til et enkelt nett gjennom nevrale nettdestillasjonsprosedyren fra 1991 [4]: en destillert kjede av tankesystem.

REFERANSER (lett å finne på nettet):

[1] #DeepSeekR1 (2025): Insentiver til resonneringsevne i LLM-er via forsterkende læring. arXiv 2501.12948

[2] J. Schmidhuber (JS, 2015). Om å lære å tenke: Algoritmisk informasjonsteori for nye kombinasjoner av forsterkende læringskontrollere og tilbakevendende nevrale verdensmodeller. arXiv 1210.0118. Seksjon 5.3 beskriver forsterkningslæringsingeniøren (RL) som lærer å aktivt og iterativt spørre modellen for abstrakt resonnement og planlegging og beslutningstaking.

[3] JS (2018). Ett stort nett for alt. arXiv 1802.08864. Se også US11853886B2. Denne artikkelen kollapser forsterkningseleven og verdensmodellen til [2] (f.eks. en grunnmodell) til ett enkelt nettverk, ved å bruke nevrale nettverksdestillasjonsprosedyren fra 1991 [4]. I hovedsak det som nå kalles et RL "Chain of Thought"-system, der påfølgende forbedringer kontinuerlig destilleres til ett enkelt nett. Se også [5].

[4] JS (1991). Lære komplekse, utvidede sekvenser ved hjelp av prinsippet om historiekomprimering. Nevral beregning, 4(2):234-242, 1992. Basert på TR FKI-148-91, TUM, 1991. Først å jobbe dypt lærende basert på et dypt tilbakevendende nevralt netthierarki (med forskjellige selvorganiserende tidsskalaer), overvinne problemet med forsvinnende gradient gjennom uovervåket forhåndstrening (P i CHatGPT) og prediktiv koding. Også: komprimere eller destillere et lærernett (chunkeren) til et elevnett (automatisatoren) som ikke glemmer sine gamle ferdigheter - slike tilnærminger er nå mye brukt. Se også [6].

[5] JS (AI-blogg, 2020). 30-årsjubileum for planlegging og forsterkende læring med tilbakevendende verdensmodeller og kunstig nysgjerrighet (1990, introduserer høydimensjonale belønningssignaler og GAN-prinsippet). Inneholder sammendrag av [2][3] ovenfor.

[6] JS (AI-blogg, 2021). 30-årsjubileum: Første veldig dype læring med uveiledet fortrening (1991) [4]. Uovervåket hierarkisk prediktiv koding finner kompakte interne representasjoner av sekvensielle data for å lette nedstrøms læring. Hierarkiet kan destilleres [4] til et enkelt dypt nevralt nettverk. 1993: Løsning av dybdeproblemer >1000.

786,94K

#NobelPrize i fysikk 2024 for Hopfield & Hinton viser seg å være en Nobelpris for plagiat. De publiserte metoder utviklet i #Ukraine og #Japan av Ivakhnenko og Amari på 1960- og 1970-tallet, så vel som andre teknikker, uten å sitere de opprinnelige oppfinnerne. Ingen av de viktige algoritmene for moderne AI ble laget av Hopfield & Hinton.

I dag slipper jeg en detaljert teknisk rapport om dette [NOB]:

Selvfølgelig fikk jeg det sjekket av nevrale nettverkspionerer og AI-eksperter for å sikre at det var uangripelig.

Er det nå akseptabelt for meg å instruere unge Ph.D.-studenter til å lese gamle artikler og skrive om og sende dem inn på nytt som om de var deres egne verk? Uansett intensjon, sier denne prisen at, ja, det er helt greit.

Noen mennesker har mistet titlene eller jobbene sine på grunn av plagiat, for eksempel Harvards tidligere president [PLAG7]. Men etter denne Nobelprisen, hvordan kan rådgivere nå fortsette å fortelle studentene sine at de bør unngå plagiering for enhver pris?

Det er velkjent at plagiering kan være enten «utilsiktet» eller «forsettlig eller hensynsløs» [PLAG1-6], og den mer uskyldige av de to kan godt være delvis tilfelle her. Men vitenskapen har en veletablert måte å håndtere "multiple discovery" og plagiat på - enten det er utilsiktet [PLAG1-6][CONN21] eller ikke [FAKE,FAKE2] - basert på fakta som tidsstempler for publikasjoner og patenter. Vitenskapens deontologi krever at utilsiktede plagiater korrigerer publikasjonene sine gjennom errata og deretter krediterer originalkildene riktig i fremtiden. Prisvinnerne gjorde det ikke; i stedet fortsatte prisvinnerne å samle inn sitater for oppfinnelser av andre forskere [NOB][DLP]. Gjør ikke denne oppførselen selv utilsiktet plagiering [PLAG1-6] til en tilsiktet form [FAKE2]?

Jeg er veldig bekymret for budskapet dette sender til alle disse unge studentene der ute.

REFERANSER

[NOB] J. Schmidhuber (2024). En Nobelpris for plagiat. Teknisk rapport IDSIA-24-24.

[NOB+] Tweet: #NobelPrize i fysikk 2024 for Hopfield & Hinton belønner plagiat og feil attribusjon i informatikk. Det handler mest om Amaris «Hopfield-nettverk» og «Boltzmann-maskinen». (1/7 like populær som den opprinnelige kunngjøringen fra Nobelstiftelsen)

[DLP] J. Schmidhuber (2023). Hvordan 3 Turing-prisvinnere republiserte nøkkelmetoder og ideer hvis skapere de ikke klarte å kreditere. Teknisk rapport IDSIA-23-23, Swiss AI Lab IDSIA, 14 des 2023.

[DLP+] Tweet for [DLP]:

[PLAG1] Oxfords guide til typer plagiering (2021). Sitat: "Plagiat kan være tilsiktet eller hensynsløst, eller utilsiktet."

[PLAG2] Jackson State Community College (2022). Utilsiktet plagiat.

[PLAG3] R. L. Foster. Unngå utilsiktet plagiering. Tidsskrift for spesialister i pediatrisk sykepleie; Hoboken Vol. 12, Iss. 1, 2007.

[PLAG4] N. Das. Forsettlig eller utilsiktet, det er aldri greit å plagiere: En merknad om hvordan indiske universiteter anbefales å håndtere plagiering. Perspect Clin Res 9:56-7, 2018.

[PLAG5] InfoSci-OnDemand (2023). Hva er utilsiktet plagiat?

[PLAG6] (2022). Hvordan unngå utilsiktet og utilsiktet plagiat (2023). Kopier i Internett-arkivet. Sitat: "Kan det være utilsiktet eller tilsiktet, plagiat er fortsatt plagiat."

[PLAG7] Cornell anmeldelse, 2024. Harvard-president trekker seg i plagiatskandalen. 6. januar 2024.

[FAKE] H. Hopf, A. Krief, G. Mehta, S. A. Matlin. Falsk vitenskap og kunnskapskrisen: uvitenhet kan være dødelig. Royal Society Open Science, mai 2019. Sitat: «Forskere må være villige til å si ifra når de ser falsk informasjon bli presentert i sosiale medier, tradisjonell trykt eller kringkastet presse» og «må snakke ut mot falsk informasjon og falsk vitenskap i omløp og kraftig motsi offentlige personer som fremmer den.»

[FAKE2] L. Stenflo. Intelligente plagiater er de farligste. Nature, vol. 427, s. 777 (februar 2004). Sitat: «Det som er verre, etter min mening, ..., er tilfeller der forskere omskriver tidligere funn med andre ord, med vilje skjuler kildene til ideene sine, og deretter i løpet av de påfølgende årene hevder at de har oppdaget nye fenomener.»

721,84K

Topp

Rangering

Favoritter

Trendende onchain

Trendende på X

Nylig toppfinansiering

Mest lagt merke til