Trendande ämnen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Victor M

🤗 Chef för produkt@huggingface

Victor M delade inlägget

Nu kan du finjustera @Alibaba_Qwen Qwen-Image med AI Toolkit med 24 GB VRAM med hjälp av en specialtränad adapter för återställning av noggrannhet som gör det möjligt att finjustera 3-bitars med minimal precisionsförlust. De markerade ändringarna av standardinställningarna bör fungera för 3090/4090 GPU:er. Mer i 🧵

15,77K

Victor M delade inlägget

Jag gillar verkligen @jandotai

Det är en mycket vänlig app för att lokalt köra LLM:er, perfekt för integriteten

Jag har provat andra som LM Studio och Ollama och de är trevliga men väldigt ingenjörsbyggda, lite för svårt för mig

Jan är enkel och söt och söt och ett bra alternativ att prata med utan att skicka dina data (och hemligheter ;)) till stora AI-leverantörer

Du kan till och med köra fjärrleverantörsmodeller också via API, om du vill ha det!

De är också mycket lyhörda för feedback och förbättrar alltid appen

Jag tror att det finns utrymme för både lokalt drivna LLM-appar och moln LLM-appar, lokalt kört är vettigt om du vill prata om mycket privata saker, terapi etc. Det är verkligen viktigt att människor kan få det utan att vara rädda för att dina data kan läcka ut i framtiden

(Jag är inte ansluten eller betald, bara gillar det verkligen!)

218,33K

Victor M delade inlägget

Vi presenterar Jan-v1: 4B-modell för webbsökning, ett alternativ med öppen källkod till Perplexity Pro.

I våra utvärderingar levererar Jan v1 91 % SimpleQA-noggrannhet, vilket är något bättre än Perplexity Pro samtidigt som den körs helt lokalt.

Användningsområden:

- Sökning på webben

- Djup forskning

Byggd på den nya versionen av Qwens Qwen3-4B-Thinking (upp till 256k kontextlängd), finjusterad för resonemang och verktygsanvändning i januari.

Du kan köra modellen i Jan, llama.cpp eller vLLM. Om du vill aktivera sökning i januari går du till Inställningar → Experimentella funktioner → På och sedan Inställningar → MCP-servrar → aktiverar en sökrelaterad MCP som Serper.

Använd modellen:

- Jan-v1-4B:

- Jan-v1-4B-GGUF:

Tack till @Alibaba_Qwen-teamet för Qwen3 4B Thinking & @ggerganov för llama.cpp.

633,24K

Qwen-bild + Wan-2.2 = 🔥

Victor M12 aug. 06:19

Jag är så hypad att vi nu kan generera videor av den här kvaliteten på under 30 sekunder. Öppen källkod för att vinna!

👇Prova Wan 2.2 (med Lightning LoRA) på Hugging Face

1,2K

Victor M delade inlägget

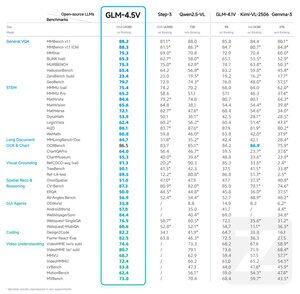

Vi presenterar GLM-4.5V: ett genombrott inom visuellt resonemang med öppen källkod

GLM-4.5V levererar toppmodern prestanda bland modeller med öppen källkod i sin storleksklass och dominerar i 41 benchmarks.

GLM-4.5V är byggd på basmodellen GLM-4.5-Air och ärver beprövade tekniker från GLM-4.1V-Thinking samtidigt som den uppnår effektiv skalning genom en kraftfull MoE-arkitektur med 106B-parametrar.

Krammande ansikte:

GitHub:

Application Programming Interface:

Prova det nu:

264,76K

Topp

Rankning

Favoriter

Trendande på kedjan

Trendande på X

Senaste toppfinansieringarna

Mest anmärkningsvärda