المواضيع الرائجة

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Victor M

🤗 رئيس @huggingface المنتج

Victor M أعاد النشر

يمكنك الآن ضبط @Alibaba_Qwen Qwen-Image باستخدام مجموعة أدوات الذكاء الاصطناعي مع 24 جيجابايت من VRAM باستخدام محول استرداد الدقة المدرب المخصص الذي يسمح لك بالضبط الدقيق عند 3 بت بأقل قدر من فقدان الدقة. يجب أن تعمل التغييرات المميزة على الإعدادات الافتراضية مع وحدات معالجة الرسومات 3090/4090. المزيد في 🧵

15.77K

Victor M أعاد النشر

أنا حقا أحب @jandotai

إنه تطبيق ودود للغاية لتشغيل LLMs محليا ، وهو رائع للخصوصية

لقد جربت آخرين مثل LM Studio و Ollama وهم لطيفون ولكنهم مبنون من قبل المهندسين للغاية ، وصعب بعض الشيء بالنسبة لي

Jan بسيط ولطيف وجميل وبديل رائع للتحدث معه دون إرسال بياناتك (وأسرارك ;)) إلى مزودي الذكاء الاصطناعي الكبار

يمكنك حتى تشغيل نماذج المزودين عن بعد أيضا عبر واجهة برمجة التطبيقات ، إذا كنت تريد ذلك!

كما أنهم يستجيبون للغاية للتعليقات ويحسنون التطبيق دائما

أعتقد أن هناك مساحة لكل من تطبيقات LLM التي يتم تشغيلها محليا وتطبيقات LLM السحابية ، والتشغيل محليا أمر منطقي إذا كنت تريد التحدث عن أشياء خاصة جدا ، والعلاج وما إلى ذلك. من المهم حقا أن يحصل الأشخاص على ذلك دون خوف من تسرب بياناتك في المستقبل

(أنا لست تابعا أو مدفوعا ، فقط أحب ذلك حقا!)

218.32K

Victor M أعاد النشر

نقدم لكم Jan-v1: نموذج 4B لبحث الويب ، وهو بديل مفتوح المصدر ل Perplexity Pro.

في evals الخاصة بنا ، يوفر Jan v1 دقة SimpleQA بنسبة 91٪ ، متفوقا قليلا على Perplexity Pro أثناء التشغيل محليا بالكامل.

حالات الاستخدام:

- البحث على الويب

- البحث العميق

مبني على الإصدار الجديد من Qwen's Qwen3-4B-Thinking (يصل طول السياق إلى 256 كيلوبايت) ، تم ضبطه بدقة للتفكير واستخدام الأداة في يناير.

يمكنك تشغيل النموذج في يناير أو llama.cpp أو vLLM. لتمكين البحث في يناير، انتقل إلى الإعدادات → الميزات التجريبية → تشغيل، ثم → تمكين الإعدادات → خوادم MCP لتمكين MCP مرتبط بالبحث مثل Serper.

استخدم النموذج:

- يناير v1-4B:

- يناير v1-4B-GGUF:

الفضل في فريق @Alibaba_Qwen ل Qwen3 4B Thinking & @ggerganov for llama.cpp.

633.24K

صورة Qwen + Wan-2.2 = 🔥

Victor M12 أغسطس، 06:19

أنا متحمس جدا لدرجة أنه يمكننا الآن إنشاء مقاطع فيديو بهذه الجودة في أقل من 30 ثانية. مفتوح المصدر للفوز!

👇جرب Wan 2.2 (مع Lightning LoRA) على Hugging Face

1.19K

Victor M أعاد النشر

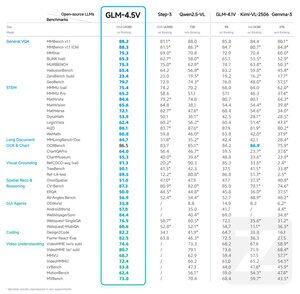

تقديم GLM-4.5V: طفرة في التفكير البصري مفتوح المصدر

يوفر GLM-4.5V أداء متطورا بين الموديلات مفتوحة المصدر في فئة حجمها ، حيث يهيمن على 41 معيارا قياسيا.

تم بناء GLM-4.5V على طراز قاعدة GLM-4.5-Air ، ويرث تقنيات مجربة من GLM-4.1V-Thinking مع تحقيق التوسع الفعال من خلال بنية MoE قوية ذات المعلمة 106B.

معانقة الوجه:

جيت هب:

واجهة برمجة التطبيقات:

جربه الآن:

264.76K

الأفضل

المُتصدِّرة

التطبيقات المفضلة

رائج على السلسة

رائج على منصة X

أهم عمليات التمويل الأخيرة

الأبرز