Tópicos em alta

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Victor M

🤗 Chefe de @huggingface de Produto

Victor M repostou

Agora você pode ajustar @Alibaba_Qwen Qwen-Image com AI Toolkit com 24 GB de VRAM usando um adaptador de recuperação de precisão treinado personalizado que permite ajustar em 3 bits com perda mínima de precisão. As alterações marcadas nos padrões devem funcionar para GPUs 3090/4090. Mais em 🧵

15,77K

Victor M repostou

Eu realmente gosto @jandotai

É um aplicativo muito amigável para executar LLMs localmente, ótimo para privacidade

Eu tentei outros como LM Studio e Ollama e eles são bons, mas muito construídos por engenheiros, um pouco difíceis demais para mim

Jan é simples, fofo e bonito e uma ótima alternativa para conversar sem enviar seus dados (e segredos ;)) para grandes provedores de IA

Você também pode executar modelos de provedores remotos via API, se quiser!

Além disso, eles são muito responsivos ao feedback e sempre melhoram o aplicativo

Acho que há espaço para aplicativos LLM executados localmente e aplicativos LLM em nuvem, executados localmente faz sentido se você quiser falar sobre coisas muito privadas, terapia etc. É muito importante que as pessoas possam ter isso sem temer que seus dados possam vazar no futuro

(Eu não sou afiliado ou pago, apenas gosto muito!)

218,32K

Victor M repostou

Apresentando Jan-v1: modelo 4B para pesquisa na web, uma alternativa de código aberto ao Perplexity Pro.

Em nossas avaliações, o Jan v1 oferece 91% de precisão do SimpleQA, superando ligeiramente o Perplexity Pro durante a execução totalmente local.

Casos de uso:

- Pesquisa na Web

- Pesquisa Profunda

Construído na nova versão do Qwen3-4B-Thinking da Qwen (até 256k de comprimento de contexto), ajustado para raciocínio e uso de ferramentas em janeiro.

Você pode executar o modelo em Jan, llama.cpp ou vLLM. Para ativar a pesquisa em janeiro, vá para Configurações → Recursos experimentais → Ativado e, em seguida, Configurações → servidores MCP → ativar um MCP relacionado à pesquisa, como Serper.

Use o modelo:

- Jan-v1-4B:

- Jan-v1-4B-GGUF:

Crédito à equipe @Alibaba_Qwen para Qwen3 4B Thinking & @ggerganov para llama.cpp.

633,24K

Qwen-Imagem + Wan-2.2 = 🔥

Victor M12 de ago., 06:19

Estou tão empolgado que agora podemos gerar vídeos dessa qualidade em menos de 30 segundos. Código aberto para a vitória!

👇Experimente o Wan 2.2 (com Lightning LoRA) no Hugging Face

1,19K

Victor M repostou

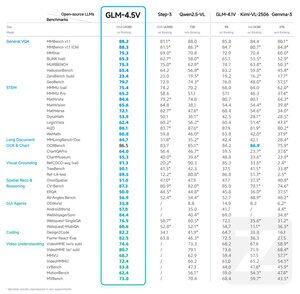

Apresentando o GLM-4.5V: um avanço no raciocínio visual de código aberto

O GLM-4.5V oferece desempenho de última geração entre os modelos de código aberto em sua classe de tamanho, dominando 41 benchmarks.

Construído no modelo de base GLM-4.5-Air, o GLM-4.5V herda técnicas comprovadas do GLM-4.1V-Thinking, ao mesmo tempo em que alcança um dimensionamento eficaz por meio de uma poderosa arquitetura MoE de 106 parâmetros B.

Rosto abraçando:

GitHub:

API:

Experimente agora:

264,76K

Melhores

Classificação

Favoritos

Em alta on-chain

Em alta no X

Principais fundos da atualidade

Mais notável